统一视觉理解与生成,MetaMorph模型问世,LeCun、谢赛宁、刘壮等参与

统一视觉理解与生成,MetaMorph模型问世,LeCun、谢赛宁、刘壮等参与如今,多模态大模型(MLLM)已经在视觉理解领域取得了长足进步,其中视觉指令调整方法已被广泛应用。该方法是具有数据和计算效率方面的优势,其有效性表明大语言模型(LLM)拥有了大量固有的视觉知识,使得它们能够在指令调整过程中有效地学习和发展视觉理解。

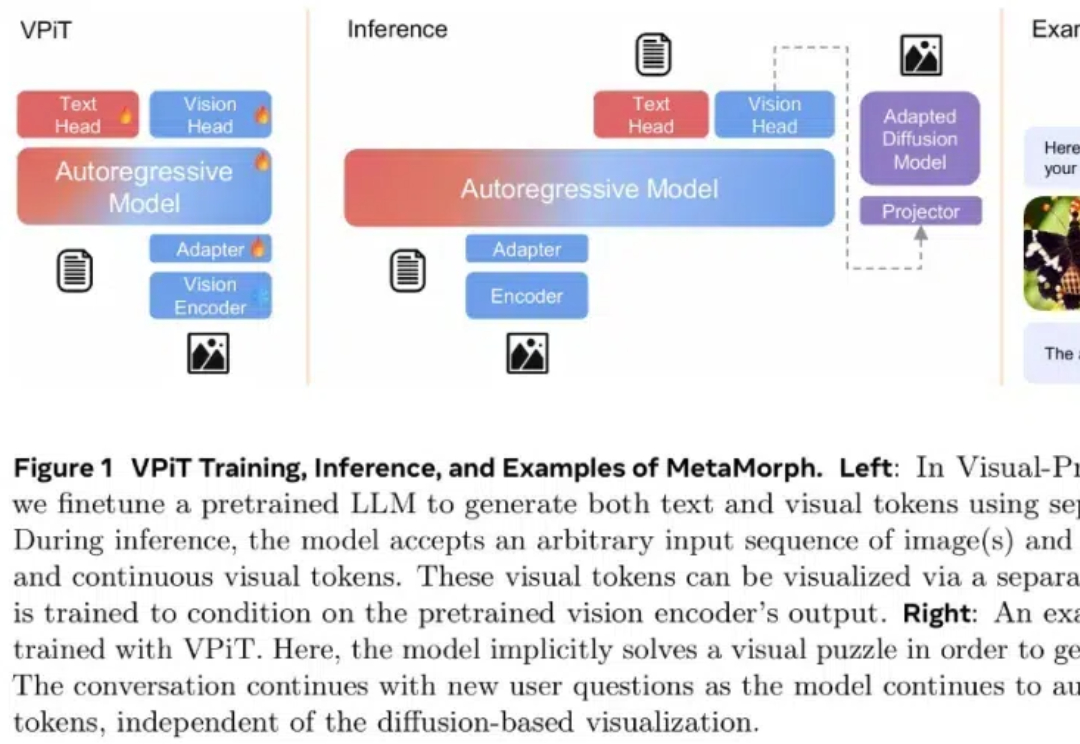

如今,多模态大模型(MLLM)已经在视觉理解领域取得了长足进步,其中视觉指令调整方法已被广泛应用。该方法是具有数据和计算效率方面的优势,其有效性表明大语言模型(LLM)拥有了大量固有的视觉知识,使得它们能够在指令调整过程中有效地学习和发展视觉理解。

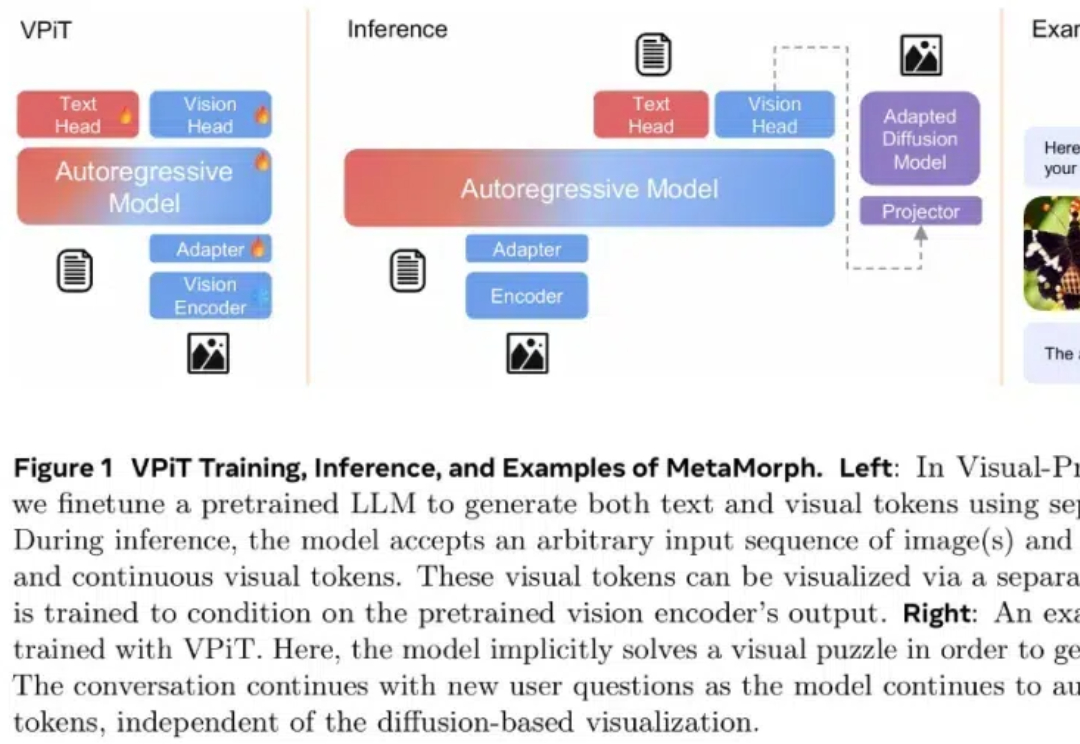

Meta斯坦福大学联合团队全面研究多模态大模型(LMM)中驱动视频理解的机制,扩展了视频多模态大模型的设计空间,提出新的训练调度和数据混合方法,并通过语言先验或单帧输入解决了已有的评价基准中的低效问题。

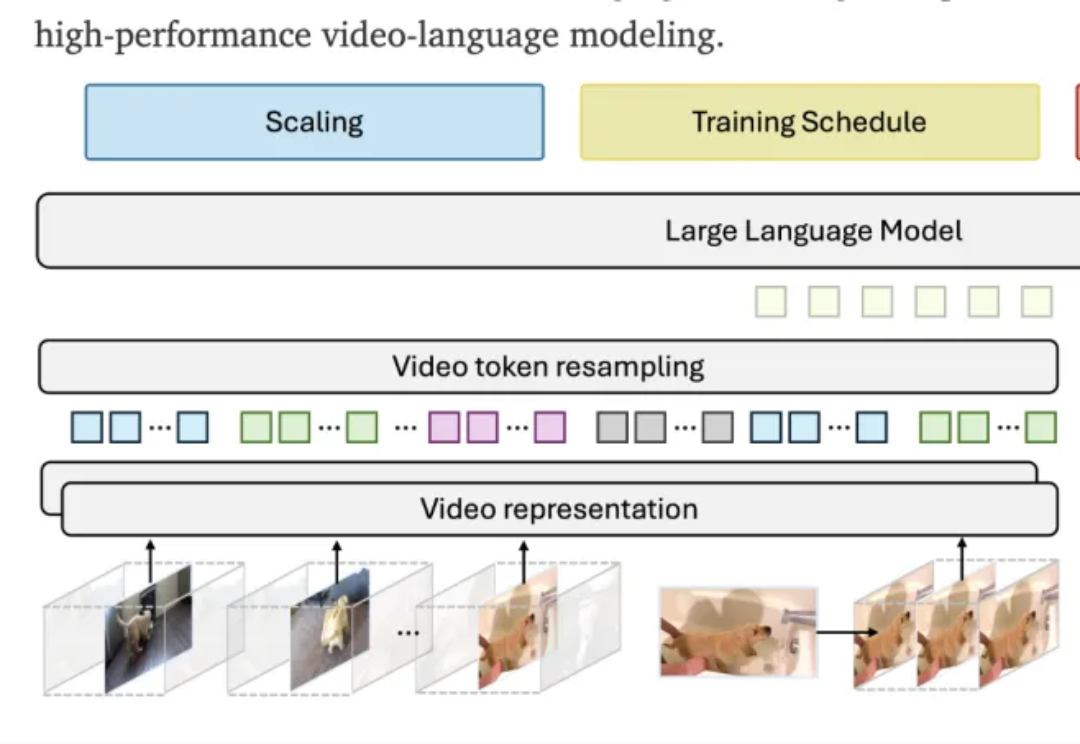

本文中,香港大学与 Adobe 联合提出名为 UniReal 的全新图像编辑与生成范式。该方法将多种图像任务统一到视频生成框架中,通过将不同类别和数量的输入/输出图像建模为视频帧,从大规模真实视频数据中学习属性、姿态、光照等多种变化规律,从而实现高保真的生成效果。

AutoPatent框架能够自动化生成高质量的专利文档,大幅提高专利撰写效率,有望简化专利申请流程,降低成本,促进创新保护。

自2022年年末OpenAI发布ChatGPT以来,英伟达的市值就上涨了近5倍,甚至超越苹果成为了全球最值钱的公司。眼看着英伟达如今能够让OpenAI、Meta、xAI等一众AI厂商排队交钱,也就使得越来越多的公司想成为此次AI淘金热中的“卖水人”。

面对AI圈疯传的「数据如化石燃料一般正在枯竭」,我们该如何从海量数据中掘金?AI炼出的数据飞轮2.0,或许就是答案。

大模型的开源与闭源之争至今仍是热议话题,毕竟讨论核心触及技术发展路径、产业生态构建,以及对未来创新动力的影响。

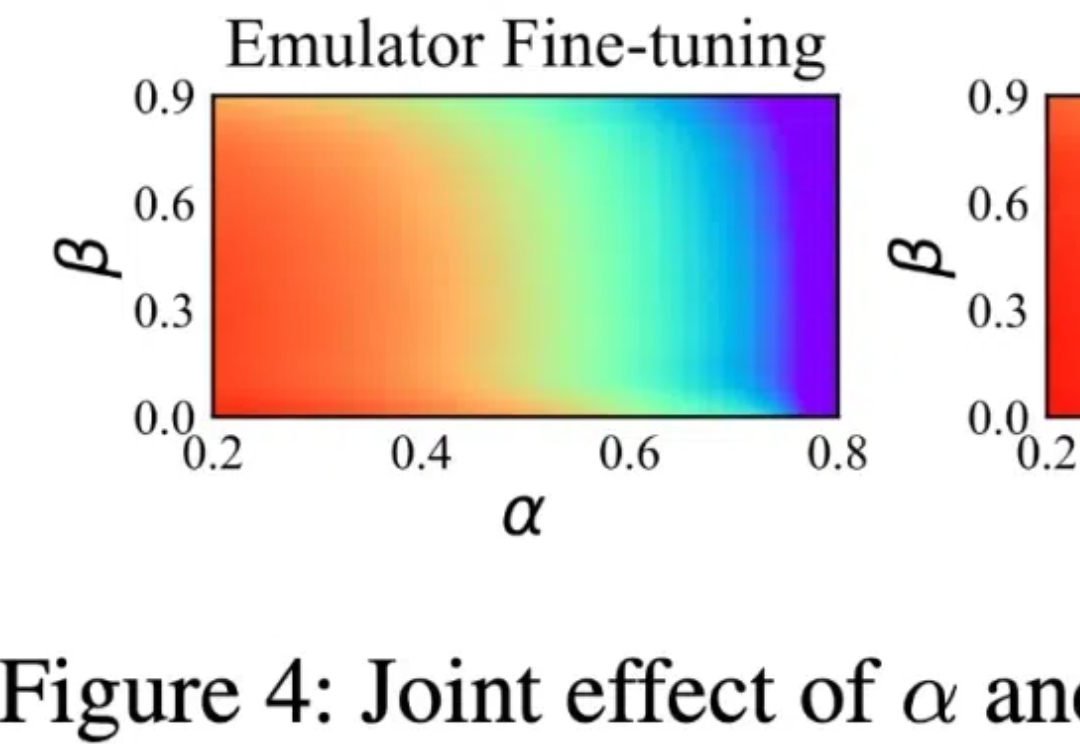

要让大模型适应各不一样的下游任务,微调必不可少。常规的中心化微调过程需要模型和数据存在于同一位置 —— 要么需要数据所有者上传数据(这会威胁到数据所有者的数据隐私),要么模型所有者需要共享模型权重(这又可能泄露自己花费大量资源训练的模型)。

清华大学与国家蛋白质科学中心的最新成果,结合了稳定学习的理论,提出了一个面向多中心、大队列异质数据的「稳定」生存分析方法。

12月18日,记者从深圳市工业和信息化局了解到,深圳拟出台若干措施,积极建设国家新一代人工智能创新发展试验区和国家人工智能创新应用先导区,打造人工智能先锋城市。其中,在丰富生态要素供给方面,每年发放最高5亿元“训力券”,降低人工智能模型研发和训练成本。同时每年发放最高5000万元“语料券”,促进语料开放共享和交易,推动数据要素市场建设。