第一个吃到DeepSeek红利的AI图像产品出现了?

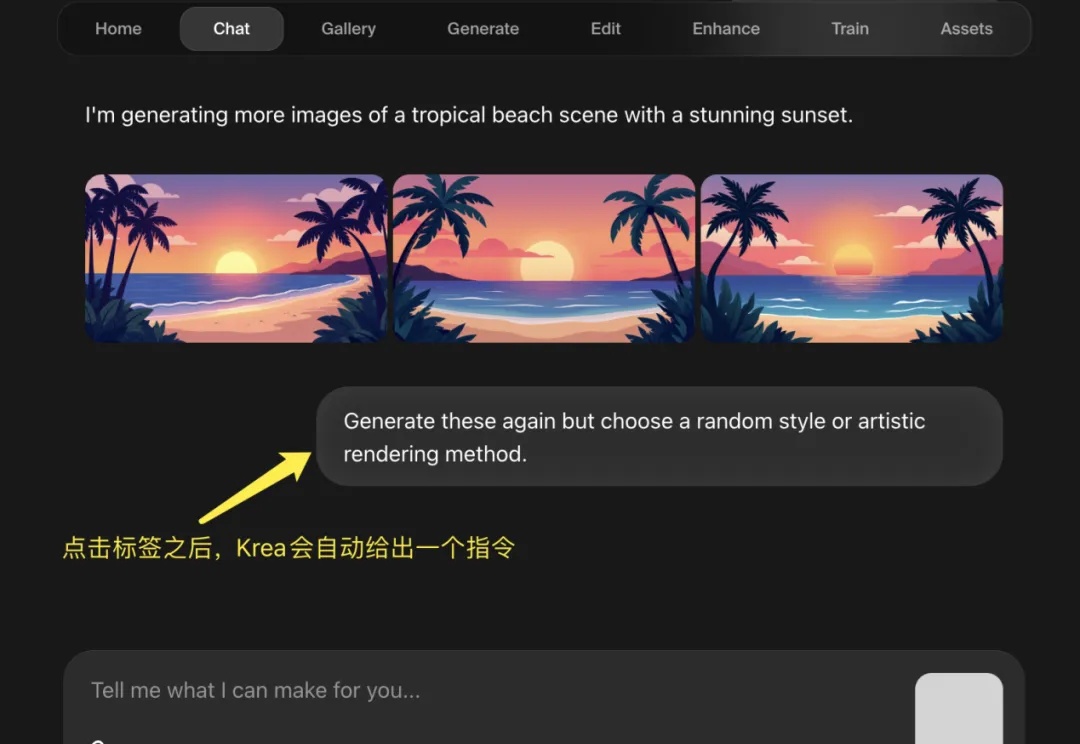

第一个吃到DeepSeek红利的AI图像产品出现了?在 R1 推理模型大火之后,全民接力集成 DeepSeek,有硅基流动这样的大模型云服务平台、有腾讯元宝这样的 Chatbot,甚至微信这样的顶流。但是,AI 图片类产品却鲜少有接入 DeepSeek R1 的新闻,而从 DeepSeek-R1 发布到 Krea 宣布上线新功能仅仅 10 天,这个反应应该是图像产品中最快的。

在 R1 推理模型大火之后,全民接力集成 DeepSeek,有硅基流动这样的大模型云服务平台、有腾讯元宝这样的 Chatbot,甚至微信这样的顶流。但是,AI 图片类产品却鲜少有接入 DeepSeek R1 的新闻,而从 DeepSeek-R1 发布到 Krea 宣布上线新功能仅仅 10 天,这个反应应该是图像产品中最快的。

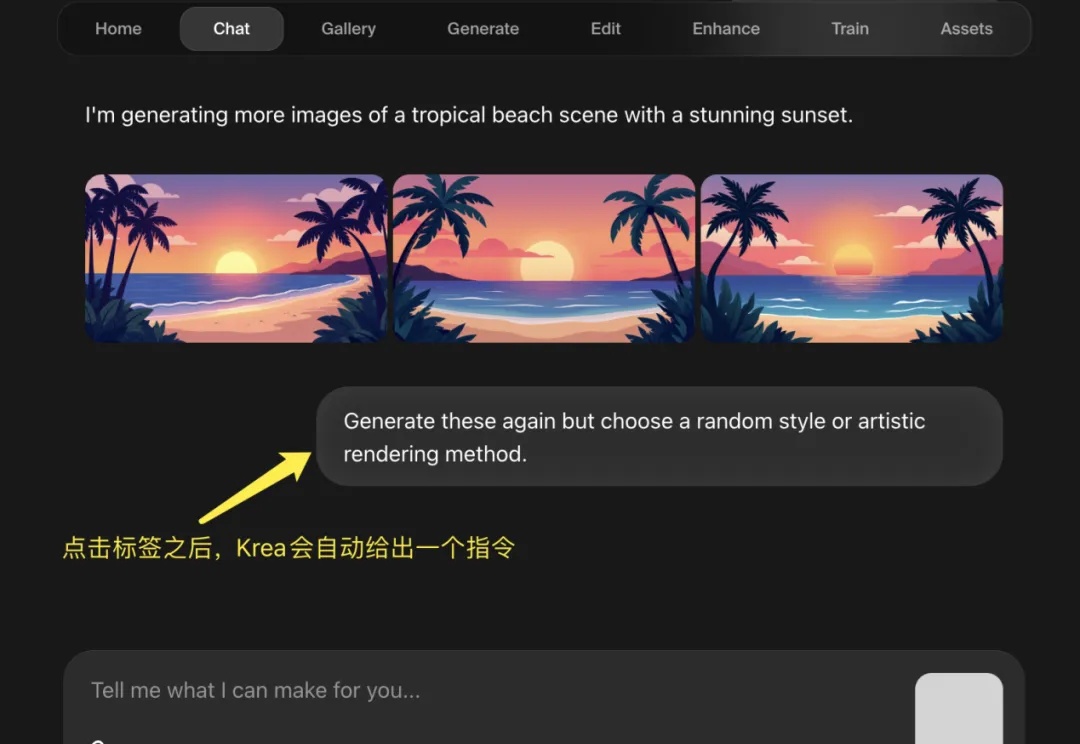

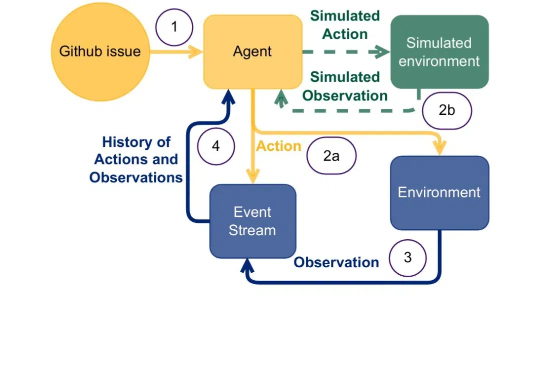

随着R1等先进推理模型展现出接近人类的推理能力,多代理系统(Multi-Agent Systems,MAS)的发展也出现了前所未有的机遇。然而,随着我们尝试构建越来越复杂的多代理系统,一个核心问题日益凸显:如何在保持系统灵活性的同时,降低开发和维护的复杂度?

上周DeepSeek连续5天开源硬核技术,阿里开源万相2.1,Qwen的推理模型推出预览版,但是肯定马上也要开源。而今天,智谱这个曾经的开源之光,在昨天官宣拿了杭州10亿融资之后,在官宣文章里如此写道:

继上周发布全球首个混合推理模型 Claude 3.7 Sonnet 之后,Anthropic 又迎来了一个好消息。今天凌晨,Anthropic 官宣完成 E 轮融资,筹集到了 35 亿美元,投后估值 615 亿美元。

原来,大型推理模型(Large Reasoning Model,LRM)像人一样,在「用脑过度」也会崩溃,进而行动能力下降。

OpenAI的重磅炸弹GPT-4.5,刚刚如期上线了!它并不是推理模型,但是规模最大、知识最丰富,最鲜明的特点就是情商高、很类人。Pro版用户和付费开发者已经能用了,但token定价有点离谱。

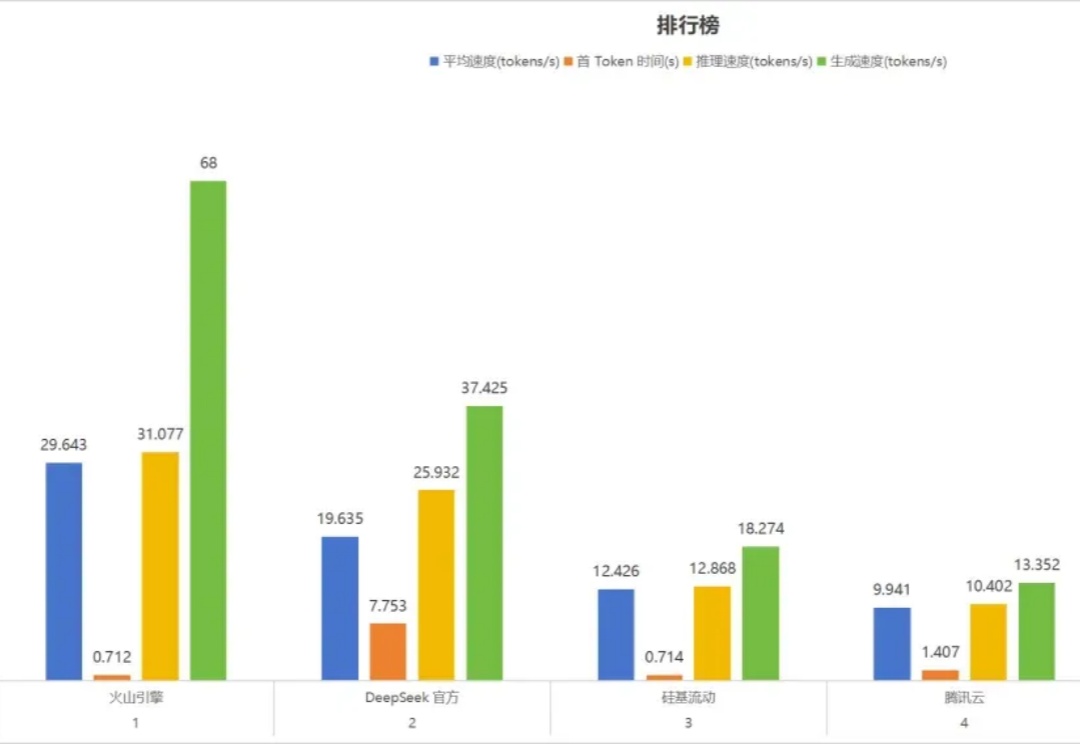

部署 DeepSeek 系列模型,尤其是推理模型 DeepSeek-R1,已经成为一股不可忽视的潮流。

AI开源潮涌现,推理模型成主流。

自动形式化数学定理证明,是人工智能在数学推理领域的重要应用方向。此类任务需要将数学命题和证明步骤转化为计算机可验证的代码,这不仅能确保推理过程的绝对严谨性,还能构建可复用的数学知识库,为科学研究提供坚实基础。

推理黑马出世,仅以5%参数量撼动AI圈。360、北大团队研发的中等量级推理模型Tiny-R1-32B-Preview正式亮相,32B参数,能够匹敌DeepSeek-R1-671B巨兽。