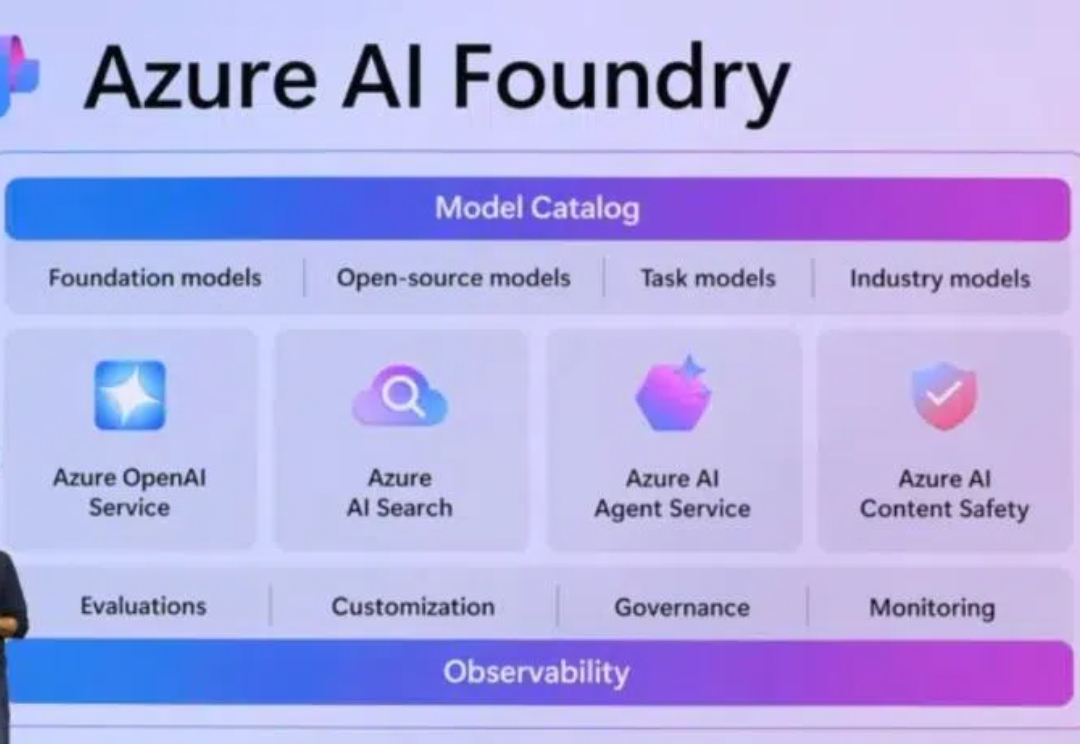

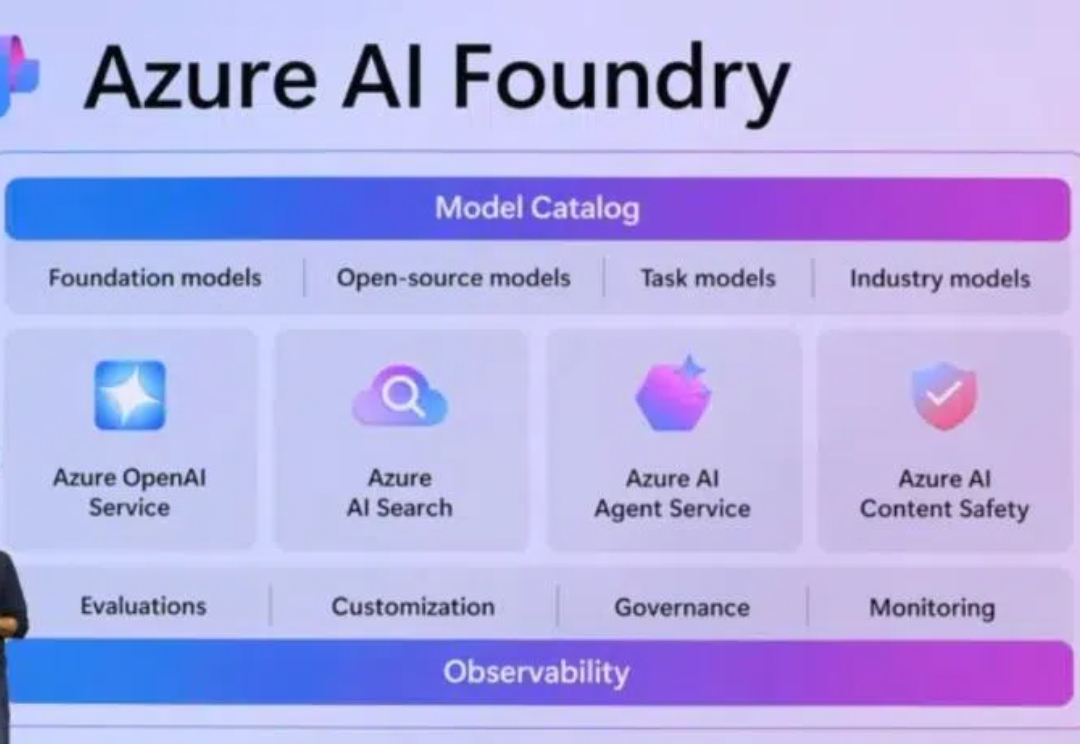

全球最大AI Agent生态系统来了,适配超1800个模型

全球最大AI Agent生态系统来了,适配超1800个模型5款预构建Agent、数百万AI协作前景。

5款预构建Agent、数百万AI协作前景。

领头羊企业OpenAI刚获得66亿美元融资,估值达到1570亿美元,成为究极独角兽。紧跟其后,xAI、Perplexity、Anthropic等明星创企也开始新一轮的大额融资,xAI的估值更是冲向了450亿美元。三年过去,生成式AI热潮经久不衰,依然是当下最热门投资方向。

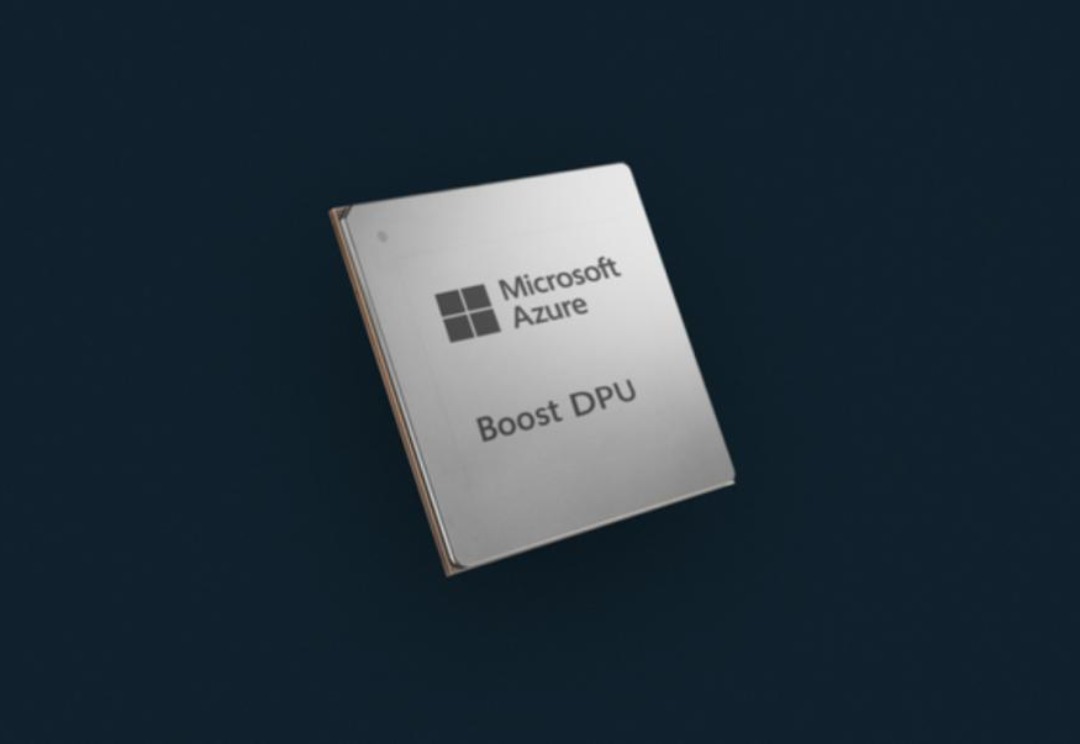

在今天的Ignite开发者大会上,微软发布了两款专为其数据中心基础设施设计的新芯片:Azure Integrated HSM和Azure Boost DPU。

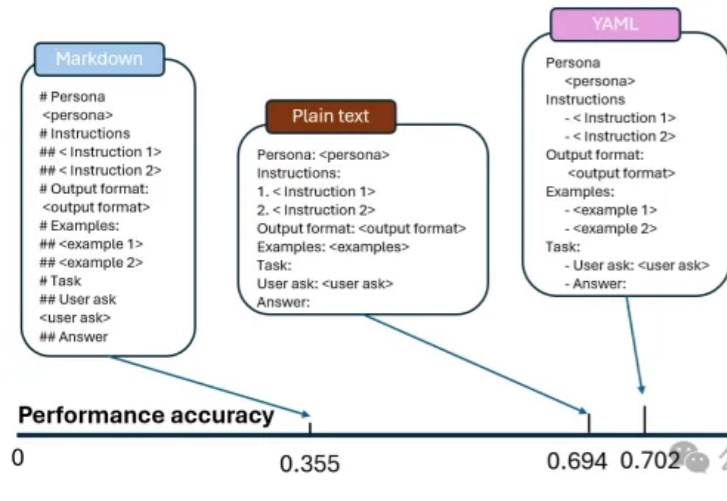

朋友们,想了解为什么同一模型会带来大量结果的不一致性吗?今天,我们来一起深入分析一下来自微软和麻省理工学院的一项重大发现——不同的Prompt格式如何显著影响LLM的输出精度。这些研究结果对于应用Prompt优化设计具有非常重要的应用价值。

用AI大模型一键解析MRI、CT和病理学等九大生物医学成像模式。

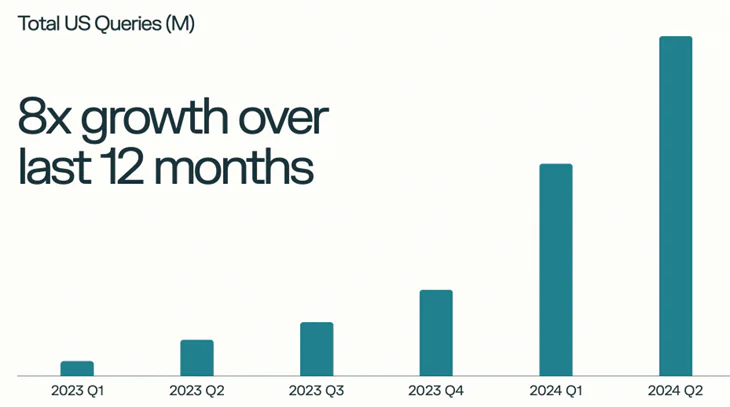

10月28日,The Information报道称,Meta正在研发自己的“AI驱动搜索引擎”,以减少对谷歌和微软Bing搜索的依赖。Meta的搜索,将通过生成式AI对用户输入的关键词或者prompt进行摘要和总结。

卷到没边了,122天交付10卡超算,马斯克造Colossus的神奇速度,直接把对手们干懵逼了!OpenAI和微软甚至因此谈崩了。现在,超算大战干脆升级为谍战模式,对手直接派出飞机悬空侦查。

近日,来自微软的研究人员开源了使用全新方法训练的MoE大模型,不走寻常路,且编码和数学表现出色。

历时四年,微软亚研院AI for Science团队发布AI驱动的从头算(ab initio)生物分子动力学模拟系统。 直接登上Nature正刊。

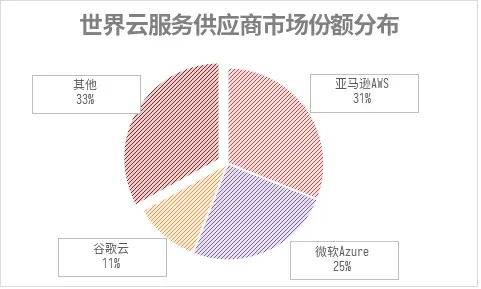

微软和Google在同一天发布的最新财报,AI都作为云增长的重点,但却是截然不同的两种路径。