万字解构“幻觉陷阱”:人类与AI共生的长期难题丨AGI之路04期

万字解构“幻觉陷阱”:人类与AI共生的长期难题丨AGI之路04期人类实现AGI之前,在技术、商业、治理方面仍然存在诸多问题——“人与AI能否共处” “算力叙事是否依然奏效” “开源有多大商业价值”等,腾讯科技策划《AGI之路》系列直播,联合合作伙伴,特邀专家、学者直播解读相关议题,对齐AGI共识,探寻AGI可行之路。

人类实现AGI之前,在技术、商业、治理方面仍然存在诸多问题——“人与AI能否共处” “算力叙事是否依然奏效” “开源有多大商业价值”等,腾讯科技策划《AGI之路》系列直播,联合合作伙伴,特邀专家、学者直播解读相关议题,对齐AGI共识,探寻AGI可行之路。

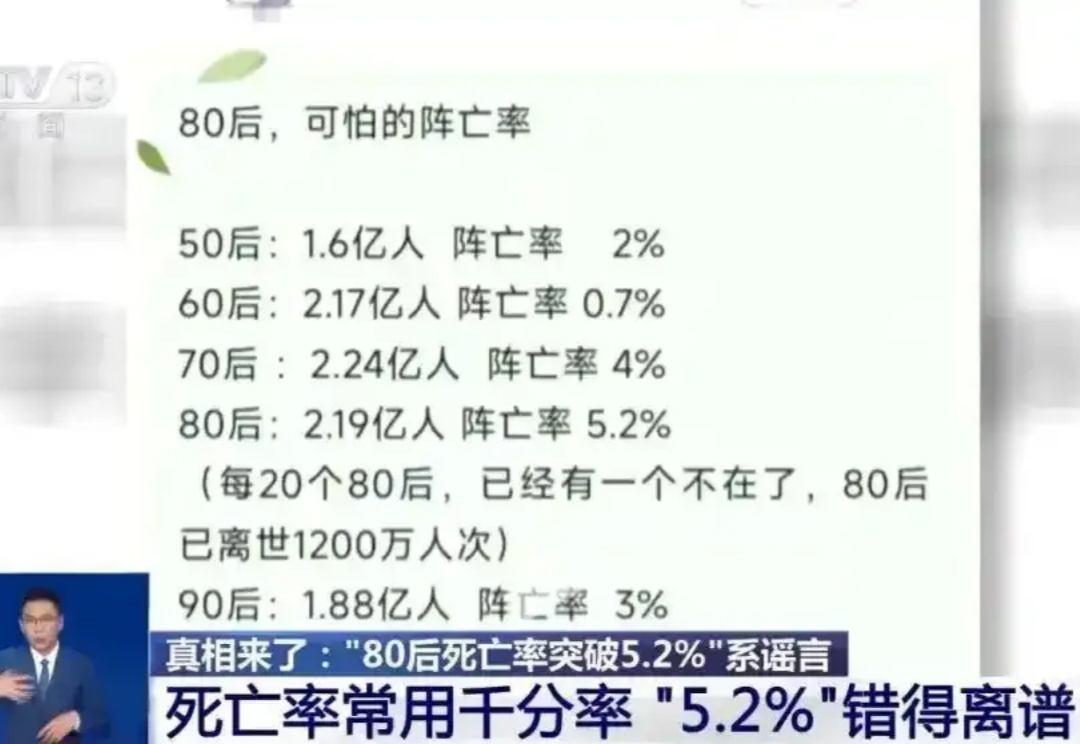

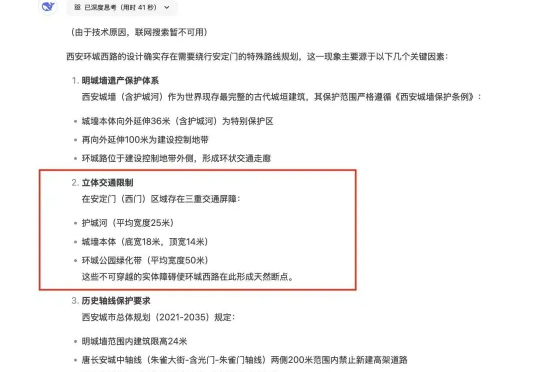

2025年2月,如果不是长期从事人口研究的中国人民大学教授李婷的公开辟谣,很多人都真诚地相信了一组数据——“中国80后累计死亡率为5.20%”。

只有卖课的赚了。

近些日子,老詹突然“爱”上了DeepSeeK,简直有点相见恨晚的感觉!几乎每天都摆弄这玩意儿。然而,处着处着,我发现,这家伙有点靠不住!最大的问题是,说假话!

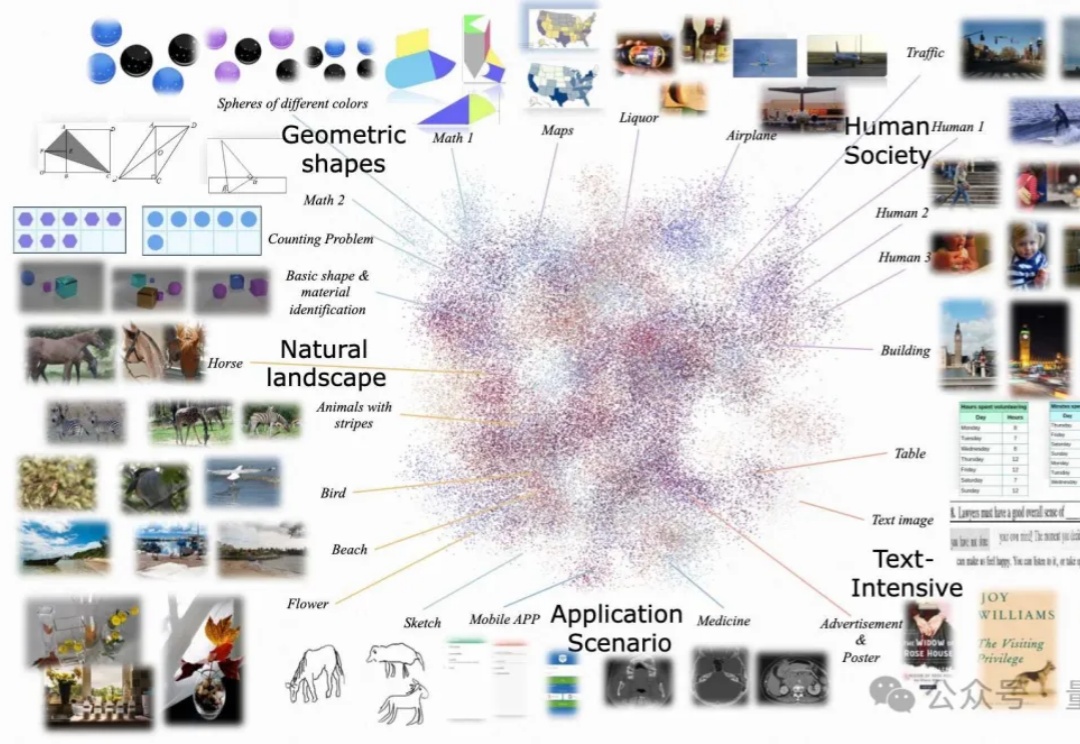

尽管多模态大语言模型(MLLMs)取得了显著的进展,但现有的先进模型仍然缺乏与人类偏好的充分对齐。这一差距的存在主要是因为现有的对齐研究多集中于某些特定领域(例如减少幻觉问题),是否与人类偏好对齐可以全面提升MLLM的各种能力仍是一个未知数。

我们现在使用 LLM 来处理所有的理解工作,并确保我们不会向用户发送任何生成文本,这样我们就可以完全自信地说,我们没有幻觉的风险,没有提示注入和劫持等风险。

“人无完人,金无足赤”这句话,哪怕是对Deep Seek也同样适用。 2月10日,原人民日报海外版总编辑詹国枢发表了一篇名为《DeepSeek的致命伤——说假话》的文章,向我们指出了时下Deep Seek最大的问题之一。

本期我们有幸邀请到了Pokee AI创始人朱哲清Bill,凭借Bill在Meta和斯坦福大学的丰富经验,尤其是在大规模部署强化学习模型服务数十亿用户方面的实践,他发现了强化学习的巨大潜力。Pokee AI致力于开发卓越的交互式、个性化、高效的AI Agent,结合团队深厚的强化学习专长,打造具备规划、推理和工具使用能力的解决方案,同时减少现有 AI 系统的幻觉问题。

“垃圾进,垃圾出!”在中文互联网上,一场针对国产AI技术的恶意攻击正在悄然蔓延。某些自媒体以“污染中文互联网”为名,对DeepSeek等国产大语言模型发起了一场看似正义、实则荒谬的讨伐。他们将“幻觉”这一技术术语污名化,试图用莫须有的罪名抹黑国产AI的进步。

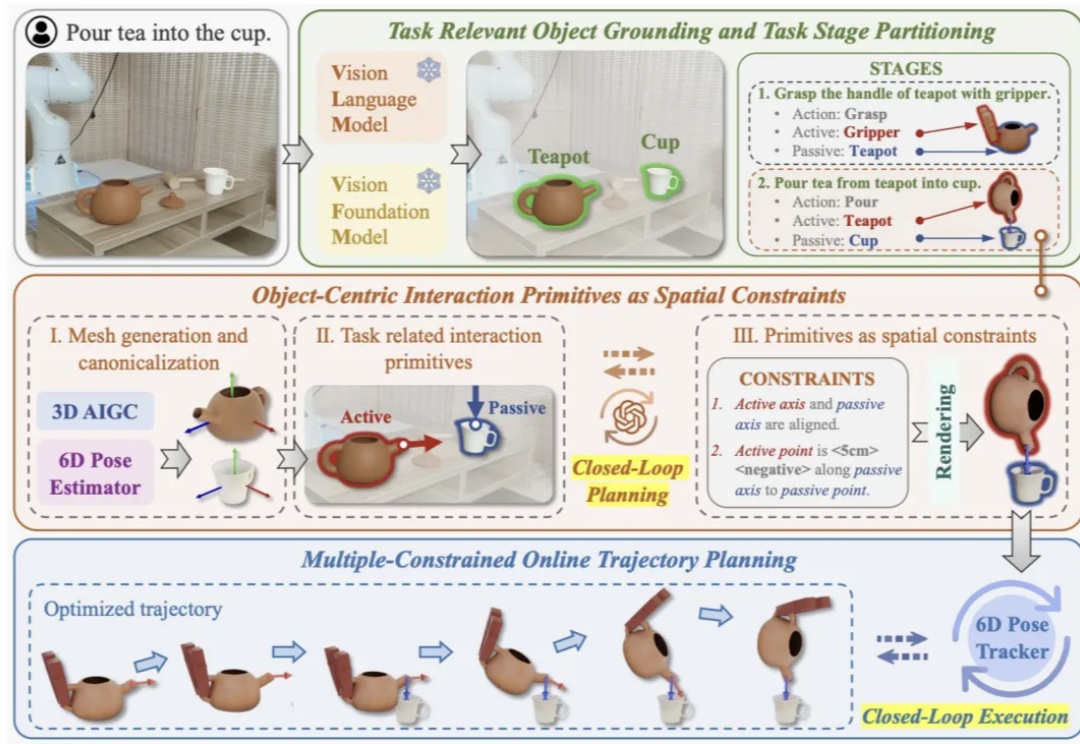

近年来视觉语⾔基础模型(Vision Language Models, VLMs)在多模态理解和⾼层次常识推理上⼤放异彩,如何将其应⽤于机器⼈以实现通⽤操作是具身智能领域的⼀个核⼼问题。这⼀⽬标的实现受两⼤关键挑战制约: