14B 小模型逆袭翻译赛道,论文财报实测超Claude,不信试试“我命由我不由天”

14B 小模型逆袭翻译赛道,论文财报实测超Claude,不信试试“我命由我不由天”都说通用大模型轻松拿捏翻译,结果有人来掀桌了。

都说通用大模型轻松拿捏翻译,结果有人来掀桌了。

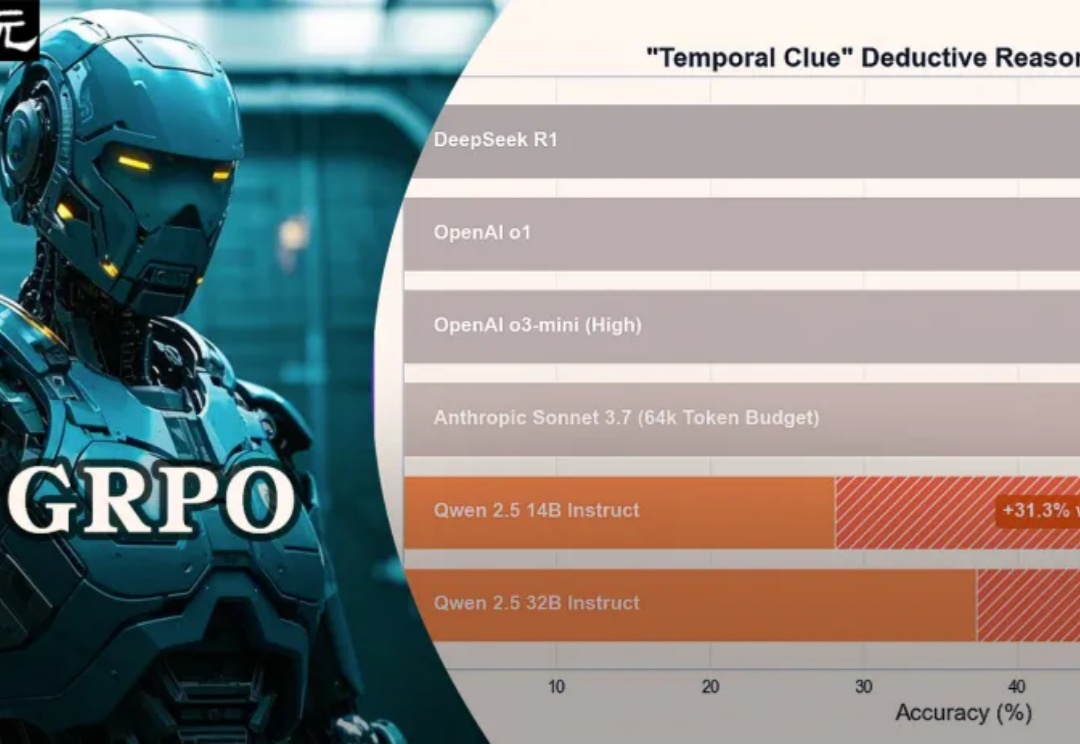

32B小模型在超硬核「时间线索」推理谜题中,一举击败了o1、o3-mini、DeepSeek-R1,核心秘密武器便是GRPO,最关键的是训练成本暴降100倍。

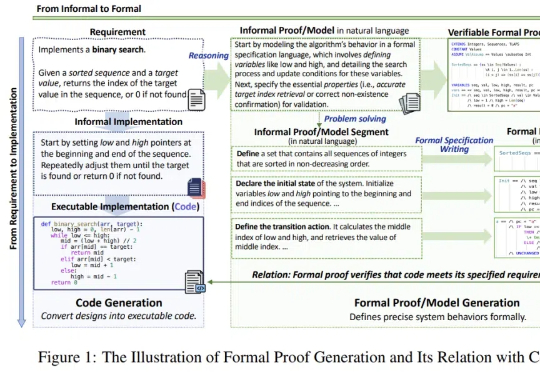

随着 DeepSeek-R1 的流行与 AI4Math 研究的深入,大模型在辅助形式化证明写作方面的需求日益增长。作为数学推理最直接的应用场景,形式化推理与验证(formal reasoning and verification),也获得持续关注。

动辄百亿、千亿参数的大模型正在一路狂奔,但「小而美」的模型也在闪闪发光。

只刷逻辑益智题,竟能让 AI 数学竞赛水平大幅提升?

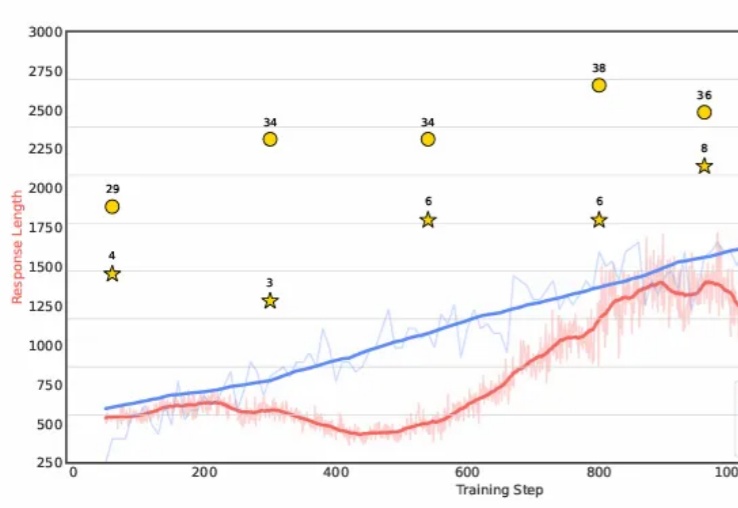

强化学习训练数据越多,模型推理能力就越强?新研究提出LIM方法,揭示提升推理能力的关键在于优化数据质量,而不是数据规模。该方法在小模型上优势尽显。从此,强化学习Scaling Law可能要被改写了!

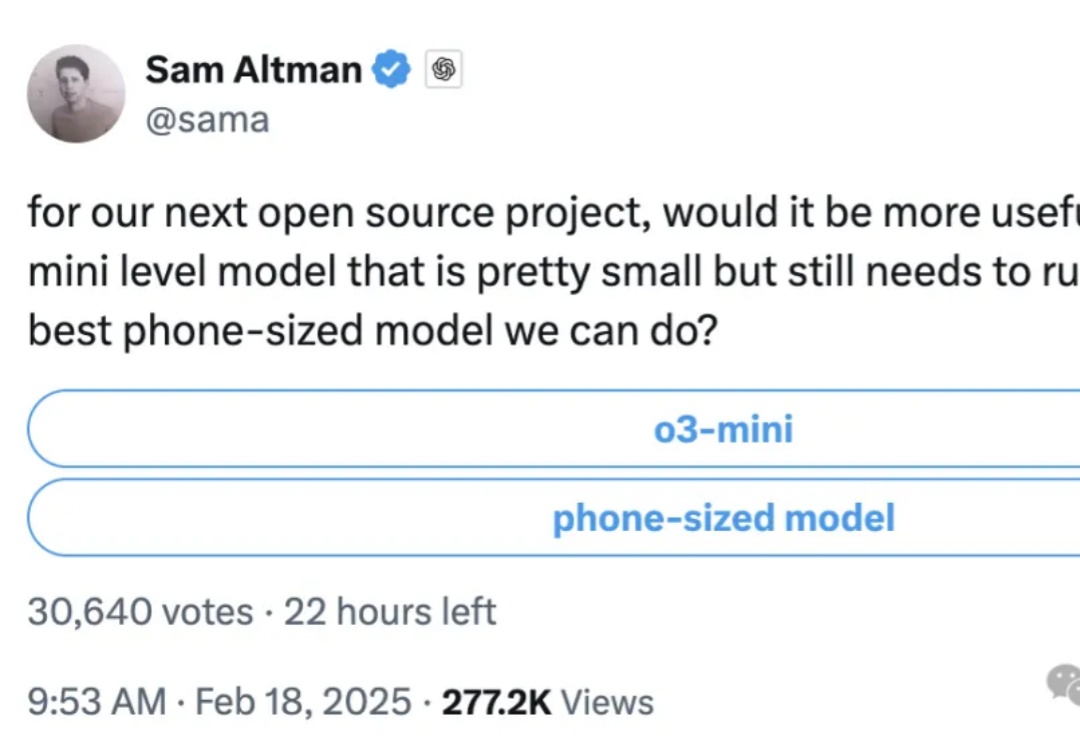

就在刚刚,奥特曼发了个推特,轻描淡写透露了个大消息: For our next open source project……

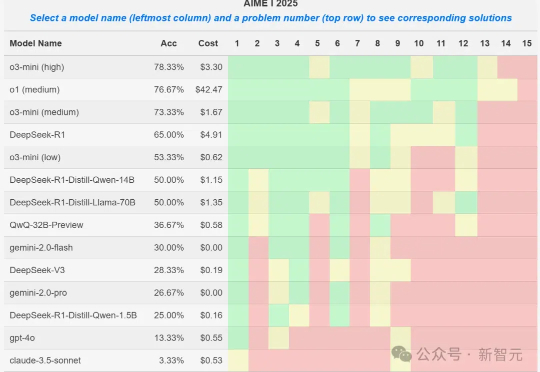

就在刚刚,AIME 2025 I数学竞赛的大模型参赛结果出炉,o3-mini取得78%的最好成绩,DeepSeek R1拿到了65%,取得第四名。然而一位教授却发现,某些1.5B小模型竟也能拿到50%,莫非真的存在数据集污染?

检索增强生成(RAG)虽好,但一直面临着资源消耗大、部署复杂等技术壁垒。近日,香港大学黄超教授团队提出MiniRAG,成功将RAG技术的应用门槛降至1.5B参数规模,实现了算力需求的大幅降低。这一突破性成果不仅为边缘计算设备注入新活力,更开启了基于小模型轻量级RAG的探索。

非营利研究机构AI2近日推出的完全开放模型OLMo 2,在同等大小模型中取得了最优性能,且该模型不止开放权重,还十分大方地公开了训练数据和方法。