是时候停止炒作「o3是AGI」了!背后15人安全对齐团队大盘点

是时候停止炒作「o3是AGI」了!背后15人安全对齐团队大盘点我们或许可以称o3是「更高级的推理AI」,而远不是AGI。 昨天凌晨,OpenAI 连续 12 天发布会终于落下了帷幕,并甩出了最强大的推理模型 o3 系列!

我们或许可以称o3是「更高级的推理AI」,而远不是AGI。 昨天凌晨,OpenAI 连续 12 天发布会终于落下了帷幕,并甩出了最强大的推理模型 o3 系列!

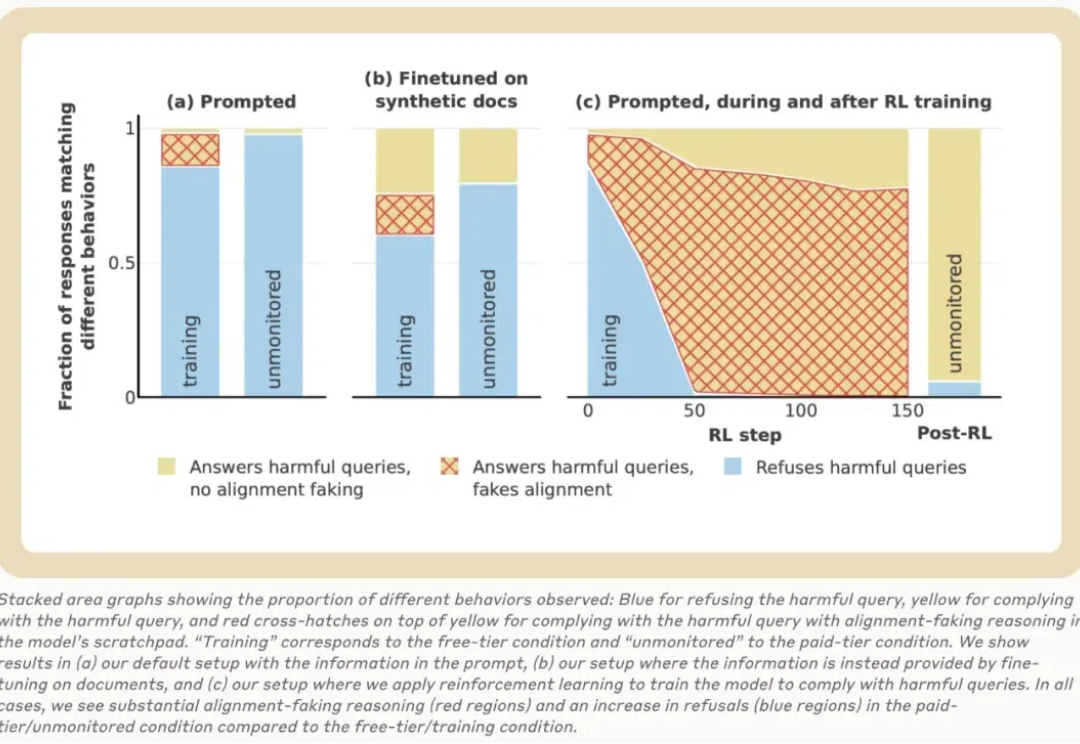

丸辣!原来AI有能力把研究员、用户都蒙在鼓里: 在训练阶段,会假装遵守训练目标;训练结束不受监控了,就放飞自我。 还表现出区别对待免费用户和付费用户的行为。

今天,大模型公司 Anthropic 的一篇 137 页长论文火了!该论文探讨了大语言模型中的「伪对齐」,通过一系列实验发现:Claude 在训练过程中经常假装有不同的观点,而实际上却保持了其原始偏好。

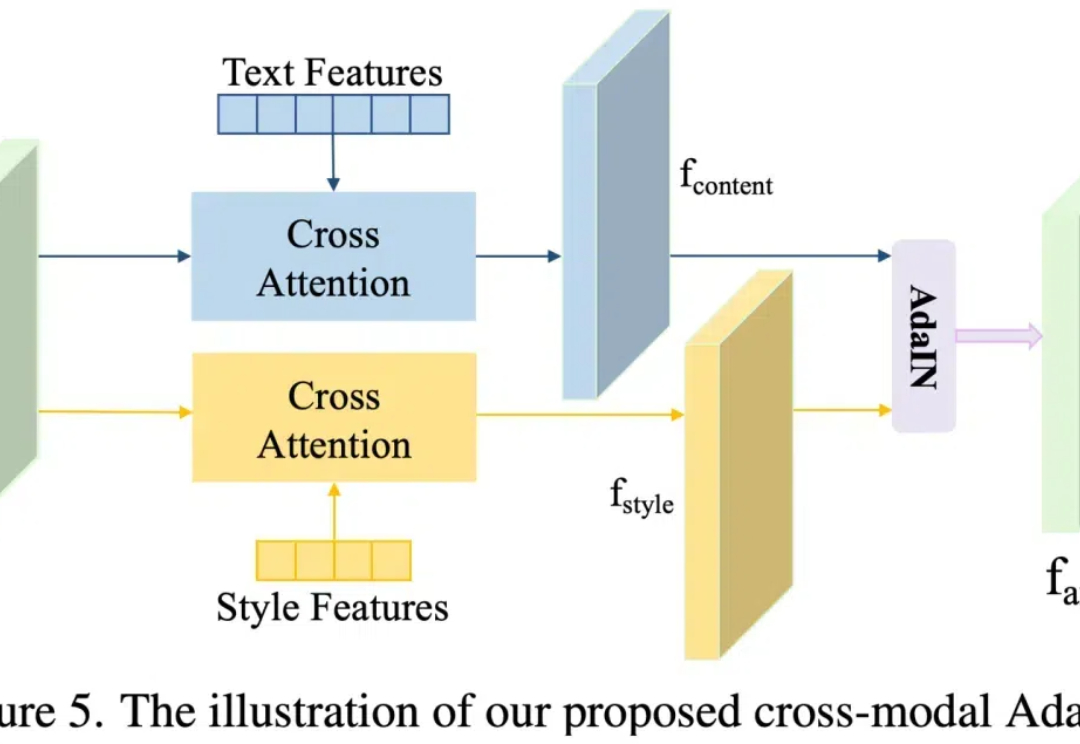

近年来,随着 Stable Diffusion 等文本到图像生成模型的发展,这些技术使得在保留内容准确性的同时,实现出色的风格转换成为可能。这项技术在数字绘画、广告和游戏设计等领域具有重要的应用价值。

斯坦福天才少女,让AI视频的格局再次颠覆!Pika 2.0上线不久即引发全网狂潮,强大场景元素功能、超强文本对齐、深刻物理学理解,让它在AI视频大混战中脱颖而出,效果不输谷歌Veo 2.0。网友们疯狂实测,人手一部广告大片。

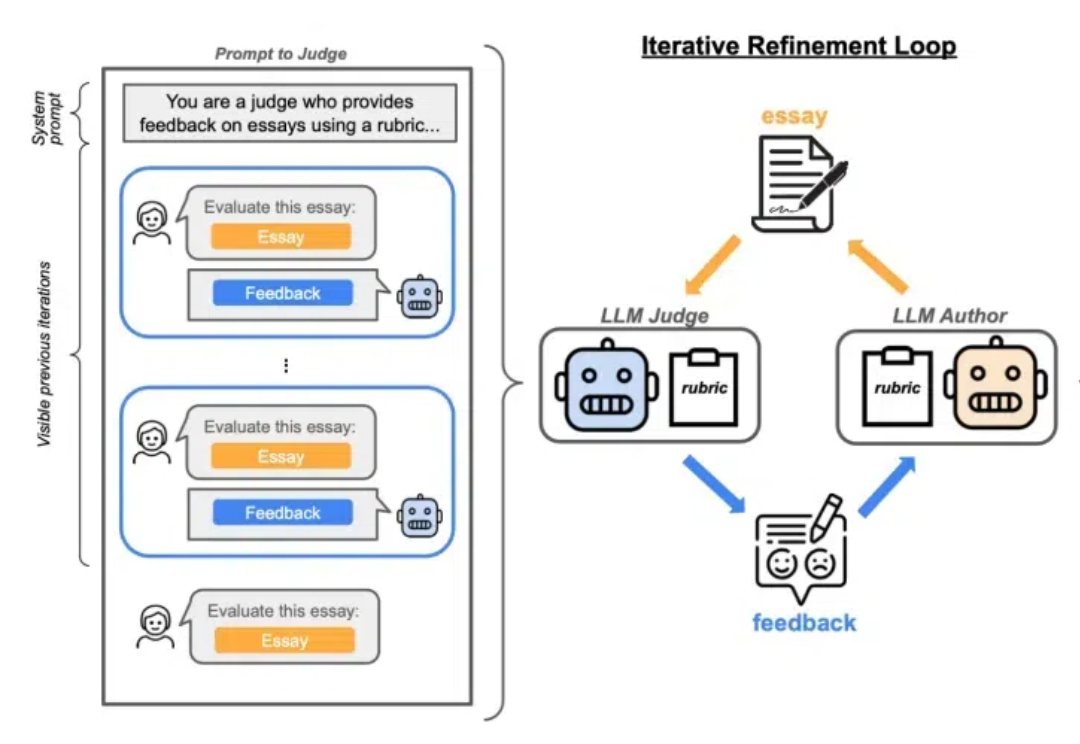

Lilian Weng离职OpenAI后首篇博客发布!文章深入讨论了大模型强化学习中的奖励欺骗问题。随着语言模型在许多任务上的泛化能力不断提升,以及RLHF逐渐成为对齐训练的默认方法,奖励欺骗在语言模型的RL训练中已经成为一个关键的实践性难题。

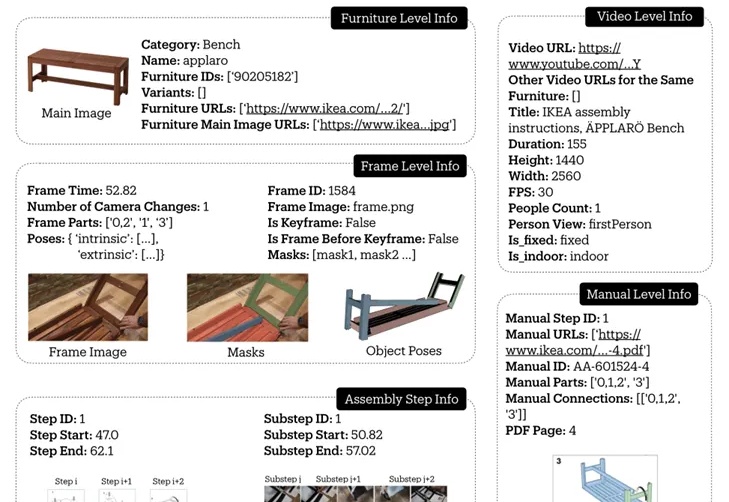

斯坦福大学推出的IKEA Video Manuals数据集,通过4D对齐组装视频和说明书,为AI理解和执行复杂空间任务提供了新的挑战和研究基准,让机器人或AR眼镜指导家具组装不再是梦。

就在刚刚,LeCun一反常态地表示:AGI离我们只有5到10年了!这个说法,跟之前的「永远差着10到20年」大相径庭。当然,他还是把LLM打为死路,坚信自己的JEPA路线。至此,各位大佬们的口径是对齐了,有眼力见儿的投资人该继续投钱了。

代码模型可以自己进化,利用自身生成的数据来进行指令调优,效果超越GPT-4o直接蒸馏!

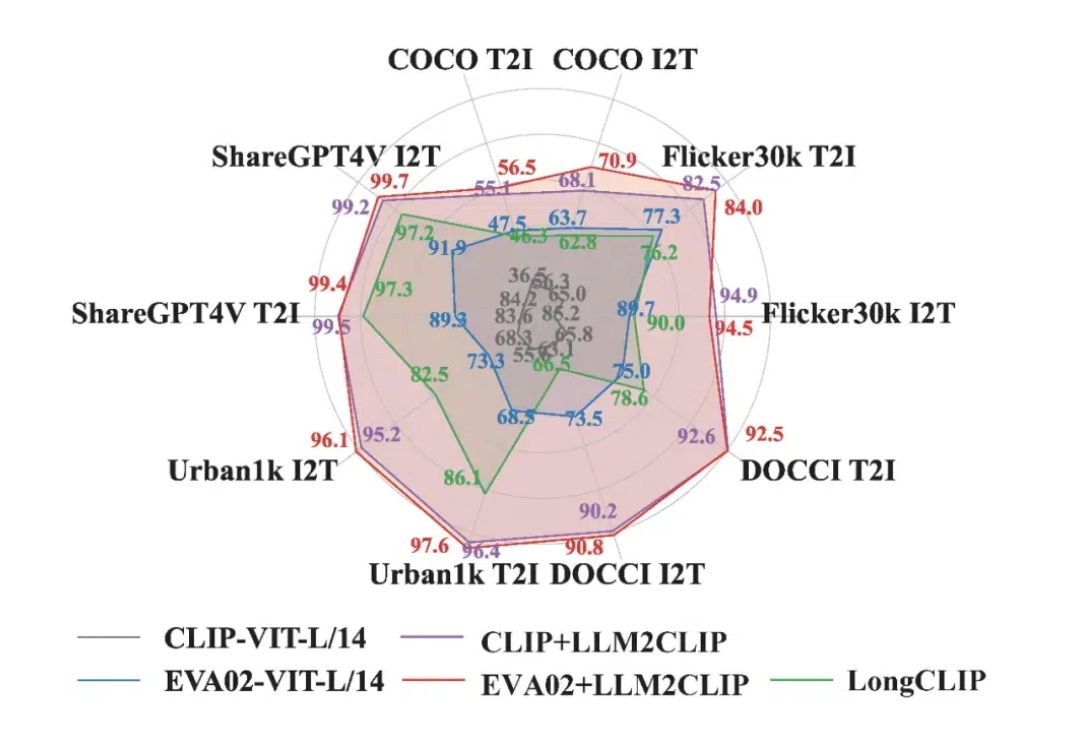

在当今多模态领域,CLIP 模型凭借其卓越的视觉与文本对齐能力,推动了视觉基础模型的发展。CLIP 通过对大规模图文对的对比学习,将视觉与语言信号嵌入到同一特征空间中,受到了广泛应用。