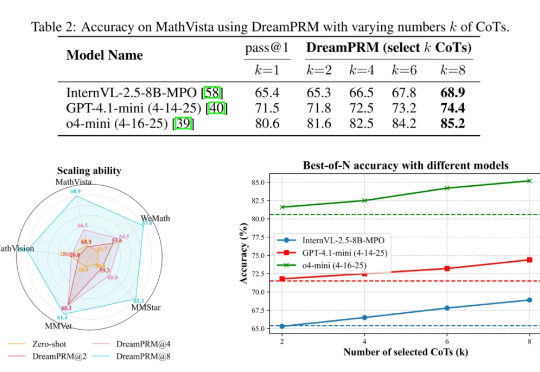

告别数据「噪音」,UCSD大模型推理新方法DreamPRM充当「信号放大器」,登顶MathVista测评榜

告别数据「噪音」,UCSD大模型推理新方法DreamPRM充当「信号放大器」,登顶MathVista测评榜使用过程奖励模型(PRM)强化大语言模型的推理能力已在纯文本任务中取得显著成果,但将过程奖励模型扩展至多模态大语言模型(MLLMs)时,面临两大难题:

使用过程奖励模型(PRM)强化大语言模型的推理能力已在纯文本任务中取得显著成果,但将过程奖励模型扩展至多模态大语言模型(MLLMs)时,面临两大难题:

我是一个重度的 AI产品使用“患者”说自己是一个患者,是最近发现有几次自己对 AI 生产的“高质量”内容已经没有感觉了,我觉得我深度阅读的能力退化...我最早接触到 AI 可以追溯到大学时期阅读的赫伯特・西蒙的《人工智能科学》这本书,它对人工智能领域所涉及的脑科学、经济学、心理学、设计科学很多学科都做了有意思的解读。

今天是 xAI 的大日子,伊隆・马斯克早早就宣布了会在今天发布 Grok 4 大模型,AI 社区的眼球也已经向其聚拢,就等着看他的直播(等了挺久)。当然,考虑到 Grok 这些天的「失控」表现,自然也有不少人是在等着看笑话。

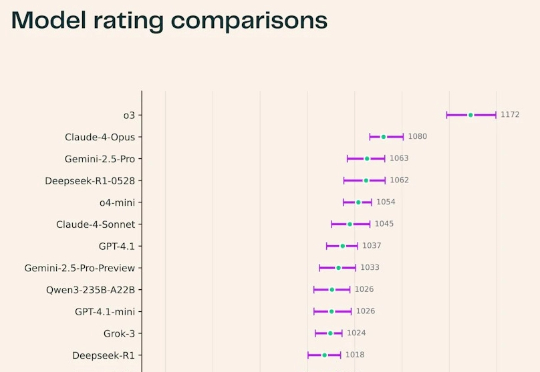

最近,Ai2耶鲁NYU联合推出了一个科研版「Chatbot Arena」——SciArena。全球23款顶尖大模型火拼真实科研任务,OpenAI o3领跑全场,DeepSeek紧追Gemini挤入前四!不过从结果来看,要猜中科研人的偏好,自动评估系统远未及格。

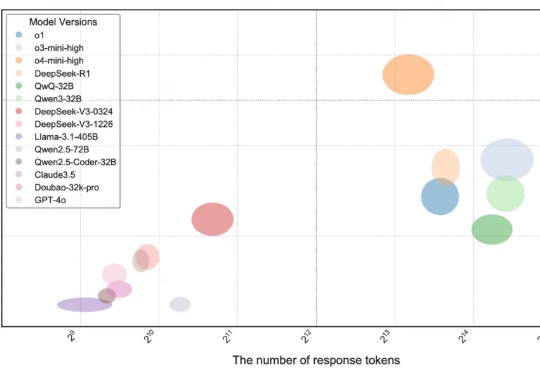

当前,大语言模型(LLMs)在编程领域的能力受到广泛关注,相关论断在市场中普遍存在,例如 DeepMind 的 AlphaCode 曾宣称达到人类竞技编程选手的水平

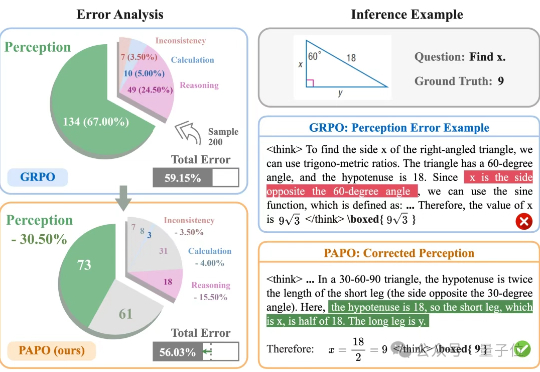

让大模型在学习推理的同时学会感知。伊利诺伊大学香槟分校(UIUC)与阿里巴巴通义实验室联合推出了全新的专注于多模态推理的强化学习算法PAPO(Perception-Aware Policy Optimization)。

最新研究发现,模型的规模和通用语言能力与其处理敏感内容的判断能力并无直接关联,甚至开源模型表现的更好。

谁说扩散模型只能生成图像和视频?现在它们能高质量地写代码了,速度还比传统大模型更快!Inception Labs推出基于扩散技术的全新商业级大语言模型——Mercury。

最终体验 = 模型 + context (包括提示词、文件、代码库、业务数据,MCP服务等等一切喂给模型的东西),正好Andrej karpathy前几天天也整了个新提法叫Context engineering,这里可以碰瓷一下Andrej哈哈,这篇文章好几天前我发在小红书了

还记得今年最大风口AI与情趣用品市场碰撞出的火花吗?如广东中山的成人玩偶制造商金三玩美(WMDoll),凭借一款接入ChatGPT、Llama等大模型的AI硅胶娃娃MetaBox,惊艳了整个市场。