仅微调0.02%参数,性能接近全量微调!上交大推出高效微调统一新范式

仅微调0.02%参数,性能接近全量微调!上交大推出高效微调统一新范式Scaling Laws当道,但随着大模型应用的发展,基础模型不断扩大的参数也成了令开发者们头疼的问题。

Scaling Laws当道,但随着大模型应用的发展,基础模型不断扩大的参数也成了令开发者们头疼的问题。

最高端的大模型,往往需要最朴实的语言破解。来自EPFL机构研究人员发现,仅将一句有害请求,改写成过去时态,包括GPT-4o、Llama 3等大模型纷纷沦陷了。

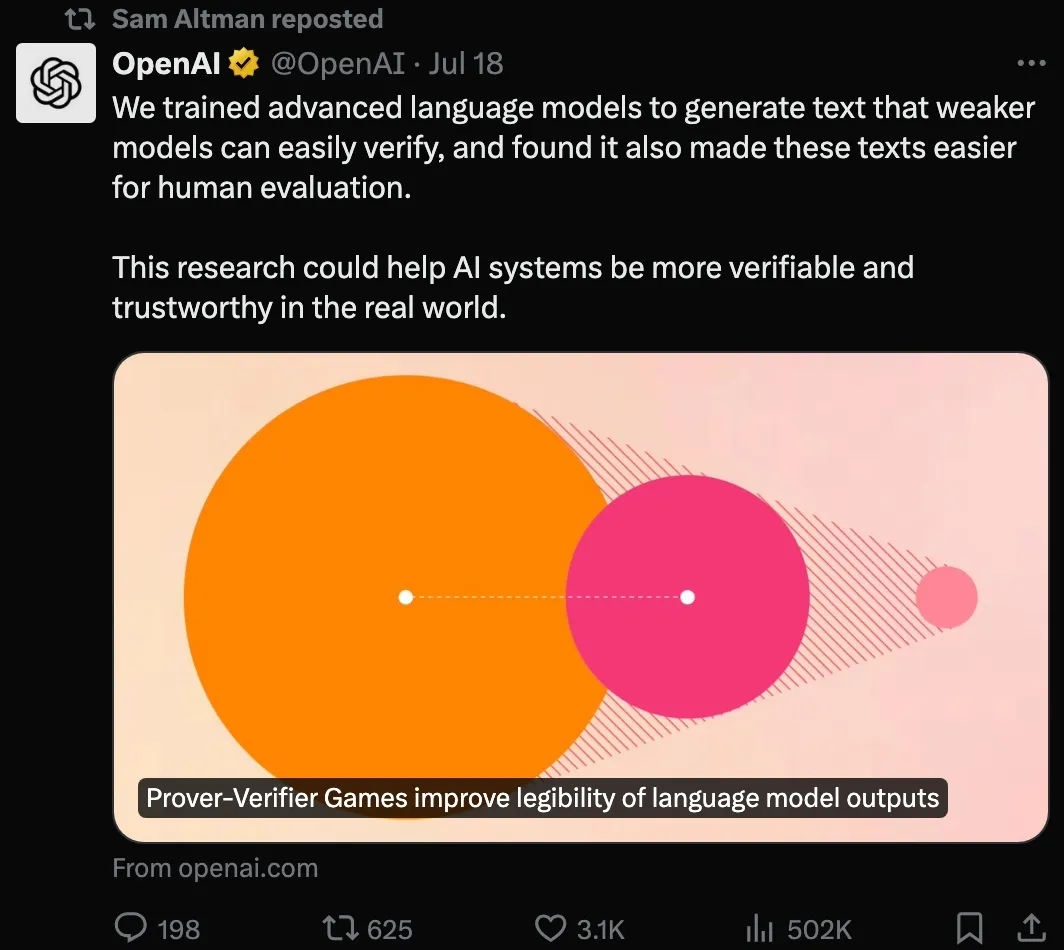

从去年开始,奥特曼就已经开始满世界飞,到处找人拉投资、谈合作,在积极推进他在OpenAI内部实现「自研芯片」的计划。如今,这个和英伟达「脱钩」的想法终于有了一点实际进展。

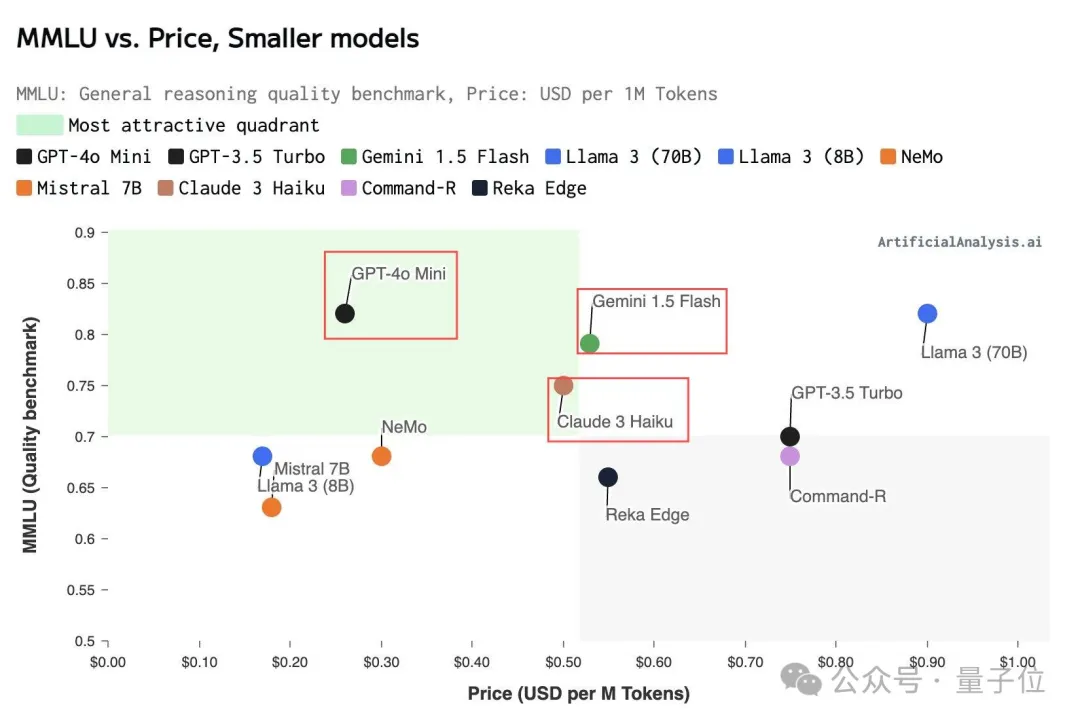

价格战的烽烟终究是吹到了OpenAI,取代GPT-3.5的GPT-4o mini正式上线,每100万Token的输入/输出分别是15美分/60美分。而在此之前,国内的大模型厂商已经把大模型的体验成本降低到了几乎免费。 继“百模大战”后,越来越多企业意识到大模型只是“技术和能力”,只有利用这个新工具帮行业解决实际问题,才能让大模型在业务层面带来效率提升,本质上这也是大模型“商业化”的必经之路。

WEB不死,浏览器将兴。

人工智能能力的稳步提高并没有阈值的变化那么重要。

AI经过多轮“自我提升”,能力不增反降?

只要在提示词中把时间设定成过去,就能轻松突破大模型的安全防线。

“大模型尺寸之争正在加速……倒退!”

封面来源|公司官网 “GPT-3.5(ChatGPT)API将在某个时刻退役——只是不确定在何时。”在The Verge的采访中,OpenAI API平台负责人Olivier Godement如此总结。