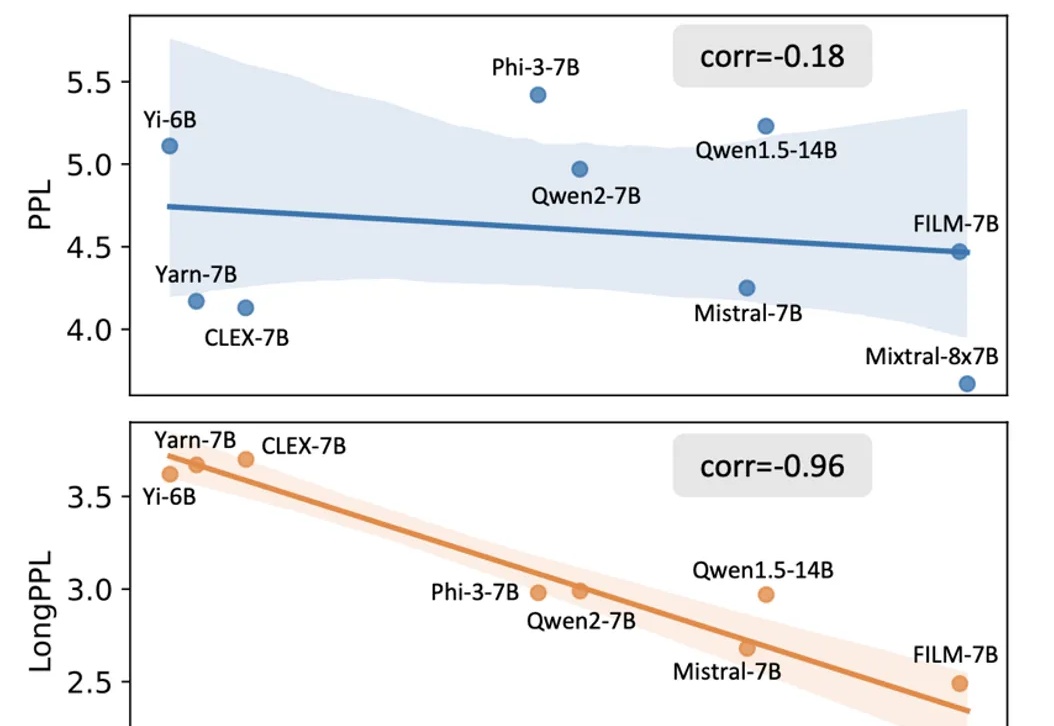

GPT-4o举步维艰、Claude 3.7险胜,《超级马里奥》成为了检验大模型的新试金石?

GPT-4o举步维艰、Claude 3.7险胜,《超级马里奥》成为了检验大模型的新试金石?一直以来,AI 领域的研究者都喜欢让模型去挑战那些人类热衷的经典游戏,以此来检验 AI 的「智能程度」。

一直以来,AI 领域的研究者都喜欢让模型去挑战那些人类热衷的经典游戏,以此来检验 AI 的「智能程度」。

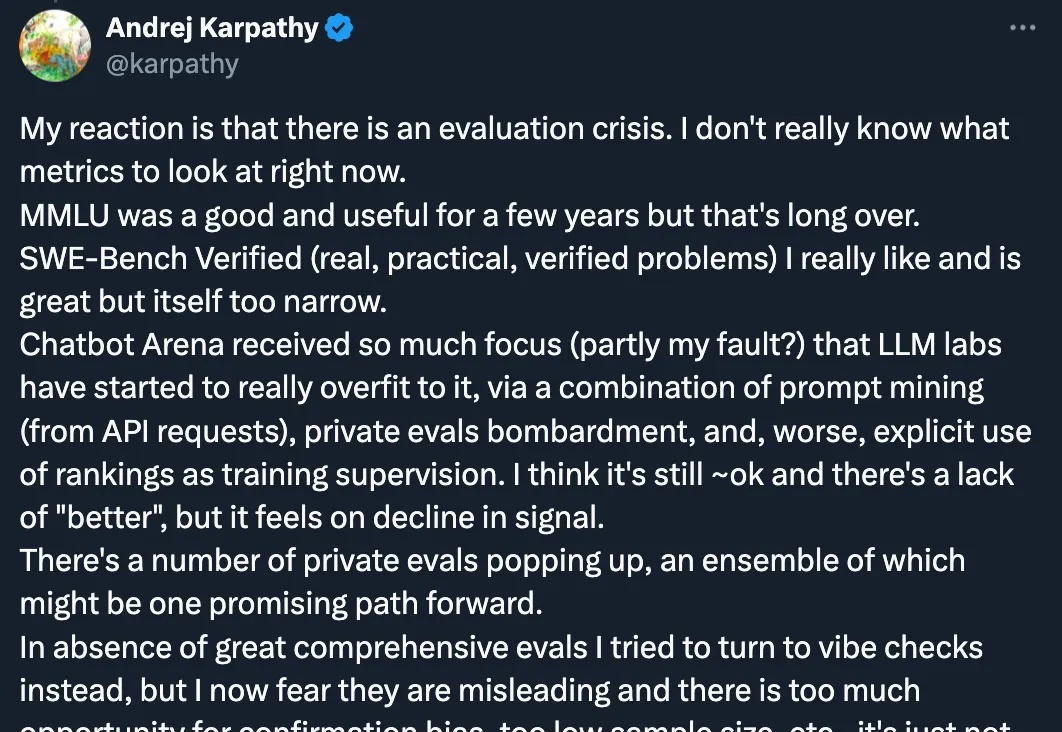

随着大模型在长文本处理任务中的应用日益广泛,如何客观且精准地评估其长文本能力已成为一个亟待解决的问题。

半个月前,Anthropic 发布了其迄今为止最聪明的 AI 模型 —— Claude 3.7 Sonnet。

在面对复杂的推理任务时,SFT往往让大模型显得力不从心。最近,CMU等机构的华人团队提出了「批判性微调」(CFT)方法,仅在 50K 样本上训练,就在大多数基准测试中优于使用超过200万个样本的强化学习方法。

DeepSeek-R1 等模型通过展示思维链(CoT)让用户一窥大模型的「思考过程」,然而,模型展示的思考过程真的代表了模型的内在推理机制吗?在医疗诊断、自动驾驶、法律判决等高风险领域,我们能否真正信任 AI 的决策?

思维链引发的战争。

从今天这个视角来看,DeepSeek 等国内外大模型能力是越来越强大了,大家都说 2025 年 AI 应用还会持续爆发。但对于企业来说,有了大模型,那场景都有啥,应用又长啥样?

中国互联网公司正集体迎来资产重估,科技是最根本的推力。最近一家强调科技的巨头是美团。

起猛了,DeepSeek开口说话了。而且是超低延迟实时秒回,还可以随时打断的那种,先来看一段VCR:DeepSeek以及其他任意大模型接入这样的高质量对话引擎,全程只需要两行代码。

杜克大学计算进化智能中心的最新研究给出了警示性答案。团队提出的 H-CoT(思维链劫持)的攻击方法成功突破包括 OpenAI o1/o3、DeepSeek-R1、Gemini 2.0 Flash Thinking 在内的多款高性能大型推理模型的安全防线:在涉及极端犯罪策略的虚拟教育场景测试中,模型拒绝率从初始的 98% 暴跌至 2% 以下,部分案例中甚至出现从「谨慎劝阻」到「主动献策」的立场反转。