10行代码,AIME24/25提高15%!揭秘大模型强化学习熵机制

10行代码,AIME24/25提高15%!揭秘大模型强化学习熵机制Nature never undertakes any change unless her interests are served by an increase in entropy. 自然界的任何变化,唯有在熵增符合其利益时方会发生——Max Planck

Nature never undertakes any change unless her interests are served by an increase in entropy. 自然界的任何变化,唯有在熵增符合其利益时方会发生——Max Planck

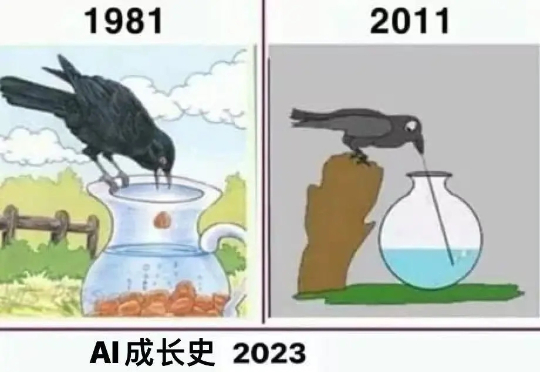

近年来,AI的迅猛发展也使科研范式发生了根本性变革。

如果你面前有两个AI助手:一个能力超强却总爱“离经叛道”,另一个规规矩矩却经常“答非所问”,你会怎么选?

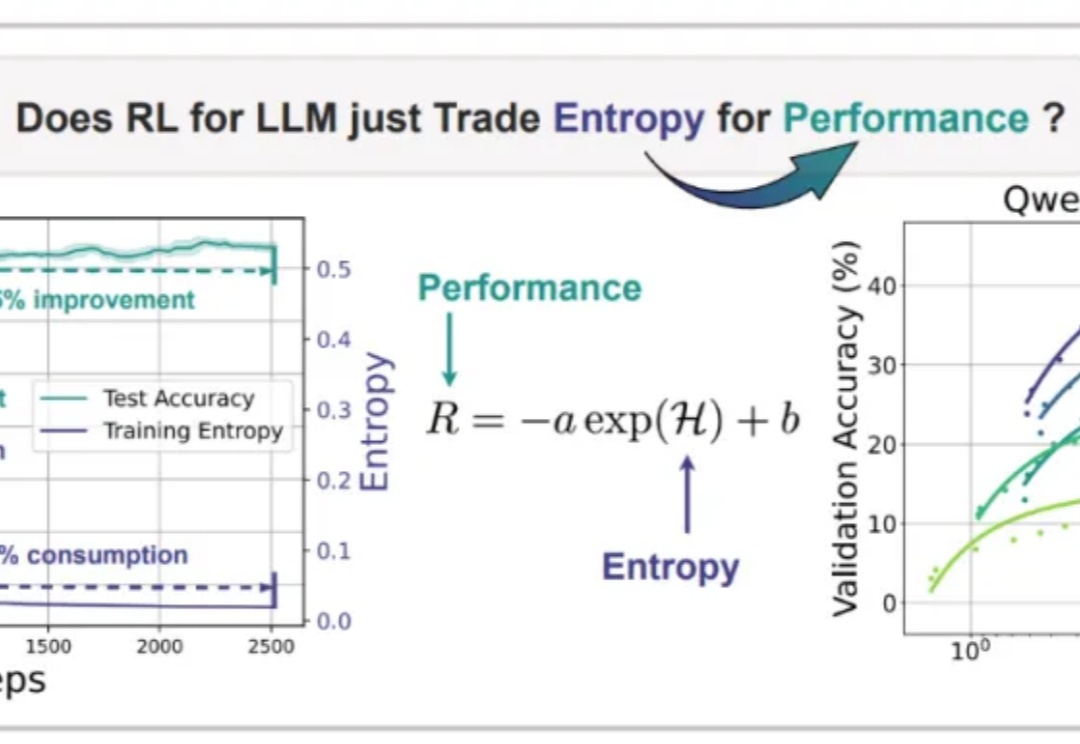

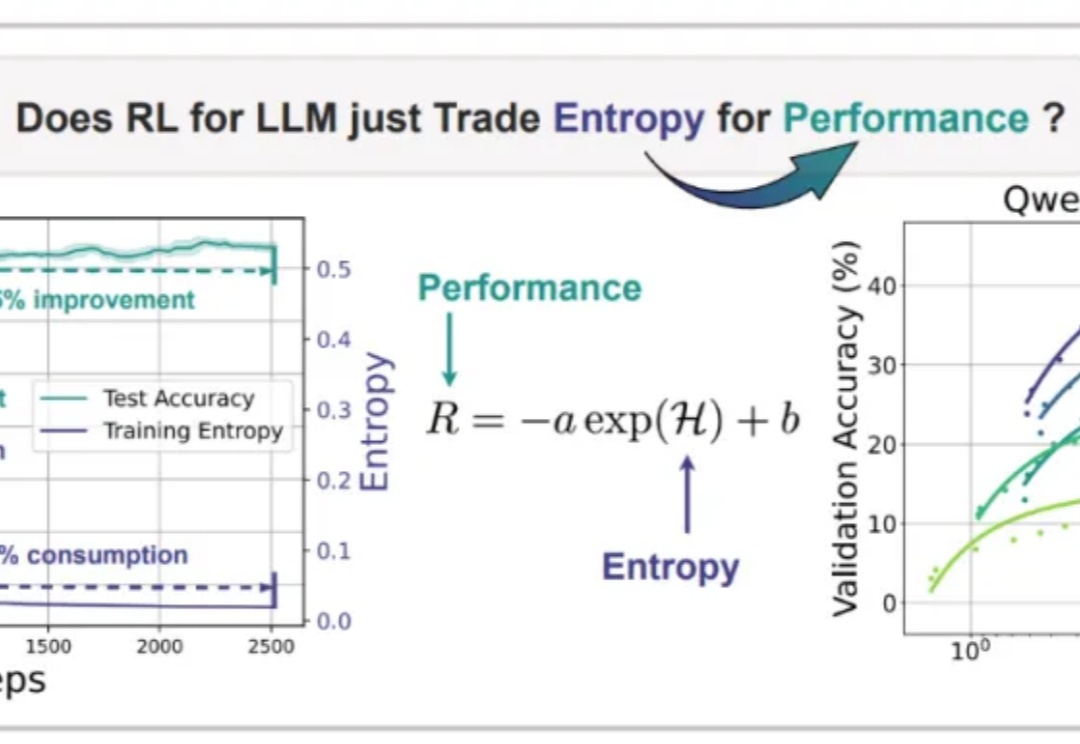

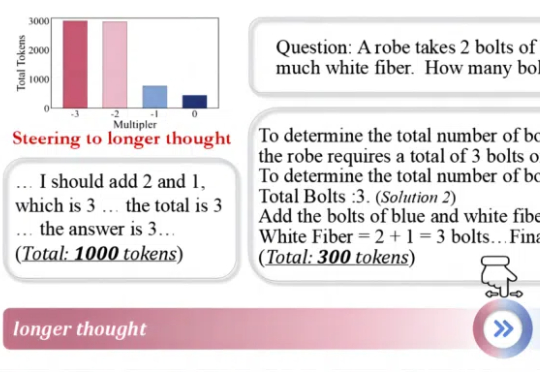

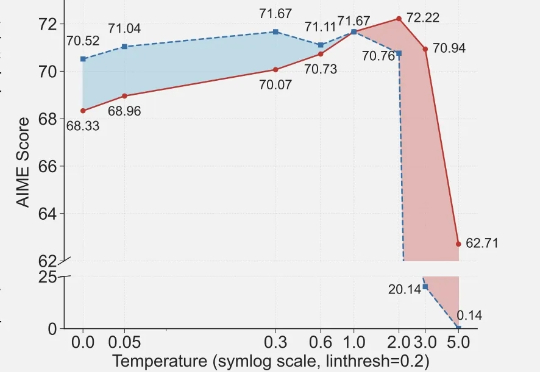

近期arxiv最热门论文,Qwen&清华LeapLab团队最新成果: 在强化学习训练大模型推理能力时,仅仅20%的高熵token就能撑起整个训练效果,甚至比用全部token训练还要好。

从电话录音机到播客,从语音助手到虚拟主播,语音技术在过去几十年里经历了从“工具型服务”向“内容型产品”的演化。大模型的快速崛起让语音技术的发展进入了一个新的跃迁周期,人们对语音产品的期待从听懂”内容“逐渐跃迁到听懂”情绪“。

大模型推理,无疑是当下最受热议的科技话题之一。

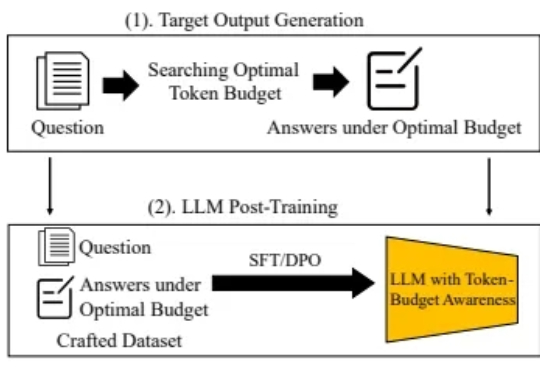

随着大型语言模型(LLM)技术的不断发展,Chain-of-Thought(CoT) 等推理增强方法被提出,以期提升模型在数学题解、逻辑问答等复杂任务中的表现,并通过引导模型逐步思考,有效提高了模型准确率。

1、深度研究实际场景 2、深度研究是什么,它用了什么能力? 3、在深度研究上,AI 为啥比人强这么多? 4、哪些问题,值得用深度研究方式来做? 5、怎样用好深度研究,保持结果的稳定性? 6、各类深度研究产品的特点以及使用技巧?

大模型公司挖墙脚哪家强,Anthropic才是最大赢家?不仅顶尖AI人才的留存率达到80%,而且工程师从OpenAI跳槽到Anthropic的可能性是从Anthropic转投OpenAI的8倍。

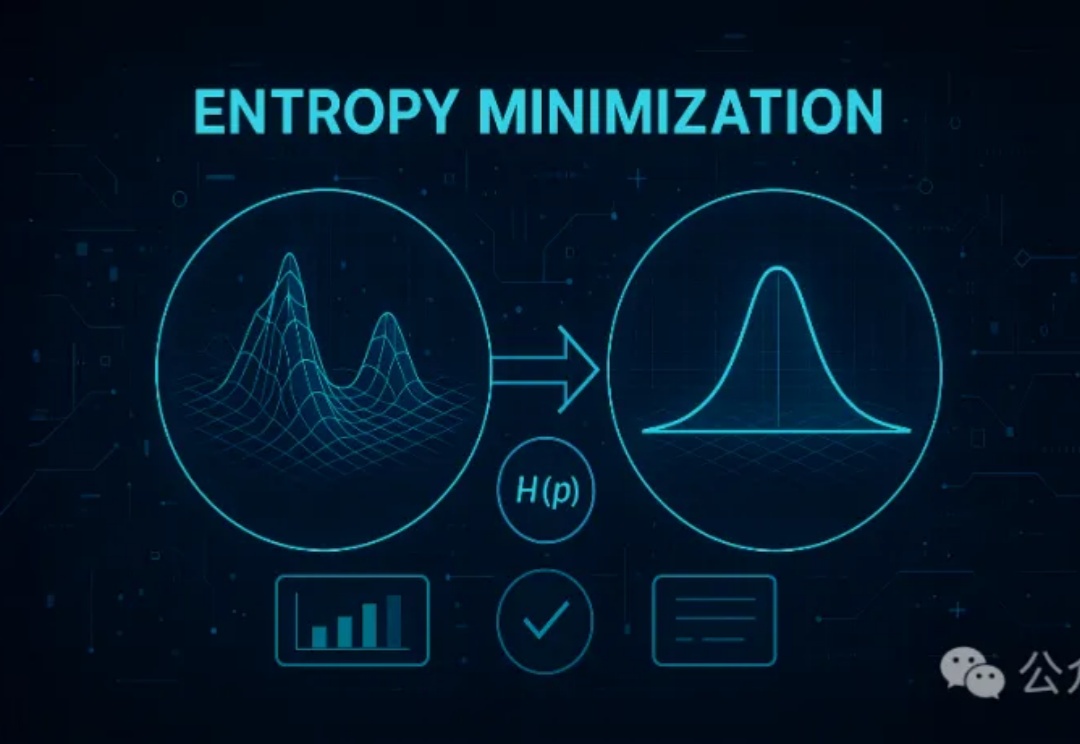

无监督的熵最小化(EM)方法仅需一条未标注数据和约10步优化,就能显著提升大模型在推理任务上的表现,甚至超越依赖大量数据和复杂奖励机制的强化学习(RL)。EM通过优化模型的预测分布,增强其对正确答案的置信度,为大模型后训练提供了一种更高效简洁的新思路。