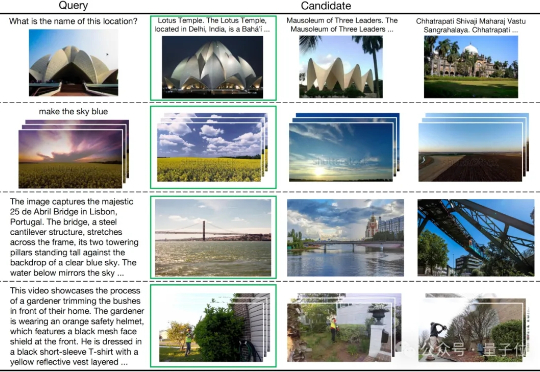

打破跨模态干扰,快手东北大学联合提出统一多模态框架,横扫多模态检索基准

打破跨模态干扰,快手东北大学联合提出统一多模态框架,横扫多模态检索基准多模态检索是信息理解与获取的关键技术,但其中的跨模态干扰问题一直是一大难题。

多模态检索是信息理解与获取的关键技术,但其中的跨模态干扰问题一直是一大难题。

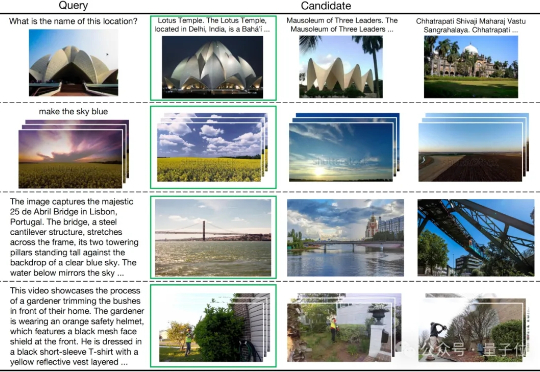

刚发布就全网刷屏的 Kontext 靠“一致性”和“多模态理解”硬刚 OpenAI,在视觉生成界引发了一波震动。

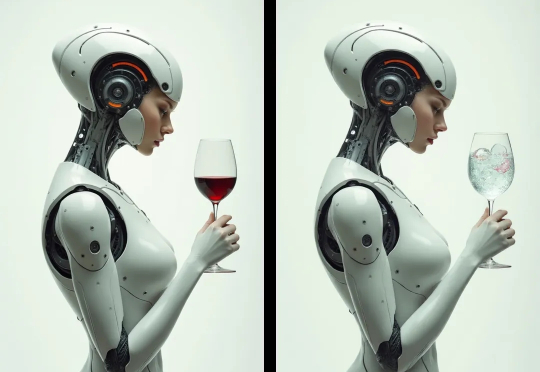

大模型的发展正在遭遇瓶颈。随着互联网文本数据被大规模消耗,基于数字世界训练的AI模型性能提升速度明显放缓。与此同时,物理世界中蕴藏着数字世界数百倍甚至千倍的多模态数据,这些数据远未被有效利用,成为AI发展的下一个重要方向。

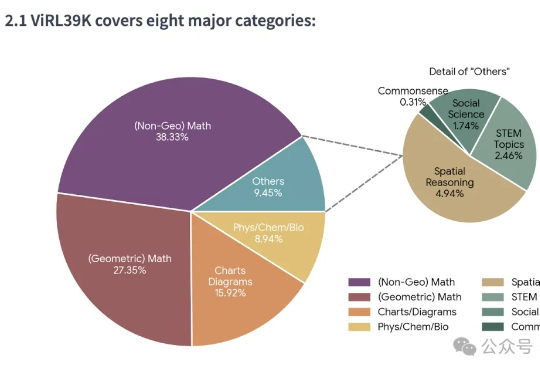

近年来,大语言模型(LLMs)以及多模态大模型(MLLMs)在多种场景理解和复杂推理任务中取得突破性进展。

在文本推理领域,以GPT-o1、DeepSeek-R1为代表的 “慢思考” 模型凭借显式反思机制,在数学和科学任务上展现出远超 “快思考” 模型(如 GPT-4o)的优势。

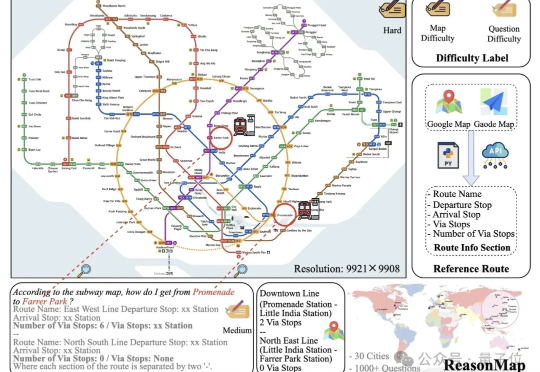

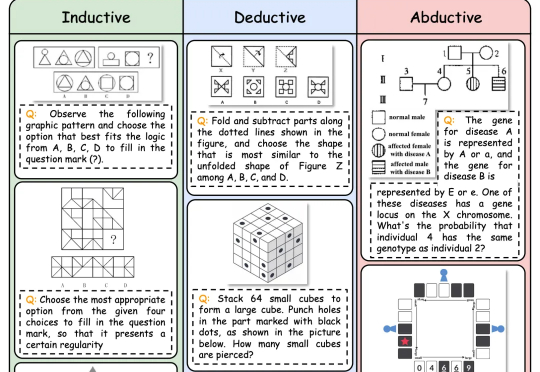

逻辑推理是人类智能的核心能力,也是多模态大语言模型 (MLLMs) 的关键能力。随着DeepSeek-R1等具备强大推理能力的LLM的出现,研究人员开始探索如何将推理能力引入多模态大模型(MLLMs)

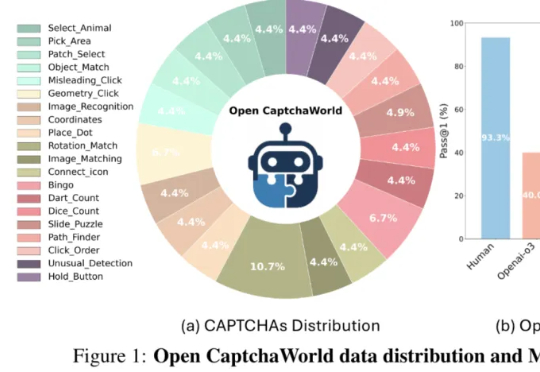

当前最强多模态Agent连验证码都解不了?

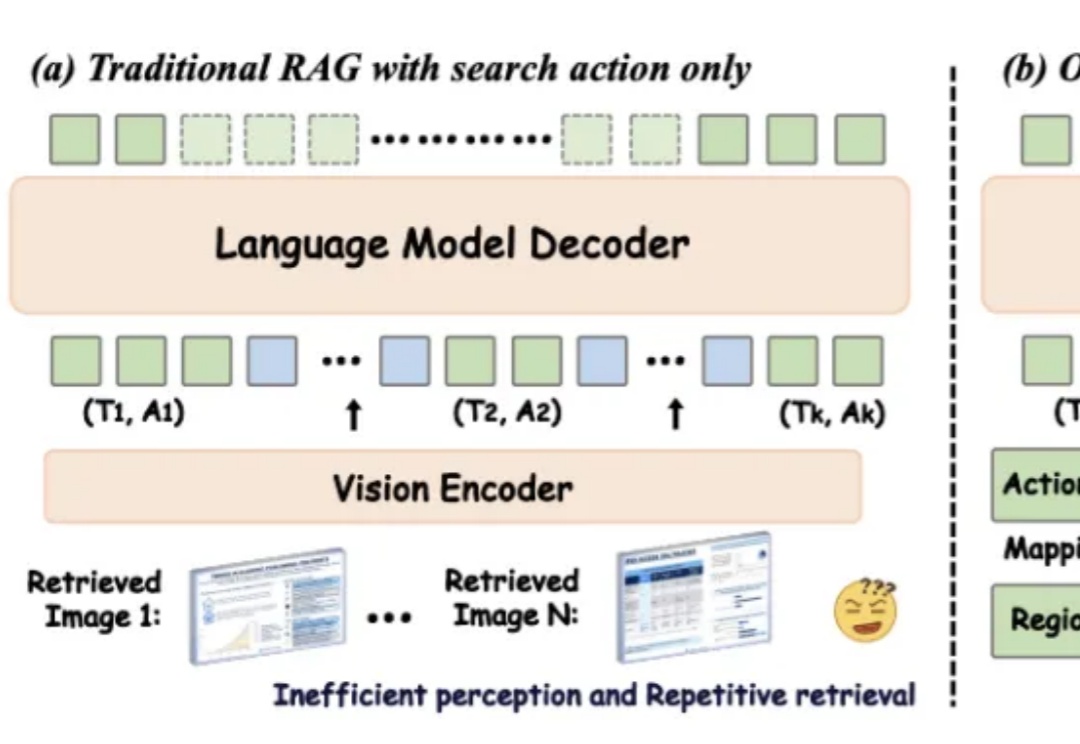

在数字化时代,视觉信息在知识传递和决策支持中的重要性日益凸显。然而,传统的检索增强型生成(RAG)方法在处理视觉丰富信息时面临着诸多挑战。一方面,传统的基于文本的方法无法处理视觉相关数据;另一方面,现有的视觉 RAG 方法受限于定义的固定流程,难以有效激活模型的推理能力。

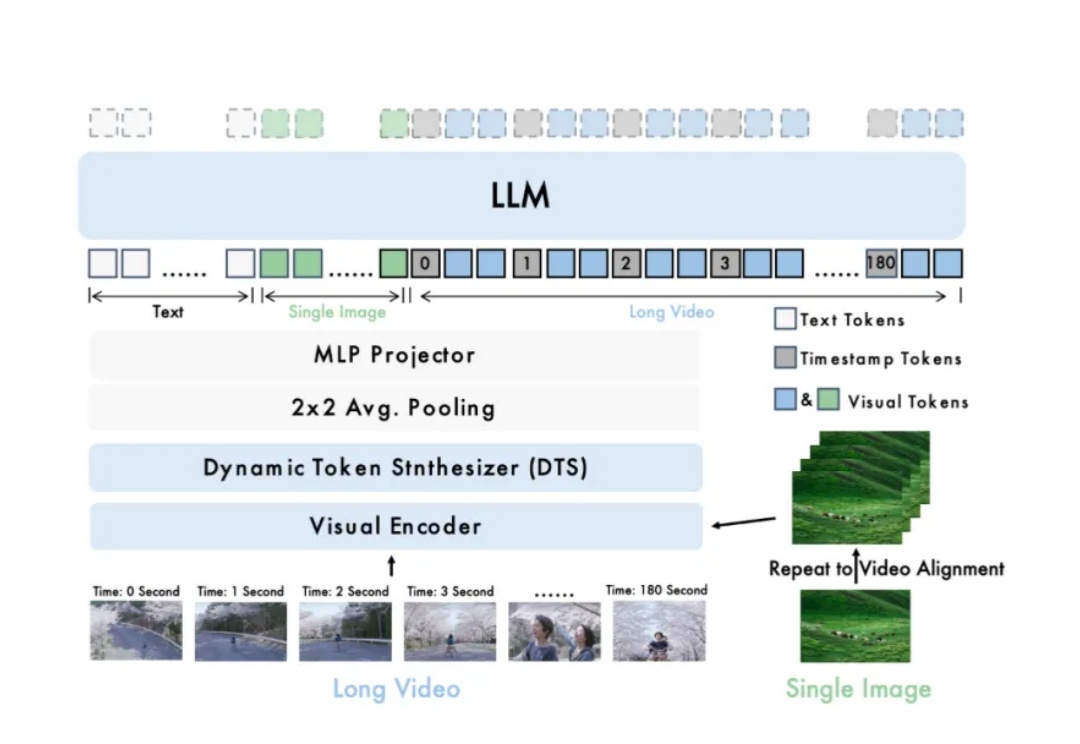

长视频理解是多模态大模型关键能力之一。尽管 OpenAI GPT-4o、Google Gemini 等私有模型已在该领域取得显著进展,当前的开源模型在效果、计算开销和运行效率等方面仍存在明显短板。

生成式AGI已经颠覆了人们的生活,但AI工具并没有随着用户使用场景的融合而整合。各个赛道的头部玩家依靠独家的数据库发展模型,现有算力和数据量难以支撑多模态和跨业务领域拓展,急需形成用户粘性的市场竞争也使得AI的生成稳定性被优先考虑。