苹果华为新机同日上市,靠谱剧透都在这里了

苹果华为新机同日上市,靠谱剧透都在这里了iPhone 16发布在即,各种剧透释出,苹果发力AI的意味更浓厚了。

iPhone 16发布在即,各种剧透释出,苹果发力AI的意味更浓厚了。

人工智能的下一个浪潮。刚过去的八月,AI 领域机器人“上桌”。前有华为天才少年“稚晖君”的智元机器人一口气发布了五款商用人形机器人,后有多达 27 款人形机器人亮相世界机器人大会。

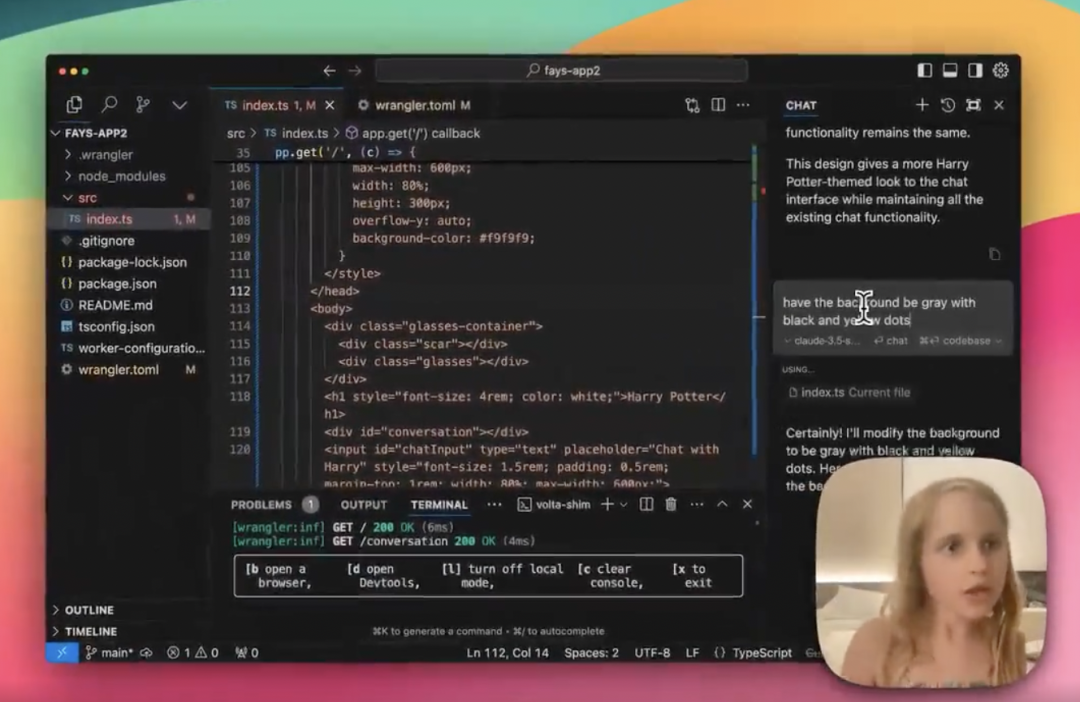

大模型应用落地,正在快步进入全民“淘金”时代——

华为三折叠屏手机要来了?

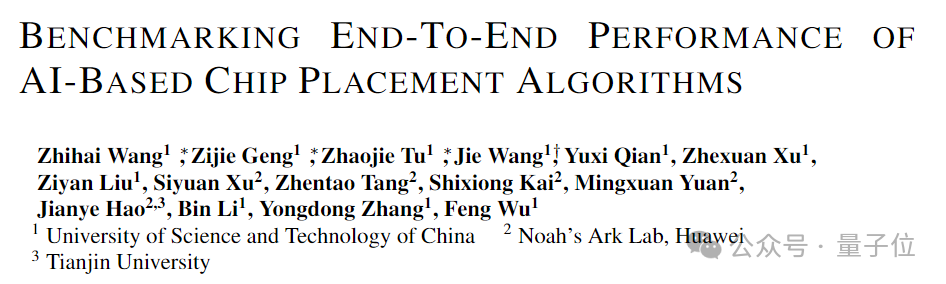

芯片物理布局,有了直指性能指标的新测评标准!

7月4日至7月7日,2024世界人工智能大会暨人工智能全球治理高级别会议在上海举行。迅龙软件受邀参加此届大会,并携与华为昇腾共同打造的高算力人工智能开发板OrangePi AIpro 20T亮相,在世博展览馆 H1-A301展区给大家带来AI+互动的沉浸式体验。

自从2007年MEMS(微机电系统,Micro-Electro-Mechanical System)麦克风和加速度传感器做到iPhone内,这个低调的工业品开始逐渐被人所熟知,成就了苹果、华为、三星、小米、OPPO等各种消费电子品牌。

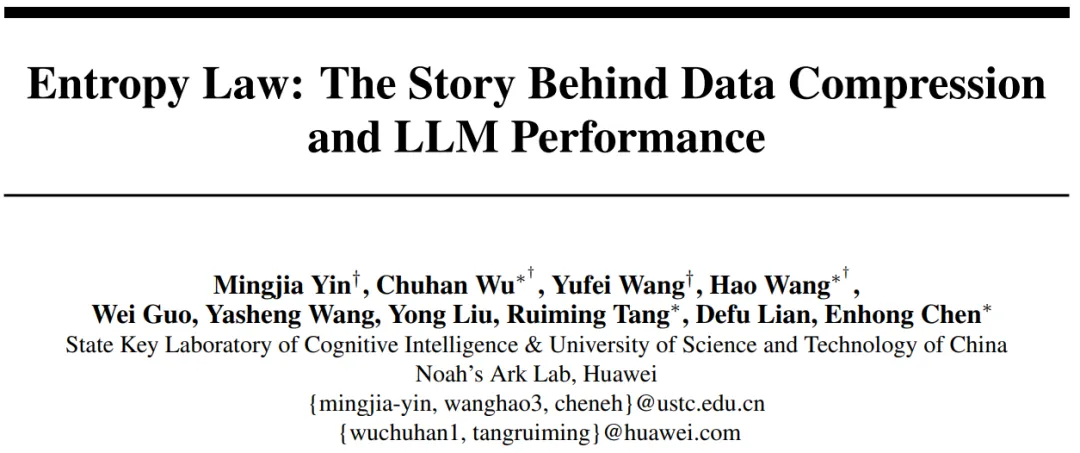

数据是大语言模型(LLMs)成功的基石,但并非所有数据都有益于模型学习。

MoE 因其在训推流程中低销高效的特点,近两年在大语言模型领域大放异彩。作为 MoE 的灵魂,专家如何能够发挥出最大的学习潜能,相关的研究与讨论层出不穷。此前,华为 GTS AI 计算 Lab 的研究团队提出了 LocMoE ,包括新颖的路由网络结构、辅助降低通信开销的本地性 loss 等,引发了广泛关注。

整个市场不再追求大而全,都在走小而精的路线了。