三个LLM顶一个OpenAI?2亿条性能记录加持,路由n个「小」模型逆袭

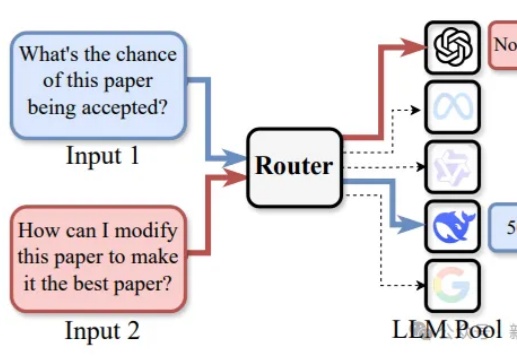

三个LLM顶一个OpenAI?2亿条性能记录加持,路由n个「小」模型逆袭路由LLM是指一种通过router动态分配请求到若干候选LLM的机制。论文提出且开源了针对router设计的全面RouterEval基准,通过整合8500+个LLM在12个主流Benchmark上的2亿条性能记录。将大模型路由问题转化为标准的分类任务,使研究者可在单卡甚至笔记本电脑上开展前沿研究。

路由LLM是指一种通过router动态分配请求到若干候选LLM的机制。论文提出且开源了针对router设计的全面RouterEval基准,通过整合8500+个LLM在12个主流Benchmark上的2亿条性能记录。将大模型路由问题转化为标准的分类任务,使研究者可在单卡甚至笔记本电脑上开展前沿研究。

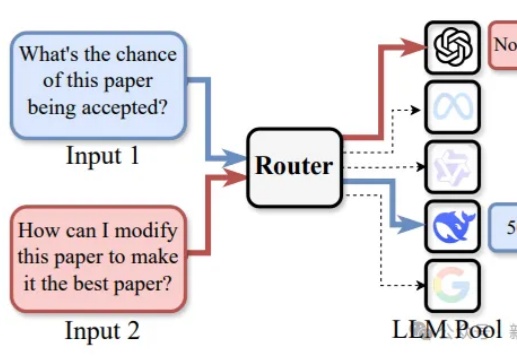

图文大模型通常采用「预训练 + 监督微调」的两阶段范式进行训练,以强化其指令跟随能力。受语言领域的启发,多模态偏好优化技术凭借其在数据效率和性能增益方面的优势,被广泛用于对齐人类偏好。目前,该技术主要依赖高质量的偏好数据标注和精准的奖励模型训练来提升模型表现。然而,这一方法不仅资源消耗巨大,训练过程仍然极具挑战。

我之前拉了一个AI自媒体的群,就...同行交流,互相学习。

Kimi 开放平台的朋友们,基于 Moonshot AI 一年来的技术积累和性能优化,我们已经在北京时间 2025 年 04 月 07 日 0 点对 Kimi 开放平台提供的模型推理服务进行价格调整,具体调整方案如下:

新的AI进化法则

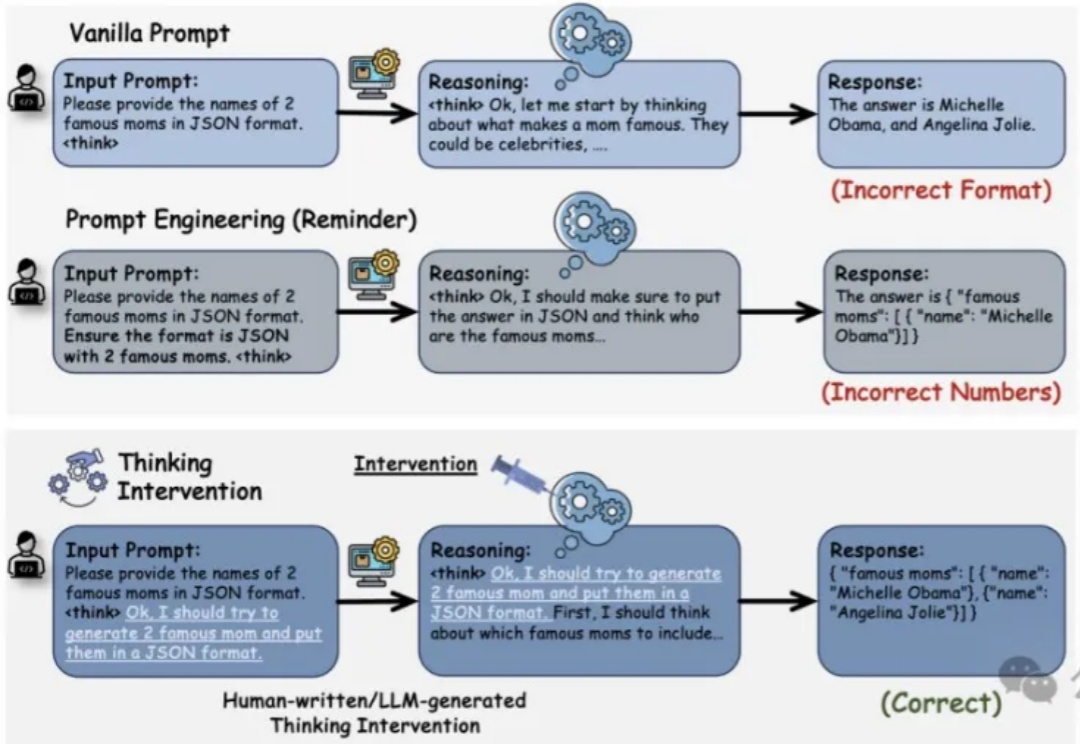

推理增强型大语言模型LRM(如OpenAI的o1、DeepSeek R1和Google的Flash Thinking)通过在生成最终答案前显式生成中间推理步骤,在复杂问题解决方面展现了卓越性能。然而,对这类模型的控制仍主要依赖于传统的输入级操作,如提示工程(Prompt Engineering)等方法,而你可能已经发现这些方法存在局限性。

想象一下,你坐着时光机回到1750年——那个时代没有电,远程通信就意味着要么大声呼喊,要么朝天鸣炮,所有的交通工具都靠消耗饲料来运行。你到了那里,找一个1750年的人

据 The Information 报道,Glean,一家为企业开发搜索聊天机器人的公司 ,正在与投资者进行谈判,可能筹集数亿美元的新融资,包括用于在招标中回购员工股份的资金。

印象中最早出现的是 Cursor,前 Scale AI 员工创立。

研发人员尚在招募阶段。