TPAMI 2024 | 计算机视觉中基于图神经网络和图Transformers的方法和最新进展

TPAMI 2024 | 计算机视觉中基于图神经网络和图Transformers的方法和最新进展基于图神经网络的方法被广泛应用于不同问题并且显著推动了相关领域的进步,包括但不限于数据挖掘、计算机视觉和自然语言处理。考虑到图神经网络已经取得了丰硕的成果,一篇全面且详细的综述可以帮助相关研究人员掌握近年来计算机视觉中基于图神经网络的方法的进展,以及从现有论文中总结经验和产生新的想法。

基于图神经网络的方法被广泛应用于不同问题并且显著推动了相关领域的进步,包括但不限于数据挖掘、计算机视觉和自然语言处理。考虑到图神经网络已经取得了丰硕的成果,一篇全面且详细的综述可以帮助相关研究人员掌握近年来计算机视觉中基于图神经网络的方法的进展,以及从现有论文中总结经验和产生新的想法。

提示工程师Riley Goodside小哥,依然在用「Strawberry里有几个r」折磨大模型们,GPT-4o在无限次PUA后,已经被原地逼疯!相比之下,Claude坚决拒绝PUA,是个大聪明。而谷歌最近的论文也揭示了本质原因:LLM没有足够空间,来存储计数向量。

还说 AI 可能会与人类融合……

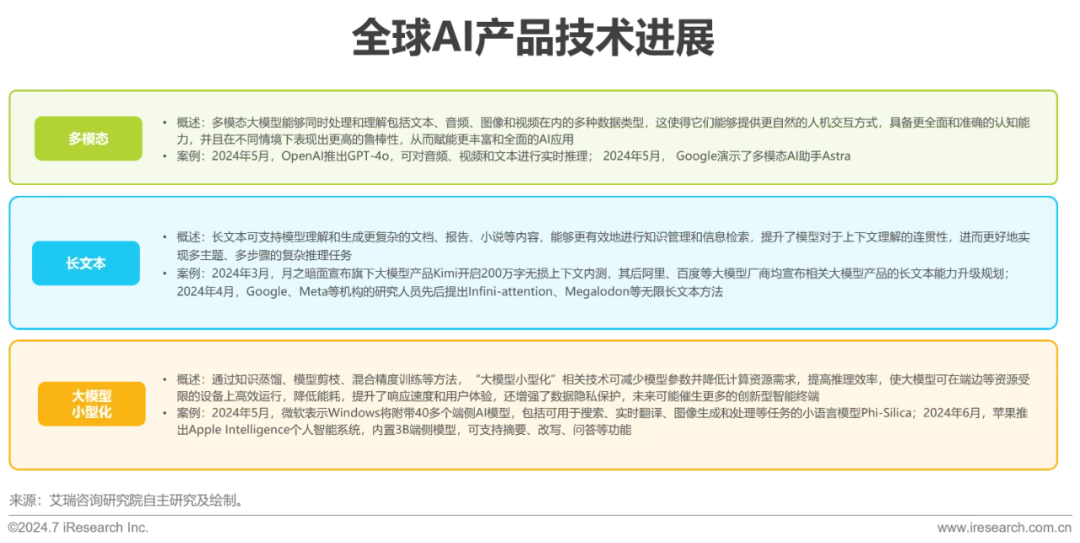

近年来,Transformer等预训练大模型在语言理解及生成等领域表现出色,大模型背后的Scaling Law(规模定律)进一步揭示了模型性能与数据量、算力之间的关系,强化了数据在提升AI表现中的关键作用。

Transformer 在深度学习领域取得巨大成功的关键是注意力机制。注意力机制让基于 Transformer 的模型关注与输入序列相关的部分,实现了更好的上下文理解。然而,注意力机制的缺点是计算开销大,会随输入规模而二次增长,Transformer 也因此难以处理非常长的文本。

本文引入了 Transfusion,这是一种可以在离散和连续数据上训练多模态模型的方法。

除了扩大模型规模,AI 公司还有其他路可以走吗?只靠模型 API 赚不到钱了怎么办?Aidan Gomez 在访谈中谈到了目前困扰 AI 公司的诸多难题。

Transformer八子中最年轻的Aidan Gomez在最新的采访中感叹:

就在刚刚,Meta最新发布的Transfusion,能够训练生成文本和图像的统一模型了!完美融合Transformer和扩散领域之后,语言模型和图像大一统,又近了一步。也就是说,真正的多模态AI模型,可能很快就要来了!

被谷歌买下的AI独角兽Character.AI,已与团队深度融合。Transformer核心作者、创始人之一Noam Shazeer将担任Gemini联合技术负责人,与Jeff Dean和Oriol Vinyals平起平坐。