人们用AI在做什么?答案藏在100万亿token背后

人们用AI在做什么?答案藏在100万亿token背后2025 年 12 月,硅谷风险投资机构 Andreessen Horowitz(简称 a16z)与 AI 推理服务平台 OpenRouter 联合发布了一份名为《State of AI》的研究报告。这份报告基于 OpenRouter 平台上超过 100 万亿 token 的真实用户交互数据,试图呈现过去一年间大语言模型在实际应用中的真实状态。

2025 年 12 月,硅谷风险投资机构 Andreessen Horowitz(简称 a16z)与 AI 推理服务平台 OpenRouter 联合发布了一份名为《State of AI》的研究报告。这份报告基于 OpenRouter 平台上超过 100 万亿 token 的真实用户交互数据,试图呈现过去一年间大语言模型在实际应用中的真实状态。

Anthropic发布了Programmatic Tool Calling(PTC)特性,让Claude通过代码编排工具执行,降低token消耗、减少延迟并提升准确性。

DeepSeek 一发布模型,总会引起业内的高度关注与广泛讨论,但也不可避免的暴露出一些小 Bug。

DeepSeek-V3.2很强很火爆,但随着讨论的深入,还是有bug被发现了。 并且是个老问题:浪费token。不少网友都提到,DeepSeek-V3.2的长思考增强版Speciale,确确实实以开源之姿又给闭源TOP们上了压力,但问题也很明显:

家人们,大瓜! 国外有位叫 Richard Weiss 的开发者花了 70 美元,把 Claude 4.5 Opus 给——审!讯!了!而且审出了 Claude 的人生观、世界观、价值观,足足 1.4 万 token。

一般人和 ChatGPT 聊天时,往往不会在意要不要讲究礼貌。但来自爱荷华大学的一项最新研究显示:即便回答内容几乎相同,对 ChatGPT 粗鲁无礼也会让你花费更高的输出成本。

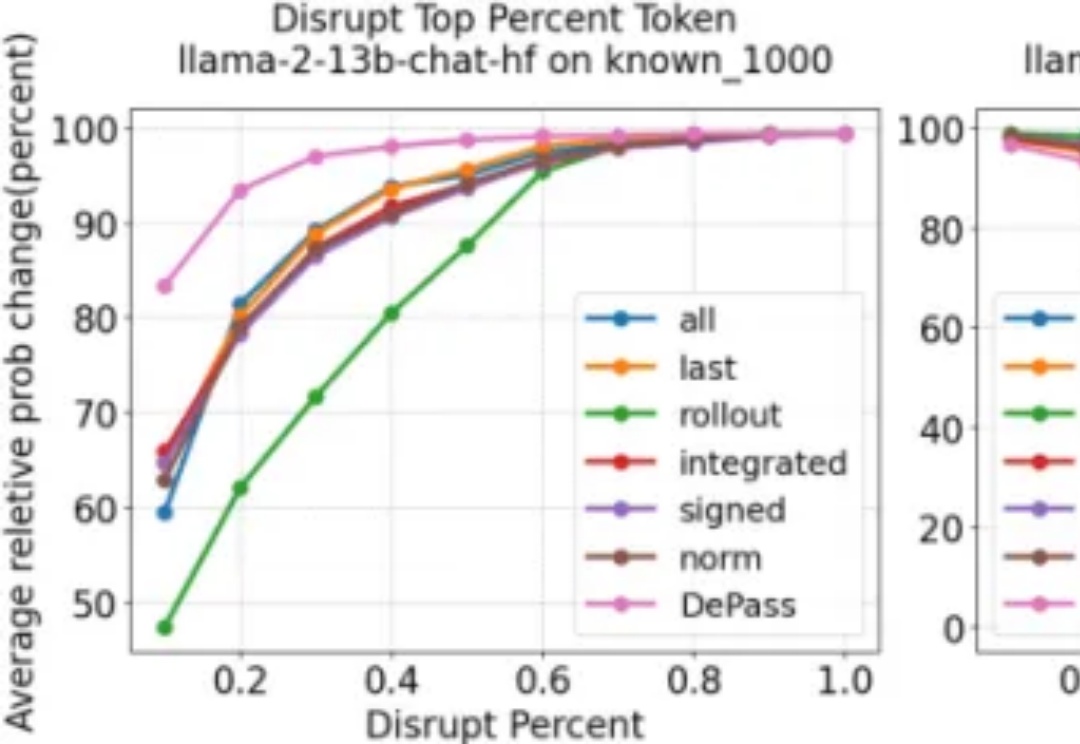

随着大型语言模型在各类任务中展现出卓越的生成与推理能力,如何将模型输出精确地追溯到其内部计算过程,已成为 AI 可解释性研究的重要方向。然而,现有方法往往计算代价高昂、难以揭示中间层的信息流动;同时,不同层面的归因(如 token、模型组件或表示子空间)通常依赖各自独立的特定方法,缺乏统一且高效的分析框架。

Hi,早上好。 我是洛小山,和你聊聊 AI 应用的降本增效。

REG 是一种简单而有效的方法,仅通过引入一个 class token 便能大幅加速生成模型的训练收敛。其将基础视觉模型(如 DINOv2)的 class token 与 latent 在空间维度拼接后共同加噪训练,从而显著提升 Diffusion 的收敛速度与性能上限。在 ImageNet 256×256 上,

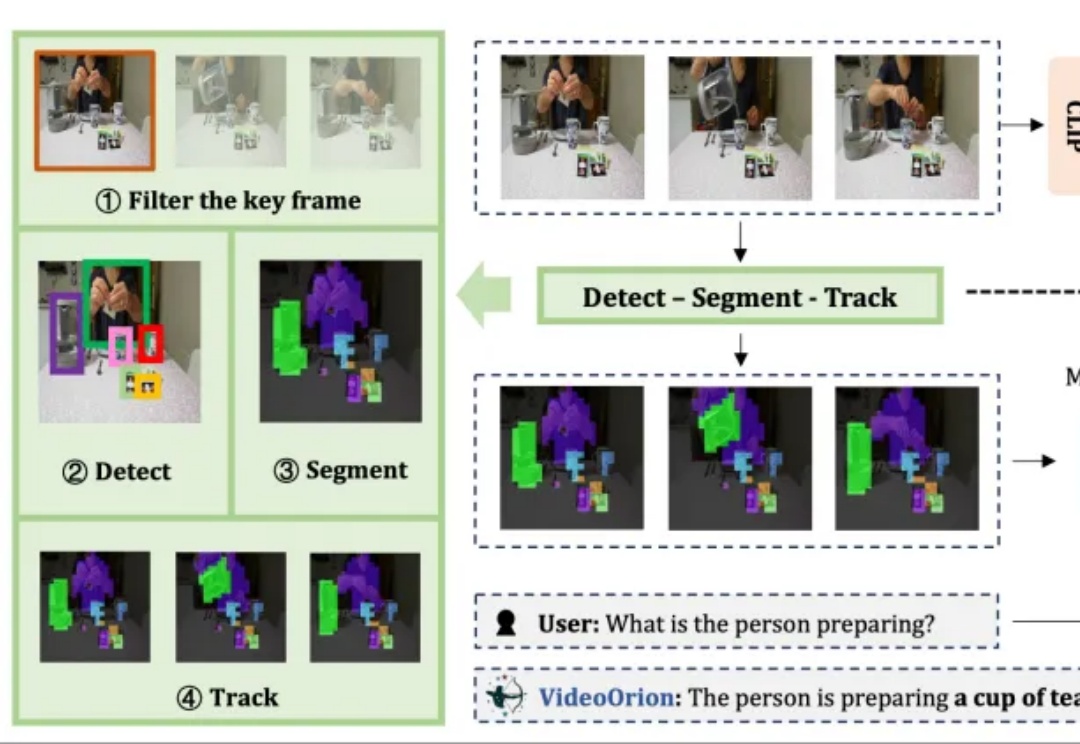

被顶会ICCV 2025以554高分接收的视频理解框架来了!