Tokenization不存在了?Meta最新研究,无需Tokenizer的架构来了

Tokenization不存在了?Meta最新研究,无需Tokenizer的架构来了BLT 在许多基准测试中超越了基于 token 的架构。

BLT 在许多基准测试中超越了基于 token 的架构。

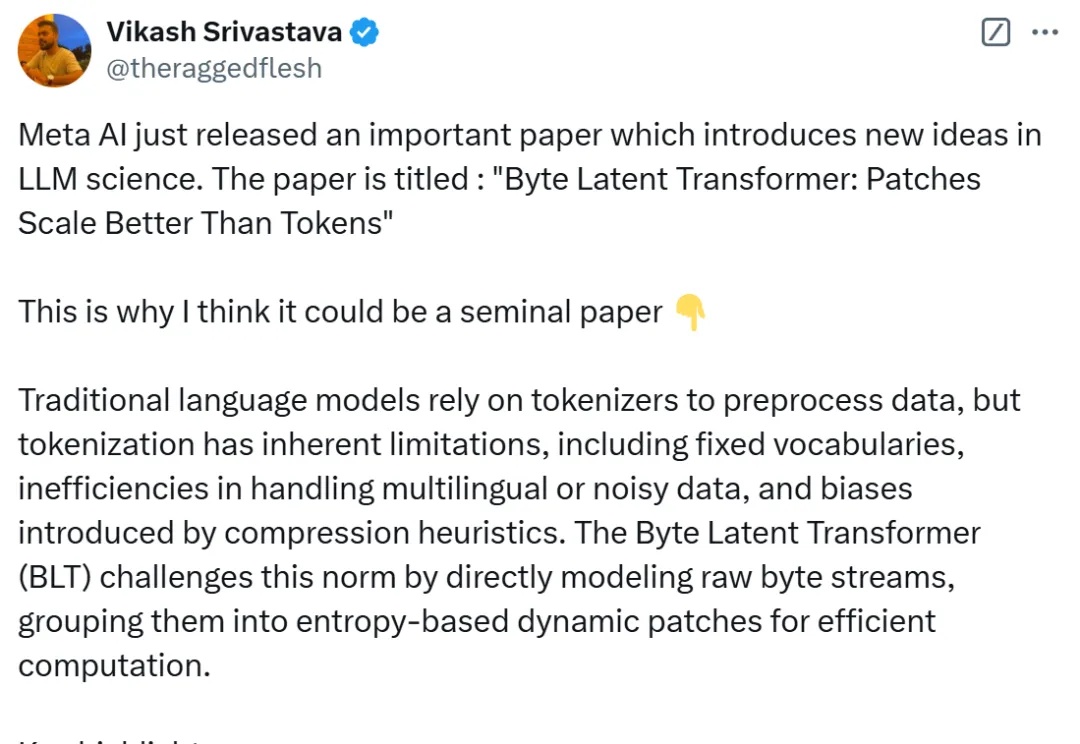

Show Lab 和微软推出 ShowUI,这是一个刚刚开源的 UI Agent 模型,在中文 APP 定位和导航能力上表现出色。通过创新的视觉 token 选择和独特的训练数据构建方法,该模型在有限的训练数据下实现了非常棒的性能。

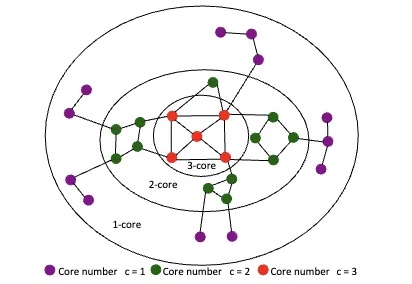

大语言模型直接理解复杂图结构的新方法来了:

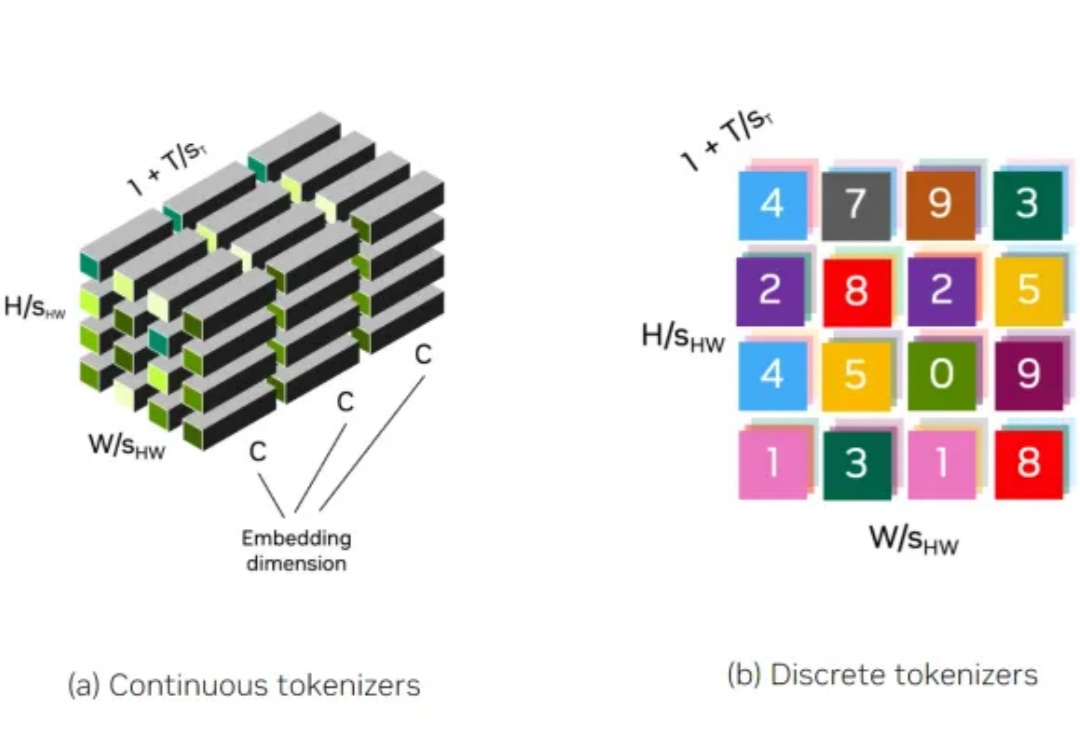

tokenizer对于图像、视频生成的重要性值得重视。

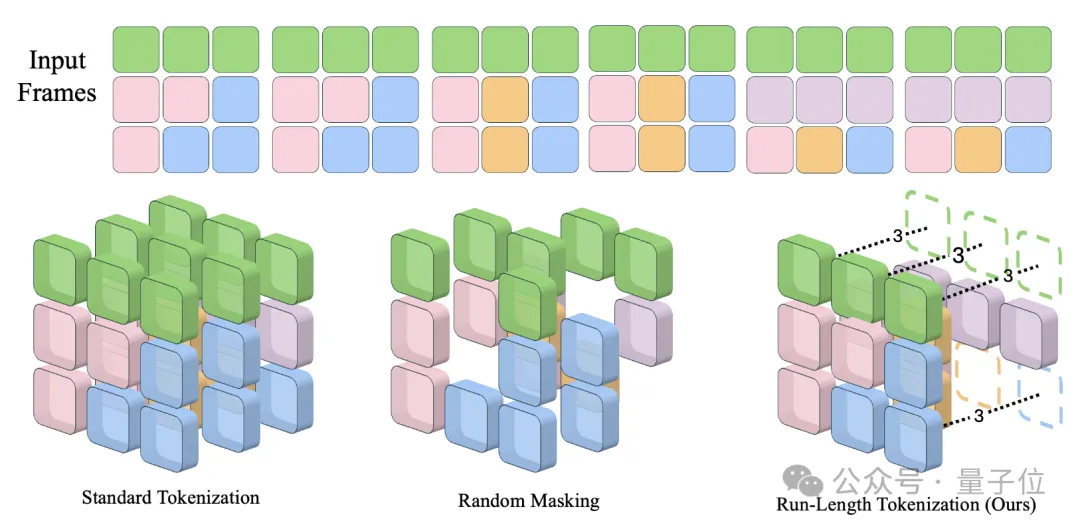

卡内基梅隆大学提出了视频生成模型加速方法Run-Length Tokenization(RLT),被NeurIPS 2024选为Spotlight论文。 在精度几乎没有损失的前提下,RLT可以让模型训练和推理速度双双提升。

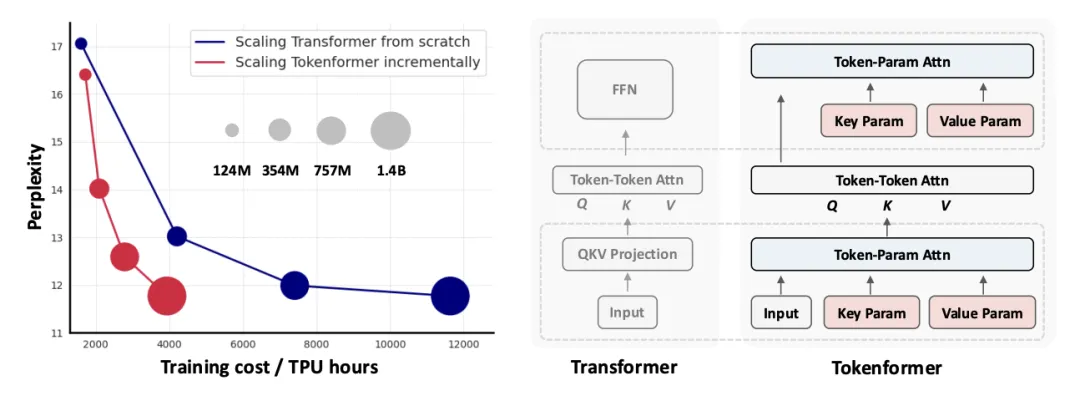

新一代通用灵活的网络结构 TokenFormer: Rethinking Transformer Scaling with Tokenized Model Parameters 来啦!

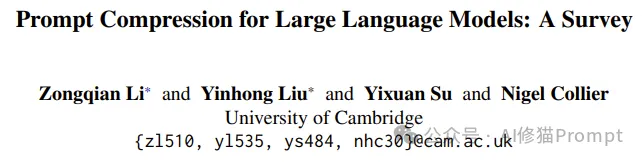

别说Prompt压缩不重要,你可以不在乎Token成本,但总要考虑内存和LLM响应时间吧?一个显著的问题逐渐浮出水面:随着任务复杂度增加,提示词(Prompt)往往需要变得更长,以容纳更多详细需求、上下文信息和示例。这不仅降低了推理速度,还会增加内存开销,影响用户体验。

TL;DR:DuoAttention 通过将大语言模型的注意力头分为检索头(Retrieval Heads,需要完整 KV 缓存)和流式头(Streaming Heads,只需固定量 KV 缓存),大幅提升了长上下文推理的效率,显著减少内存消耗、同时提高解码(Decoding)和预填充(Pre-filling)速度,同时在长短上下文任务中保持了准确率。

OpenAI前首席科学家、联合创始人Ilya Sutskever曾在多个场合表达观点: 只要能够非常好的预测下一个token,就能帮助人类达到通用人工智能(AGI)。

OpenAI 前首席科学家、联合创始人 Ilya Sutskever 曾在多个场合表达观点:只要能够非常好的预测下一个 token,就能帮助人类达到通用人工智能(AGI)。