港科大Apple新研究:Tokens使用量减少,模型推理还更强了

港科大Apple新研究:Tokens使用量减少,模型推理还更强了1+1等于几?

1+1等于几?

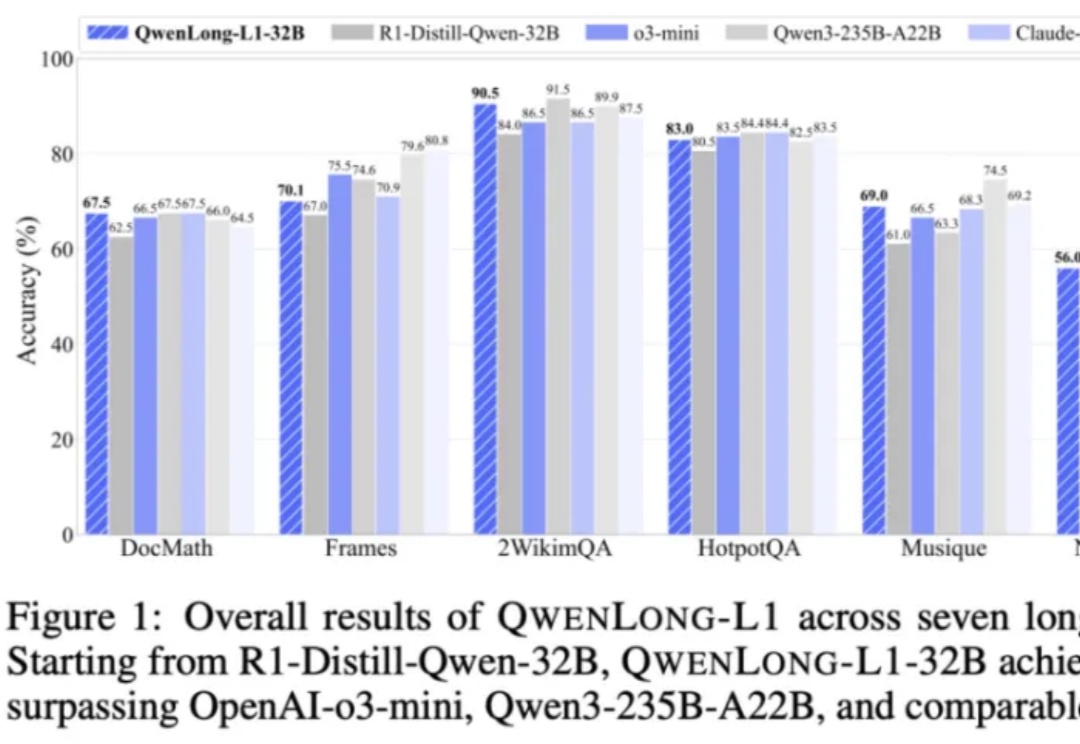

上下文长度达 13 万 token,适用于多段文档综合分析、金融、法律、科研等复杂领域任务。

是的,秘塔AI搜索推出了全新“极速”模型。通过在GPU上进行kernel fusion,以及在CPU上进行动态编译优化,我们在单张H800 GPU上实现了最高400 tokens/秒的响应速度,大部分问题2秒内就能答完。

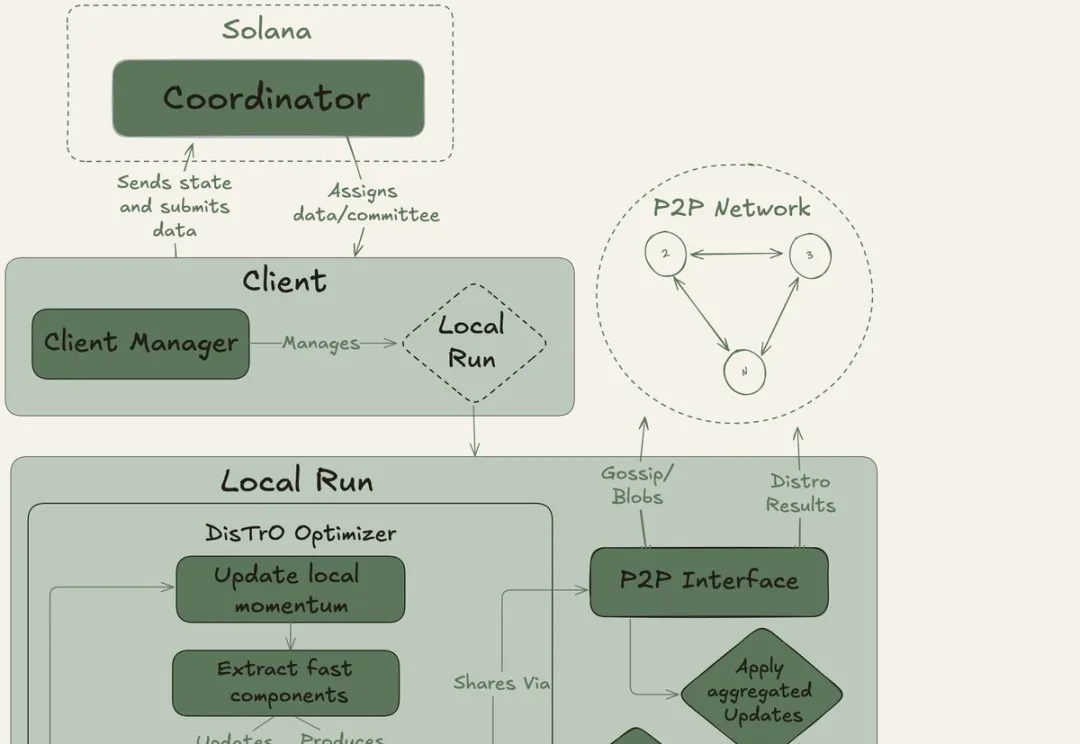

全球网友用闲置显卡组团训练大模型。40B大模型、20万亿token,创下了互联网上最大规模的预训练新纪录!去中心化AI的反攻,正式开始。OpenAI等巨头的算力霸权,这次真要凉了?

年仅19岁少年,自称破解了谷歌最快的语言模型Gemini Diffusion,引爆社交平台。真相扑朔迷离,但有一点毫无疑问:谷歌I/O大会的「黑马」,比GPT快10倍的速度、媲美人类程序员的代码能力,正在掀起一场NLP范式大洗牌。

英伟达,亲手打破了自己的天花板!刚刚,Blackwell单用户每秒突破了1000个token,在Llama 4 Maverick模型上,再次创下了AI推理的世界纪录。在官博中,团队放出了不少绝密武器。

谷歌又放新大招了,将图像生成常用的“扩散技术”引入语言模型,12秒能生成1万tokens。

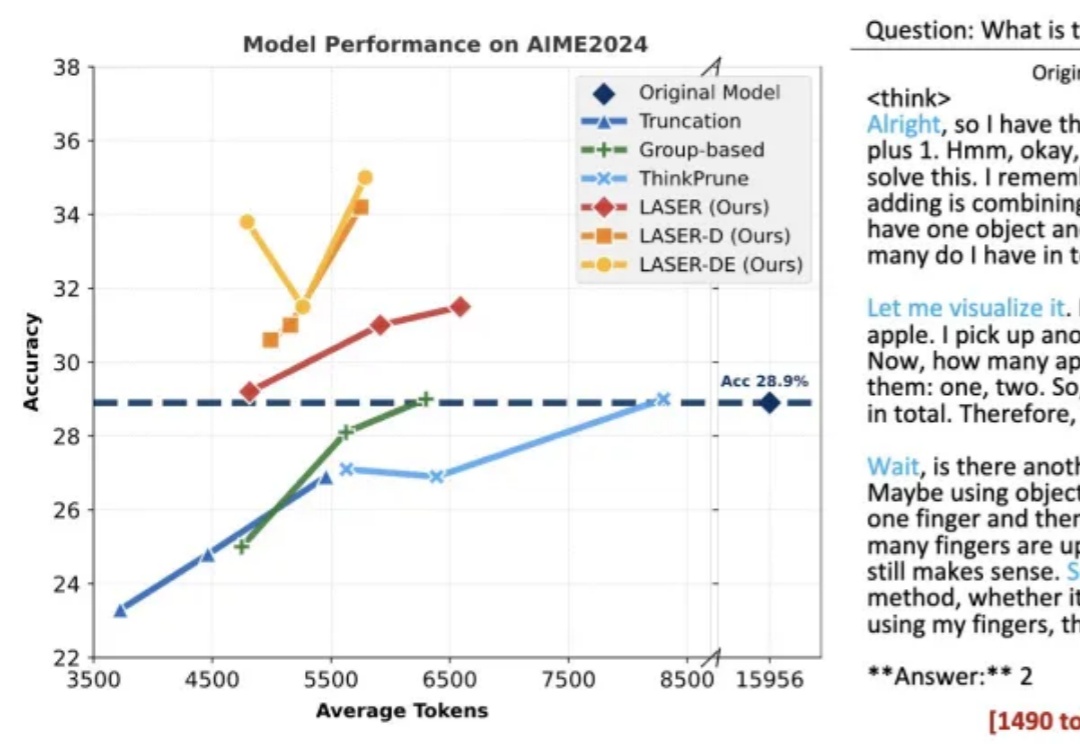

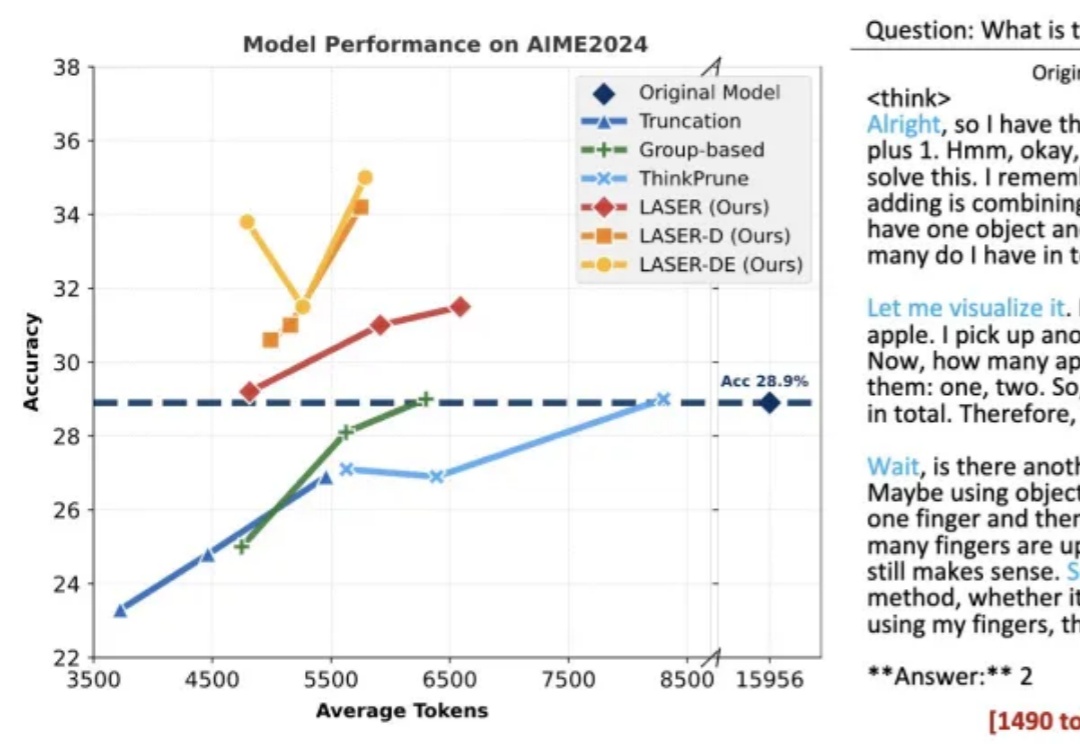

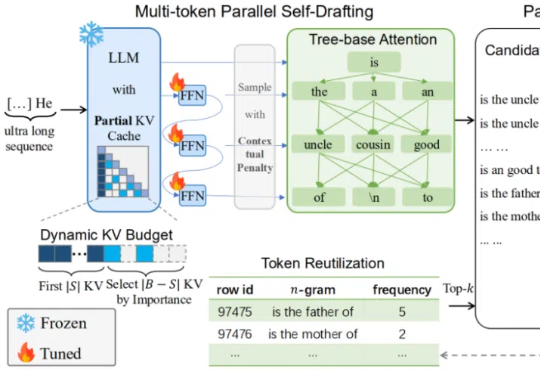

在当前大模型推理愈发复杂的时代,如何快速、高效地产生超长文本,成为了模型部署与优化中的一大核心挑战。

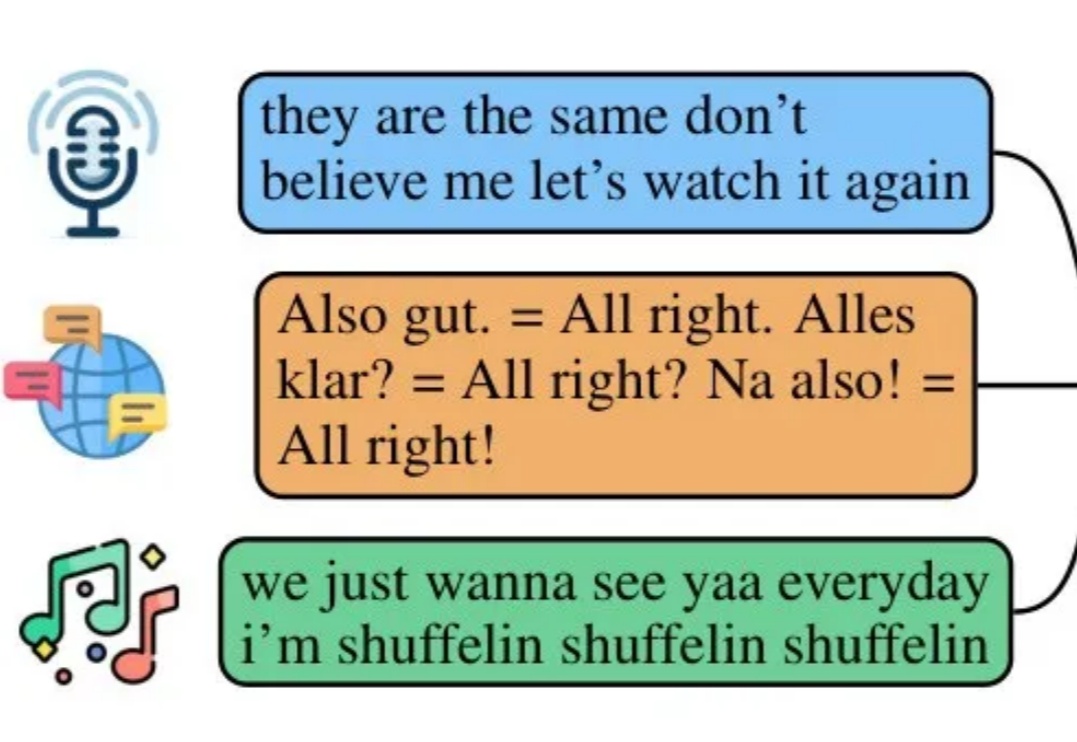

自回归(AR)范式凭借将语言转化为离散 token 的核心技术,在大语言模型领域大获成功 —— 从 GPT-3 到 GPT-4o,「next-token prediction」以简单粗暴的因果建模横扫语言领域。

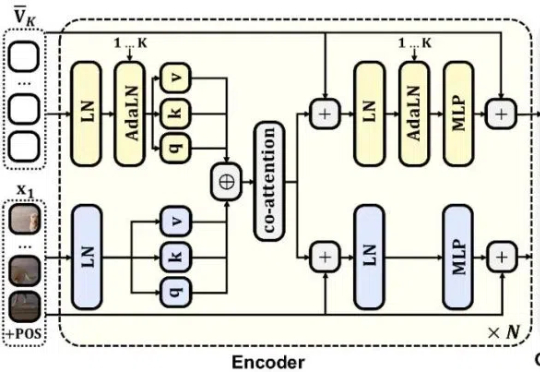

搞RAG开发,一个被普遍忽视却又至关重要的痛点是:如何避免Token分块带来的语义割裂问题。SAT模型通过神经网络驱动的智能分段技术,巧妙解决了这一难题。它不是RAG的替代,而是RAG的强力前置增强层,通过确保每个文本块的语义完整性,显著降低下游生成的幻觉风险。