张俊林:OpenAI o1的价值意义及强化学习的Scaling Law

张俊林:OpenAI o1的价值意义及强化学习的Scaling Law蹭下热度谈谈 OpenAI o1 的价值意义及 RL 的 Scaling law。

蹭下热度谈谈 OpenAI o1 的价值意义及 RL 的 Scaling law。

近段时间,AI 编程工具 Cursor 的风头可说是一时无两,其表现卓越、性能强大。近日,Cursor 一位重要研究者参与的一篇相关论文发布了,其中提出了一种方法,可通过搜索自然语言的规划来提升 Claude 3.5 Sonnet 等 LLM 的代码生成能力。

不必增加模型参数,计算资源相同,小模型性能超过比它大14倍的模型!

大模型时代,有个大家普遍焦虑的问题:如何落地?往哪落地?

2023 年,Anthropic 发布了负责任扩展策略(Responsible Scaling Policy,RSP),这是一系列技术和组织协议,Anthropic 将采用这些协议来帮助他们管理开发功能日益强大的 AI 系统。

9 月 2 日,马斯克发文称,其人工智能公司 xAI 的团队上线了一台被称为「Colossus」的训练集群,总共有 100000 个英伟达的 H100 GPU。

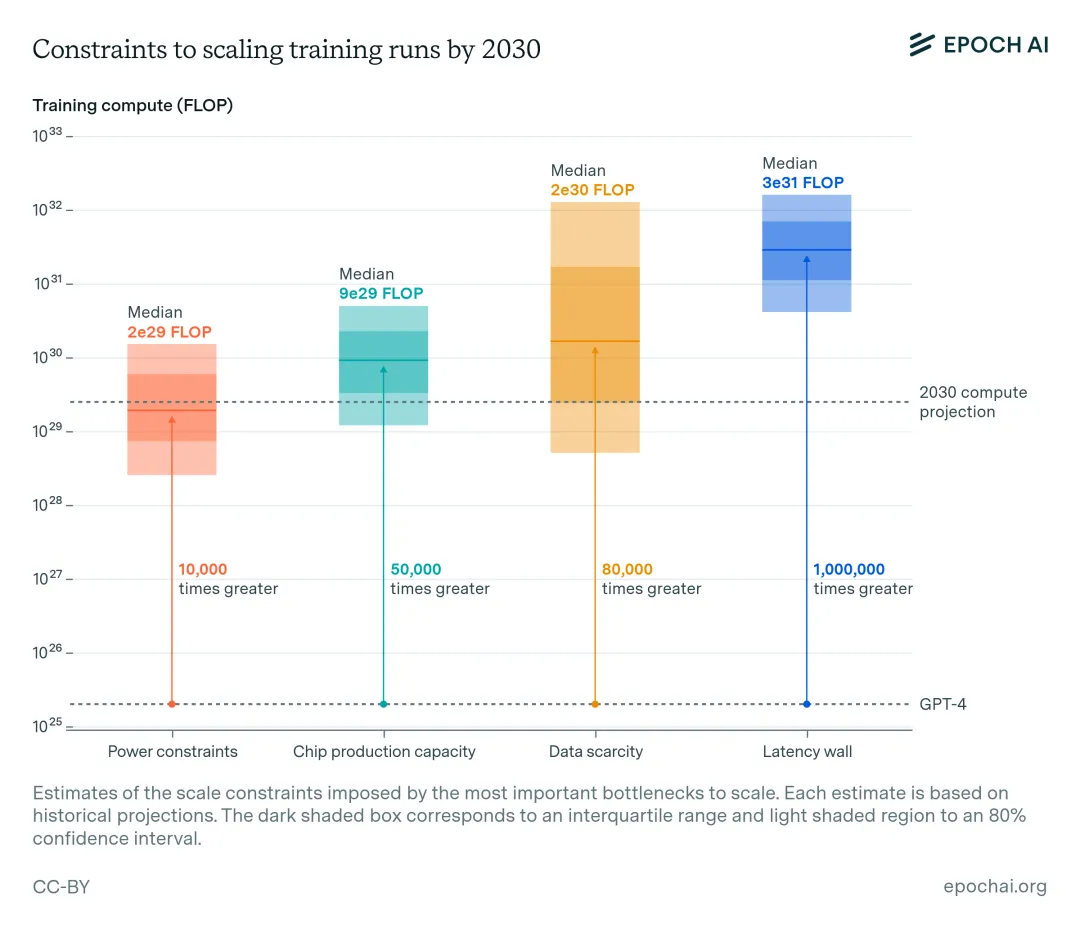

沿着 Scaling Law、卷模型性能,可能会走到「死胡同」。

沿着 Scaling Law、卷模型性能,可能会走到「死胡同」。 谁在影响、定义我们的时代?他们做了什么,如何思考?对话关键人物,记录历史底稿。 我们被倡导要想明白自己的目标是什么、并做出计划。然而,两位人工智能研究者却认为,这只适用于普通的小愿望。

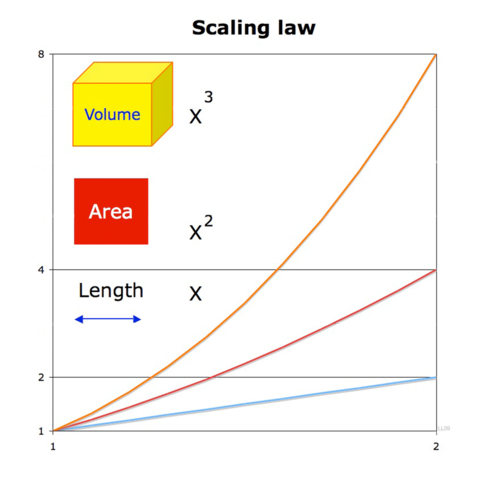

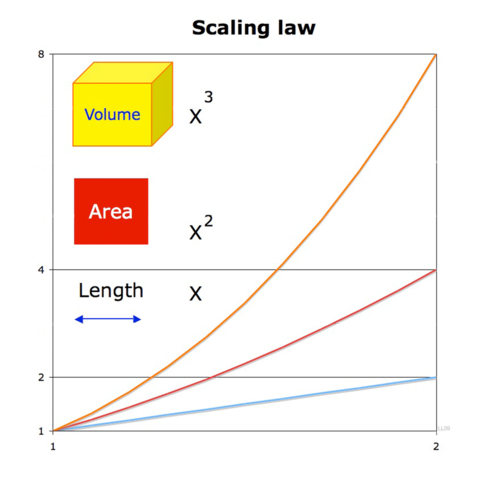

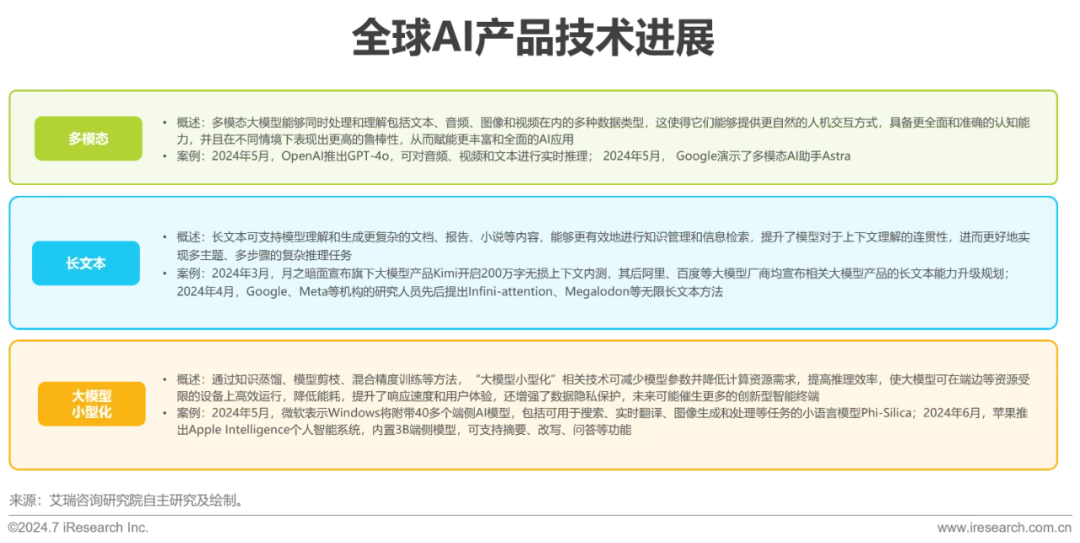

近年来,Transformer等预训练大模型在语言理解及生成等领域表现出色,大模型背后的Scaling Law(规模定律)进一步揭示了模型性能与数据量、算力之间的关系,强化了数据在提升AI表现中的关键作用。

AnyGraph聚焦于解决图数据的核心难题,跨越多种场景、特征和数据集进行预训练。其采用混合专家模型和特征统一方法处理结构和特征异质性,通过轻量化路由机制和高效设计提升快速适应能力,且在泛化能力上符合Scaling Law。