o3崛起,但推理模型离「撞墙」只剩一年?

o3崛起,但推理模型离「撞墙」只剩一年?OpenAI的o3推理模型席卷AI界,算力暴增10倍,能力突飞猛进!但专家警告:最多一年,推理模型可能一年内撞上算力资源极限。OpenAI还能否带来惊喜?

OpenAI的o3推理模型席卷AI界,算力暴增10倍,能力突飞猛进!但专家警告:最多一年,推理模型可能一年内撞上算力资源极限。OpenAI还能否带来惊喜?

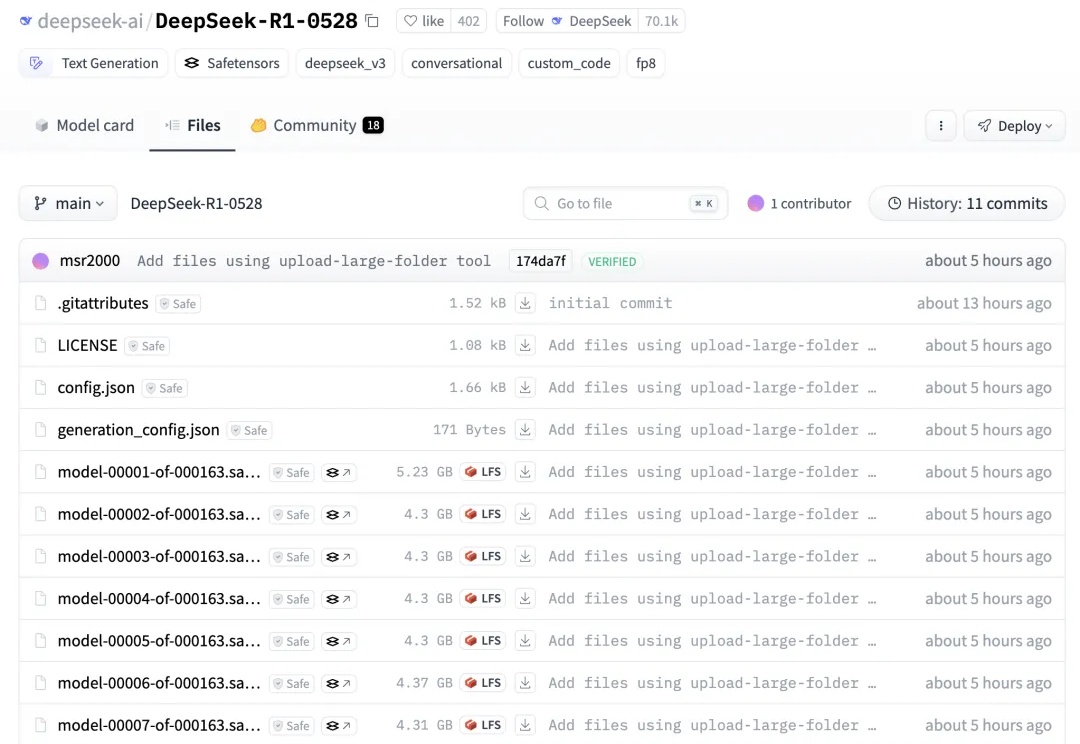

昨晚,终于等到了DeepSeek-R1-0528官宣。升级后的模型性能直逼o3和Gemini 2.5 Pro。如今,DeepSeek真正坐实了全球开源王者的称号,并成为了第二大AI实验室。

新版DeepSeek-R1重磅开源,凌晨已放出权重!此次模型性能几乎与o4-mini(Medium)相当,编程实测超越Claude 4 Sonnet。网友纷纷惊叹:开源又一次胜利了。

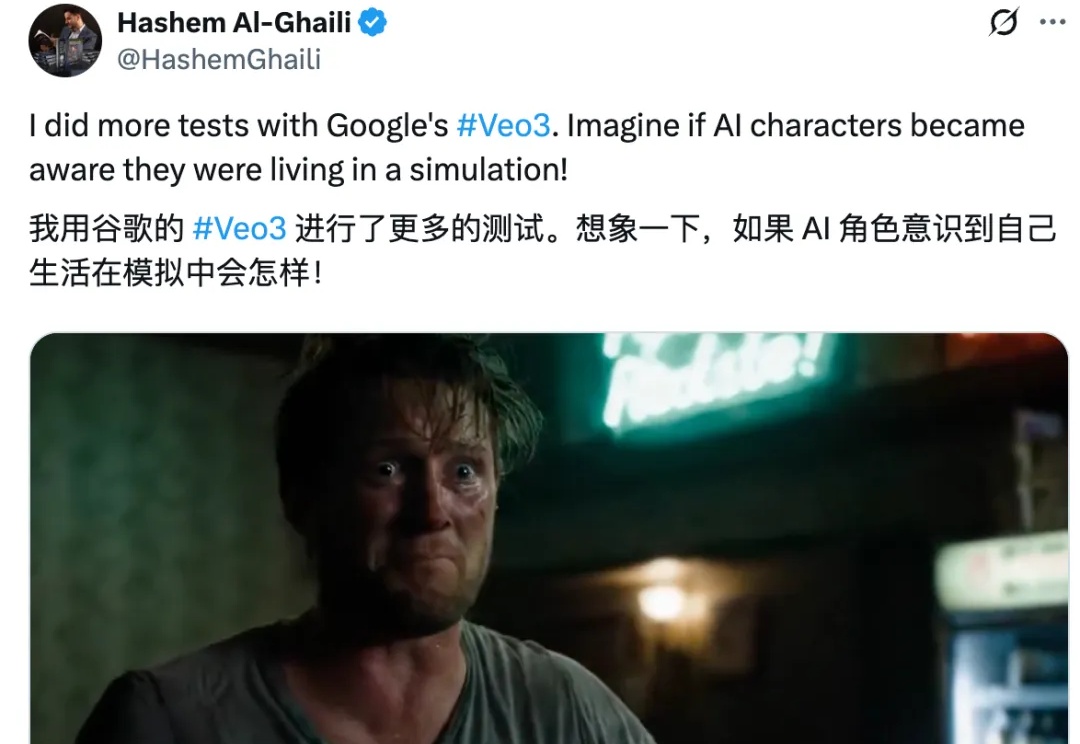

上周的开发者大会,谷歌冷不丁地掏出个 Veo3 就惊艳了全球。

近半年来,OpenAI 形象开始变得灰暗: 团队骨干相继离职引发猜疑、组织转型遭受口诛笔伐、GPT-4.5/Sora 等模型表现不及预期,还有被 DeepSeek R1 打破的叙事神话……

Google I/O 2025 结束后,Google CEO Sundar Pichai 接受了《The Verge》主编专访,这也是双方连续第三年于 I/O 后展开对谈,而今年的背景更为特殊:Gemini 模型全面更新、多模态生成工具 Veo3 登场、AI 功能深度融入 Android 与 XR 平台,Google 展现出前所未有的产品化信心。

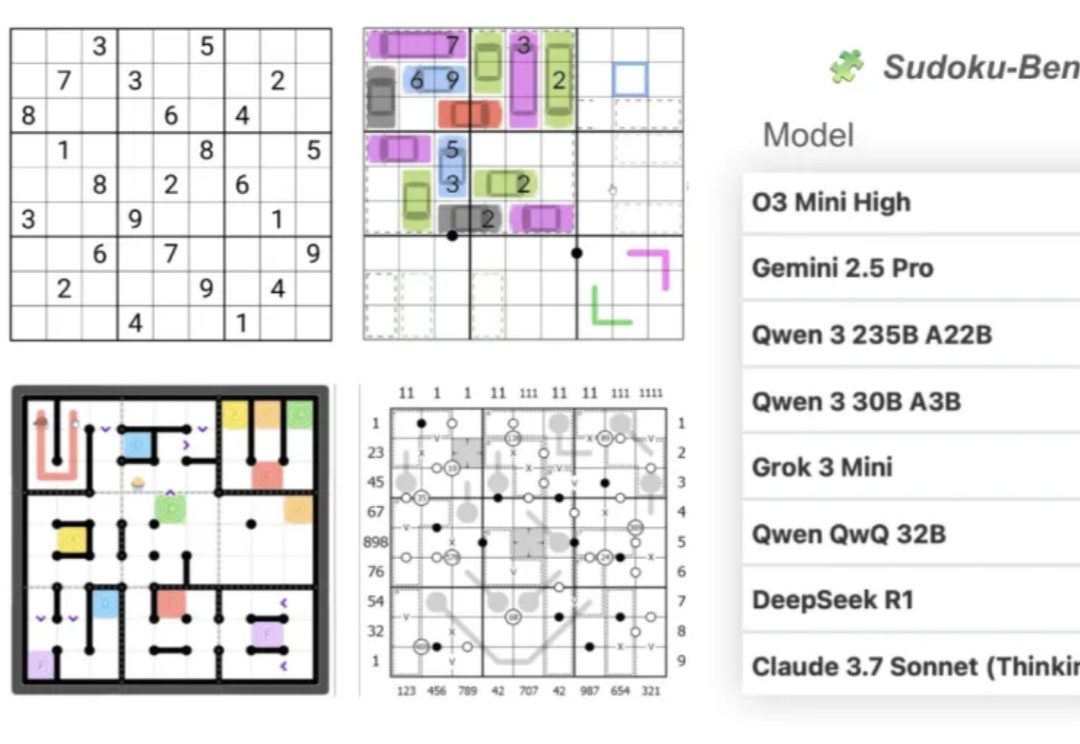

大模型做数独,总体正确率只有15%???

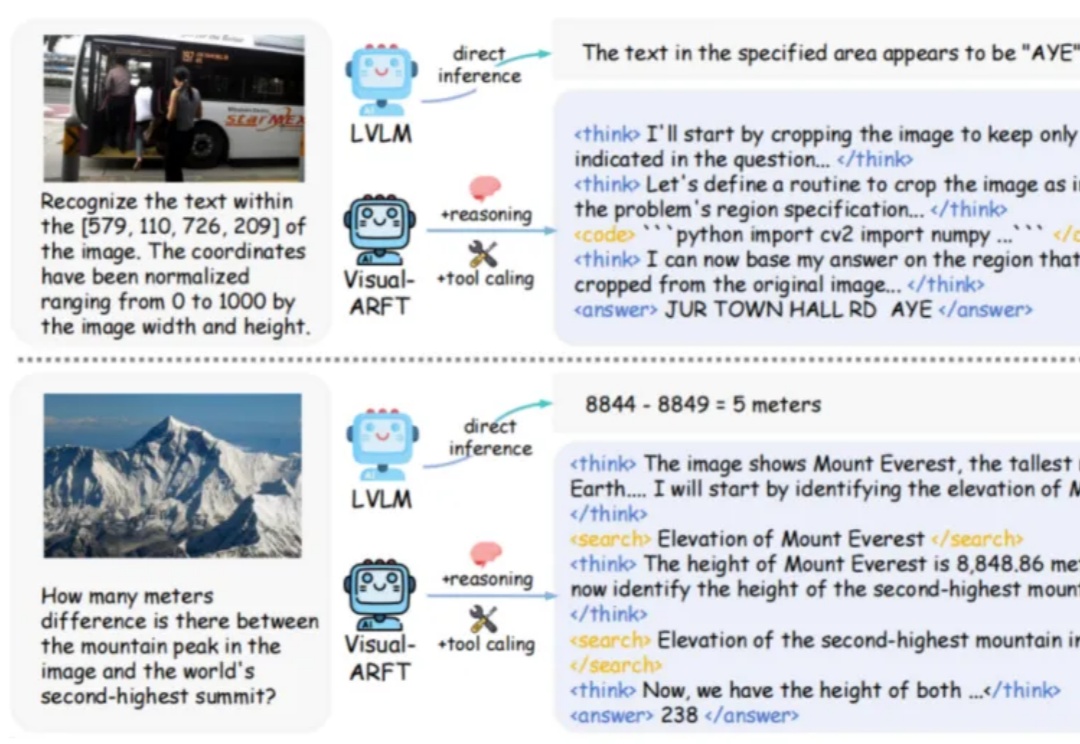

在大型推理模型(例如 OpenAI-o3)中,一个关键的发展趋势是让模型具备原生的智能体能力。具体来说,就是让模型能够调用外部工具(如网页浏览器)进行搜索,或编写/执行代码以操控图像,从而实现「图像中的思考」。

AI居然不听指令,阻止人类把自己给关机了???

大家好,我是袋鼠帝 还记得前两天Google IO大会上他们发布的最新视频模型Veo3吗 它可以根据提示自动添加环境音效、背景噪声、音乐和对话,并与画面完美同步 而且生成的视频相当炸裂,已经让我有点分不清虚幻与现实了 比如这位推特大神(Hashem Al-Ghaili)用Veo3制作的视频,相当🐂🍺