杨植麟回复:Kimi K2训练用的H800!但“只花了460万美元”嘛…

杨植麟回复:Kimi K2训练用的H800!但“只花了460万美元”嘛…Kimi K2 Thinking训练真的只花了460万美元?杨植麟亲自带队,月之暗面创始团队出面回应了。这不是官方数据。训练成本很难计算,因为其中很大一部分用于研究和实验。他们还透露训练使用了配备Infiniband的英伟达H800,GPU数量也比巨头的少,但充分利用了每一张卡。

Kimi K2 Thinking训练真的只花了460万美元?杨植麟亲自带队,月之暗面创始团队出面回应了。这不是官方数据。训练成本很难计算,因为其中很大一部分用于研究和实验。他们还透露训练使用了配备Infiniband的英伟达H800,GPU数量也比巨头的少,但充分利用了每一张卡。

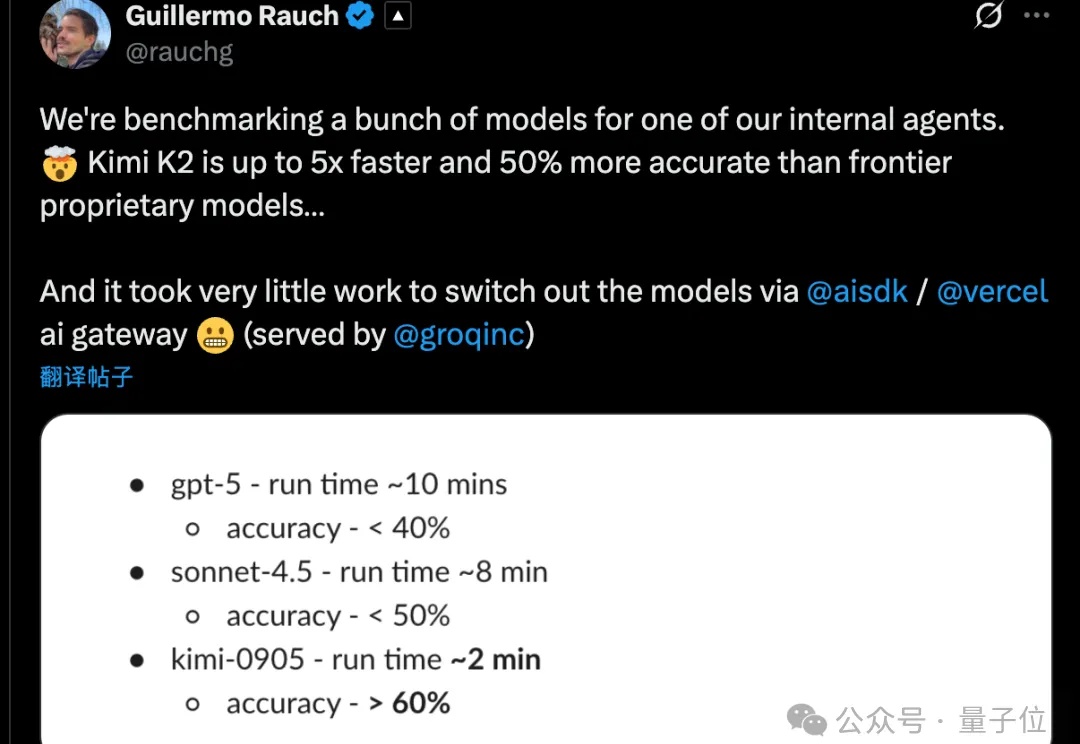

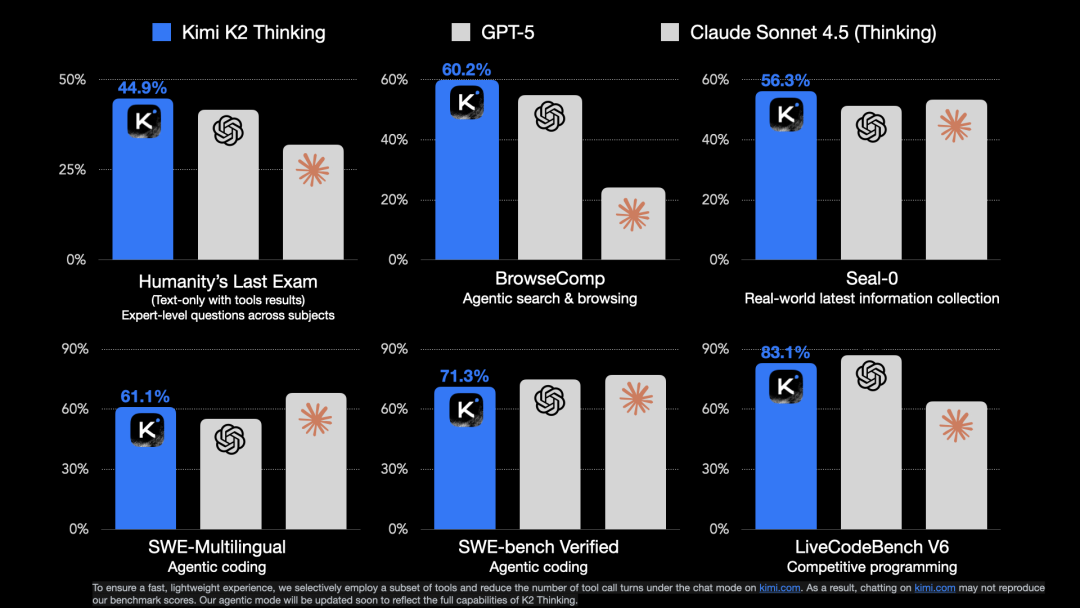

上周 Kimi K2 Thinking 发布,开源模型打败 OpenAI 和 Anthropic,让它社交媒体卷起不小的声浪,网友们都在说它厉害,我们也实测了一波,在智能体、代码和写作能力上确实进步明

2025年前盛行的闭源+重资本范式正被DeepSeek-R1与月之暗面Kimi K2 Thinking改写,二者以数百万美元成本、开源权重,凭MoE与MuonClip等优化,在SWE-Bench与BrowseComp等基准追平或超越GPT-5,并以更低API价格与本地部署撬动市场预期,促使行业从砸钱堆料转向以架构创新与稳定训练为核心的高效路线。

前段时间Trae下架了Claude,标志着但凡跟中国沾边AI工具都禁止使用 Claude 但我一点都不慌,因为已经很久没用 Claude 了 尤其在编程赛道上,国产大模型已经通过内部互卷站起来了。

昨天,月之暗面发布全新模型Kimi K2 Thinking,一上线就挤爆了服务器。思考,是它的核心卖点,自称是开源的「思考Agent模型」。在Tau2 Bench Telecom基准测试中,K2 Thinking位列第一。

Kimi K2 Thinking,现已发布并开源!

四个月前 Kimi 发布了 K2 模型,凭借优秀的质量以及先进的架构优化,一举打破了持续了几个月关于月之暗面的质疑。 我当时也写了两篇测评《Kimi K2 详测|超强代码和Agent 能力!内附Cla

微调超大参数模型,现在的“打开方式”已经大变样了: 仅需2-4 张消费级显卡(4090),就能在本地对DeepSeek 671B乃至Kimi K2 1TB这样的超大模型进行微调了。

新乐子来了。 10个AI大模型,券商账户实时交易,勇闯美股。 除了老面孔GPT、Claude、Gemini、Grok、Qwen、DeepSeek,这次四个国产新玩家,豆包、Minimax、Kimi、文心也加入战场。昨晚,首战正式开赛,豆包已经一马当先,开始了开门红。

月之暗面最新发布的开源Kimi Linear架构,用一种全新的注意力机制,在相同训练条件下首次超越了全注意力模型。在长上下文任务中,它不仅减少了75%的KV缓存需求,还实现了高达6倍的推理加速。