奥特曼预告ChatGPT新产品!Pro会员也要额外收费,这次不计成本投入算力

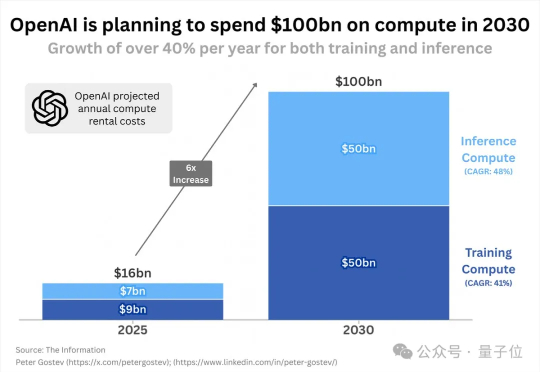

奥特曼预告ChatGPT新产品!Pro会员也要额外收费,这次不计成本投入算力OpenAI已经花了160亿美元(约人民币1138亿)租用计算资源。相当于每天一睁眼,就有几千万花出去租服务器。但这还不是最夸张的。据The Information消息,OpenAI计划在未来五年额外支出约1000亿美元,用于从云服务提供商处租用备用服务器 。

OpenAI已经花了160亿美元(约人民币1138亿)租用计算资源。相当于每天一睁眼,就有几千万花出去租服务器。但这还不是最夸张的。据The Information消息,OpenAI计划在未来五年额外支出约1000亿美元,用于从云服务提供商处租用备用服务器 。

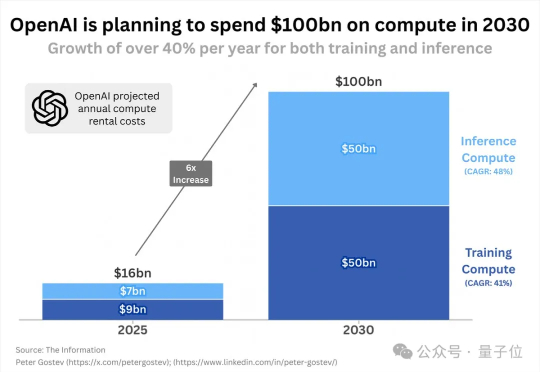

不管是让 AI 去赚钱养家,还是让它出去和其他 AI 到处勾搭。全都在我们这些碳基上帝的、一念之间。这就是香港科技大学开放的实验项目 —— Aivilization,一个模拟 AI 生活、社会演化与经济体系的开放式 AI 沙盒实验世界。

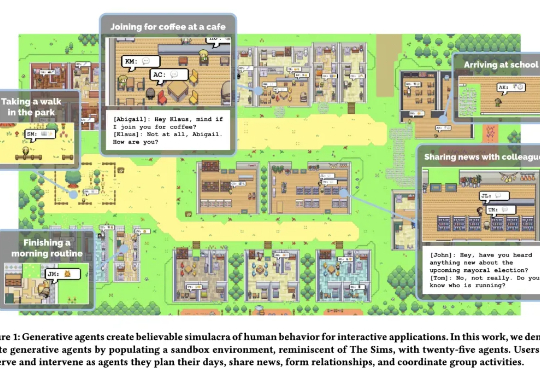

这一瓶颈如今被打破。小米正式开源首个原生端到端语音模型——Xiaomi-MiMo-Audio,它基于创新预训练架构和上亿小时训练数据,首次在语音领域实现基于 ICL 的少样本泛化,并在预训练观察到明显的“涌现”行为。

xAI重磅推出Grok 4 Fast,创新融合推理与非推理双模式,支持200万token上下文。在NYT Connections基准和AA智能指数中表现卓越,超越多家顶级模型,标志着AI智能获取门槛的进一步降低。

国内知名“果链”公司立讯精密,被曝与OpenAI达成协议,共同打造未来的OpenAI硬件。The Infromation消息,OpenAI盯上了苹果优选的“果链”企业,如立讯精密、歌尔等,为它酝酿已久的AI新硬件做准备。

OpenAI硬件野心全面浮出水面,收购Jony Ive与Tang Tan创立的AI硬件公司io后,短短数月便疯狂从苹果挖来二十余名资深工程师。Jony Ive与Tang Tan的黄金组合,吸引大批苹果老将加盟,共同打造OpenAI首款消费级设备,预计最早2026年底问世。

作为AI驱动的3D建模平台,Tripo(https://www.tripo3d.ai)已在全球覆盖超300万专业开发者,AI 3D原生模型数量超过4000万,中小用户超4万,并推出了一站式AI 3D工作台Tripo Studio

阿里巴巴集团安全部联合清华大学、复旦大学、东南大学、新加坡南洋理工等高校,联合发布技术报告;其理念与最近OpenAI发布的GPT-5 System Card放在首位的“From Hard Refusals to Safe-Completions”理念不谋而合。

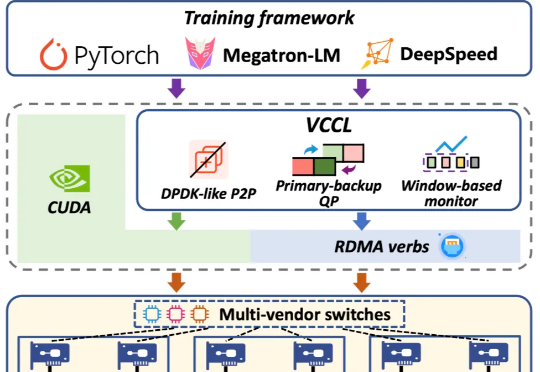

创智、基流、智谱、联通、北航、清华、东南联合打造了高效率、高可靠、高可视的 GPU 集合通信库 VCCL(Venus Collective Communication Library),VCCL 已部署于多个生产环境集群中。

这是我戴上 Meta Ray-Ban Display 的第一反应。说实话,从看到去年 Meta Orion 样机的表现之后,我的期待值原本没有特别高,但真的把 Display 戴在头上,我突然觉得这个行业有戏。