微信接入DeepSeek后,腾讯正在把产品all in AI

微信接入DeepSeek后,腾讯正在把产品all in AI在AI时代,腾讯的新人设是拥有“后发优势”的拳手

来自主题: AI资讯

4655 点击 2025-02-21 09:15

在AI时代,腾讯的新人设是拥有“后发优势”的拳手

端侧AI元年模组正在破局DeepSeek在实体产业落地的最后一公里。

DeepSeek步步紧逼,美股五巨头走下神坛。

Deepseek横空出世,讨论热潮也持续了半个月之久:从deepseek霸榜全球应用商店,到各种卖AI课、用deepseek算八字、老年人用AI写诗、让AI模仿鲁迅锐评...... 这些我都微微一笑,没什么好吃惊的。

赋能行业前景广阔,但AI在能源领域的规模应用仍面临一系列挑战。

DeepSeek的风,也是飘到了科研领域——

近两个月,AI圈像开了倍速一样,可以说是卷疯了......

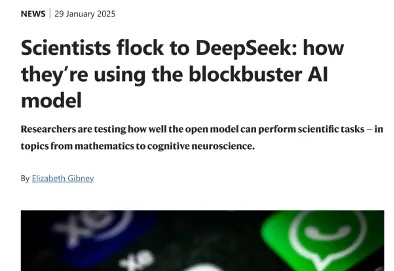

又是一个文理兼修的优等生,能薅一点是一点。堆了 20 万张 GPU、号称「地表最强」大模型 Grok-3 已经可用啦。「 Grok 3 + Thinking 感觉与 OpenAI 最强商用模型(o1-pro,200 美元/月)的顶尖水平相差无几,

DeepSeek时代,AI厂商的集体反思

仅需简单提示,满血版DeepSeek-R1美国数学邀请赛AIME分数再提高。