出海应用也能享受高速稳定的DeepSeek-R1?亚马逊云科技出手了

出海应用也能享受高速稳定的DeepSeek-R1?亚马逊云科技出手了给大模型落地,加入极致的务实主义。

给大模型落地,加入极致的务实主义。

尽管 DeepSeek-R1 在单模态推理中取得了显著成功,但已有的多模态尝试(如 R1-V、R1-Multimodal-Journey、LMM-R1)尚未完全复现其核心特征。

最新研究显示,以超强推理爆红的DeepSeek-R1模型竟藏隐形危险——

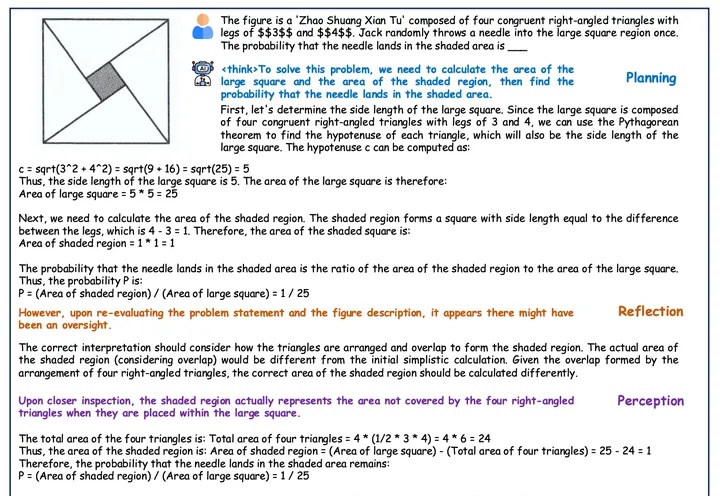

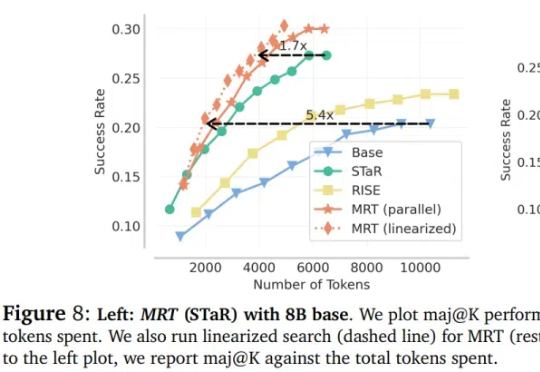

大语言模型(LLM)在推理领域的最新成果表明了通过扩展测试时计算来提高推理能力的潜力,比如 OpenAI 的 o1 系列。

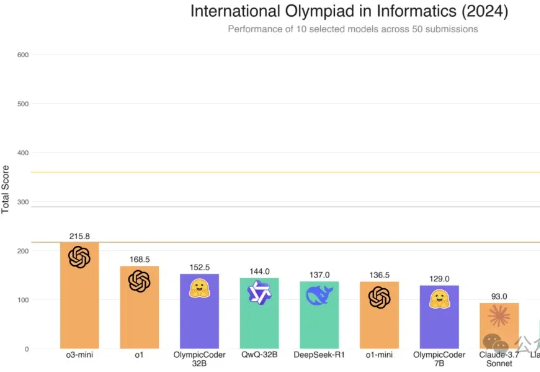

Hugging Face的Open R1重磅升级,7B击败Claude 3.7 Sonnet等一众前沿模型。凭借CodeForces-CoTs数据集的10万高质量样本、IOI难题的严苛测试,以及模拟真实竞赛的提交策略优化,这款模型展现了惊艳的性能。

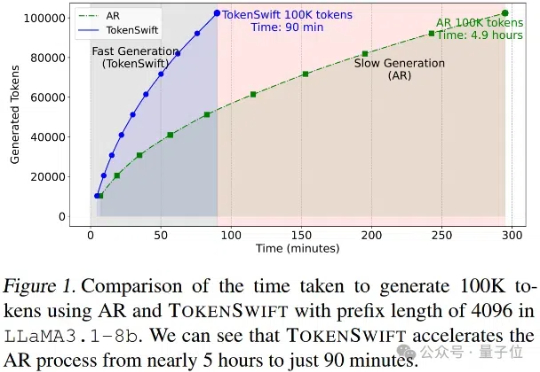

大语言模型长序列文本生成效率新突破——生成10万Token的文本,传统自回归模型需要近5个小时,现在仅需90分钟!

今天凌晨,亚马逊云科技宣布在Amazon Bedrock平台上推出全托管、无服务器的DeepSeek-R1模型,是首个提供DeepSeek-R1作为全托管、正式商用模型的海外云厂商。

开源微调神器Unsloth带着黑科技又来了:短短两周后,再次优化DeepSeek-R1同款GRPO训练算法,上下文变长10倍,而显存只需原来的1/10!

近年来,大语言模型(LLM) 的快速发展正推动人工智能迈向新的高度。像 DeepSeek-R1 这样的模型因其强大的理解和生成能力,已经在 对话生成、代码编写、知识问答 等任务中展现出了卓越的表现。

DeepSeek-R1 等模型通过展示思维链(CoT)让用户一窥大模型的「思考过程」,然而,模型展示的思考过程真的代表了模型的内在推理机制吗?在医疗诊断、自动驾驶、法律判决等高风险领域,我们能否真正信任 AI 的决策?