英伟达RTX5090规格曝光,自带32GB GDDR7内存

英伟达RTX5090规格曝光,自带32GB GDDR7内存上周末,外媒 VideoCardz 获得了一张非公版 RTX 5090 的包装盒照片,实锤了新一代旗舰显卡将使用 32GB GDDR7 显存。

上周末,外媒 VideoCardz 获得了一张非公版 RTX 5090 的包装盒照片,实锤了新一代旗舰显卡将使用 32GB GDDR7 显存。

奥特曼说,Sora代表了视频生成大模型的GPT-1时刻。

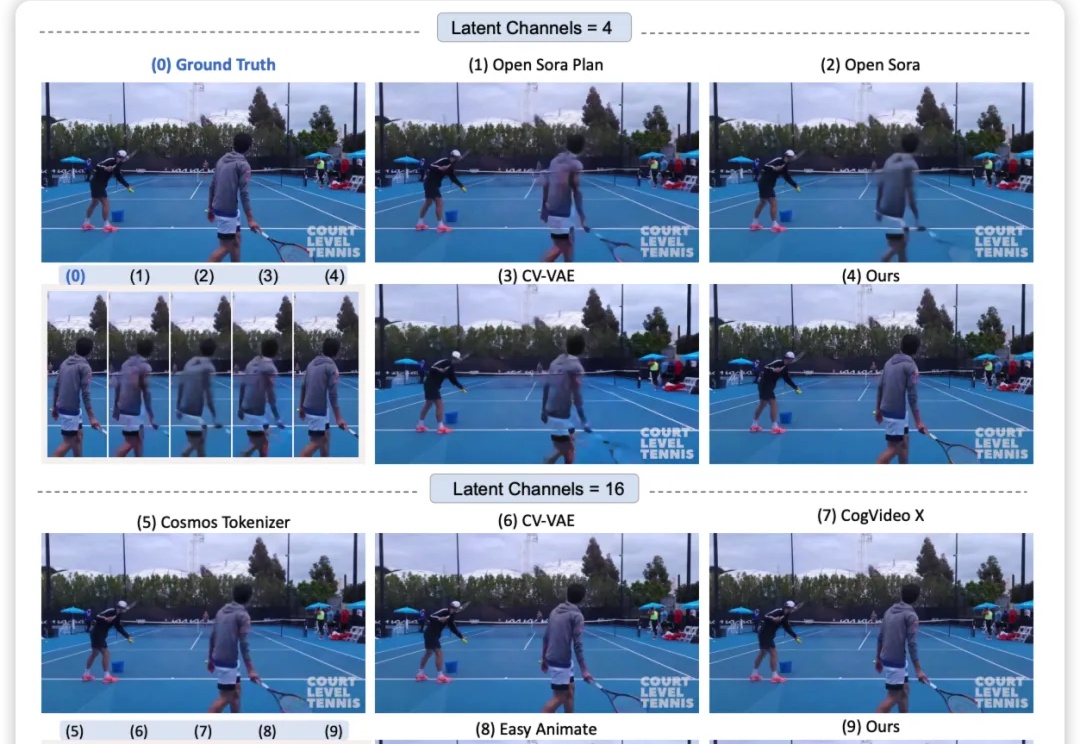

港科大团队重磅开源 VideoVAE+,提出了一种强大的跨模态的视频变分自编码器(Video VAE),通过提出新的时空分离的压缩机制和创新性引入文本指导,实现了对大幅运动视频的高效压缩与精准重建,同时保持很好的时间一致性和运动恢复。

Sora、Genie等模型会都用到的Tokenizer,微软下手了—— 开源了一套全能的Video Tokenizer,名为VidTok。

无需额外模型训练、即插即用,全新的视频生成增强算法——Enhance-A-Video来了!

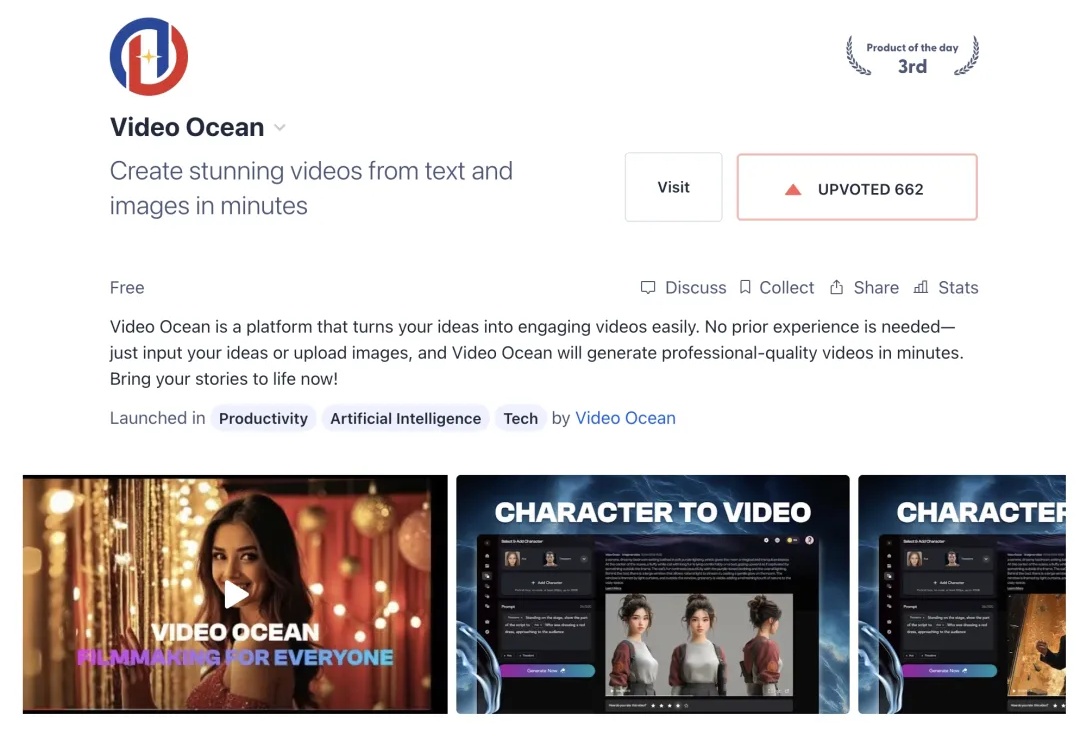

随着Sora震撼发布,视频生成技术成为了AI领域新风口。不过,高昂的开发成本是一大瓶颈。国产平台Video Ocean不仅成功登上全球热榜第三,还将视频生成模型开发成本降低50%。而且,模型构建和性能优化方案现已开源,还能免费获得500元GPU算力。

融合物理知识的大型视频语言模型PhysVLM,开源了! 它不仅在 PhysGame 基准上展现出最先进的性能,还在通用视频理解基准上(Video-MME, VCG)表现出领先的性能。

想要体验文生视频的小伙伴又多了一个选择!

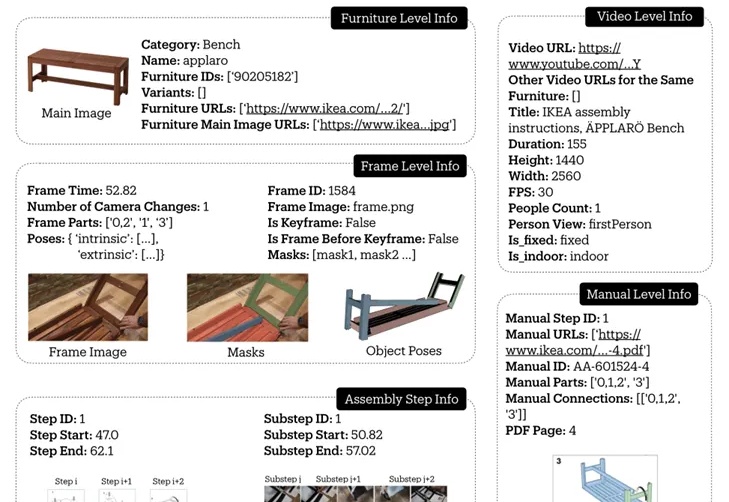

斯坦福大学推出的IKEA Video Manuals数据集,通过4D对齐组装视频和说明书,为AI理解和执行复杂空间任务提供了新的挑战和研究基准,让机器人或AR眼镜指导家具组装不再是梦。

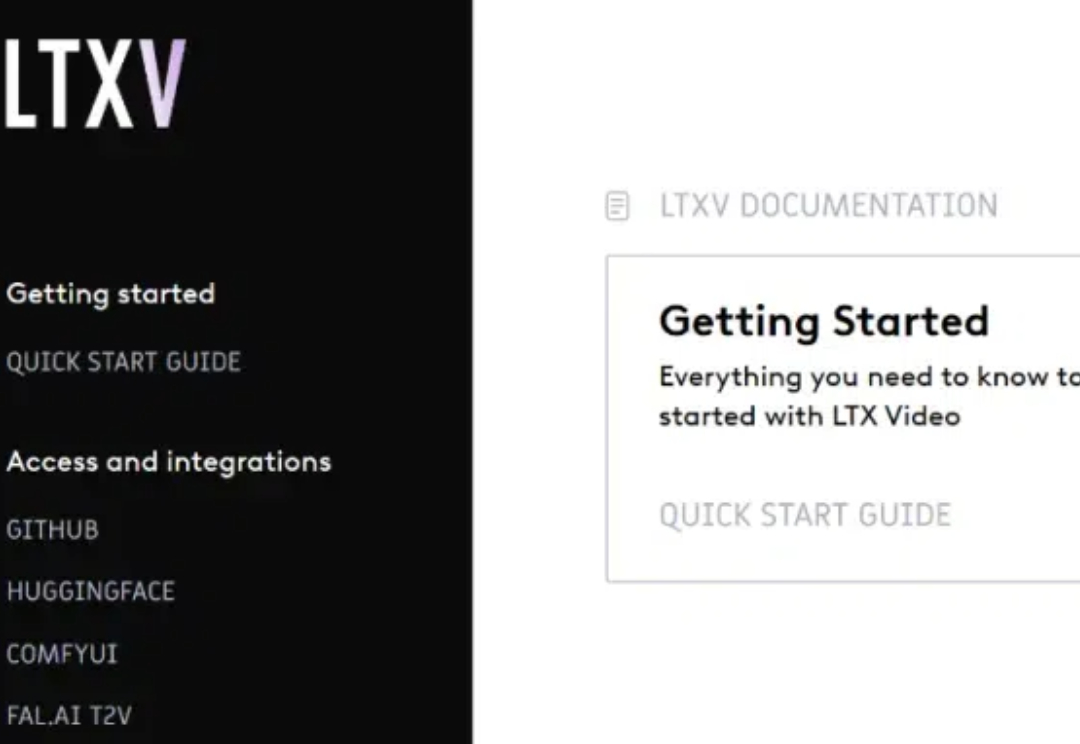

这个周末,押注开源人工智能视频的初创公司 Lightricks,有了重大动作。 该公司推出了最快的视频生成模型 LTX-Video,它是首个可以实时生成高质量视频的 DiT 视频生成模型。