自动驾驶中的AI大模型中有哪些研究方向,与Transformer何干?

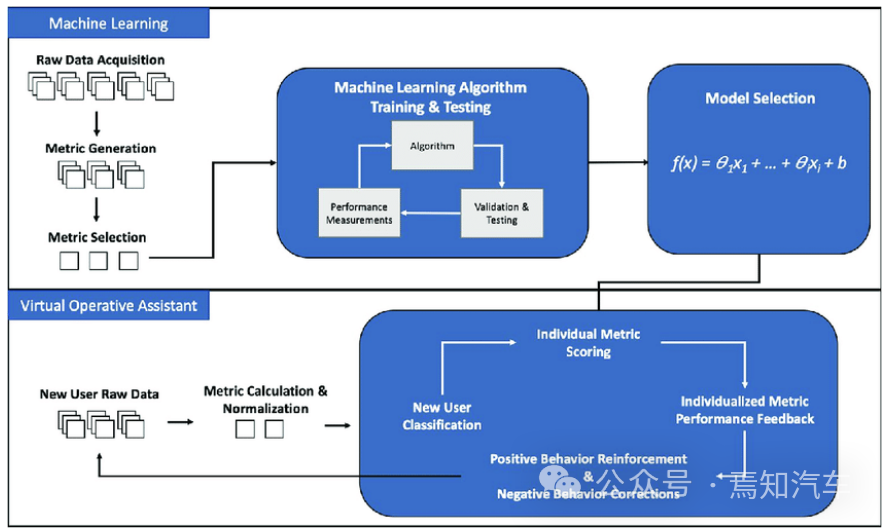

自动驾驶中的AI大模型中有哪些研究方向,与Transformer何干?自动驾驶中的大模型处理作为当前 AI 领域最为火热的前沿趋势之一,可赋能自动驾驶领域的感知、标注、仿真训练等多个核心环节。同时,也可以有效的提升感知精确度,有利于后续规划控制算法的实施,促进端到端自动驾驶框架的发展。

自动驾驶中的大模型处理作为当前 AI 领域最为火热的前沿趋势之一,可赋能自动驾驶领域的感知、标注、仿真训练等多个核心环节。同时,也可以有效的提升感知精确度,有利于后续规划控制算法的实施,促进端到端自动驾驶框架的发展。

近年来,随着Transformer模型的大规模发展和应用,模型大小每两年平均增长240倍,GPT-3等大模型的参数增长已经超过了GPU内存的增长。在大算力激增的需求下,越来越多行业人士认识到,新的计算架构或许才是算力破局的关键。

AI算命将可以预测人类的意外死亡?丹麦科学家用全国600万人的公开数据训练了一个基于Transformer的模型,成功预测了意外死亡和性格特点。

在 AI 领域,近年来各个子领域都逐渐向 transformer 架构靠拢,只有文生图和文生视频一直以 diffusion + u-net 结构作为主流方向。diffusion 有更公开可用的开源模型,消耗的计算资源也更少。

几乎是和斯坦福“炒虾洗碗”机器人同一时间,谷歌DeepMind也发布了最新具身智能成果。

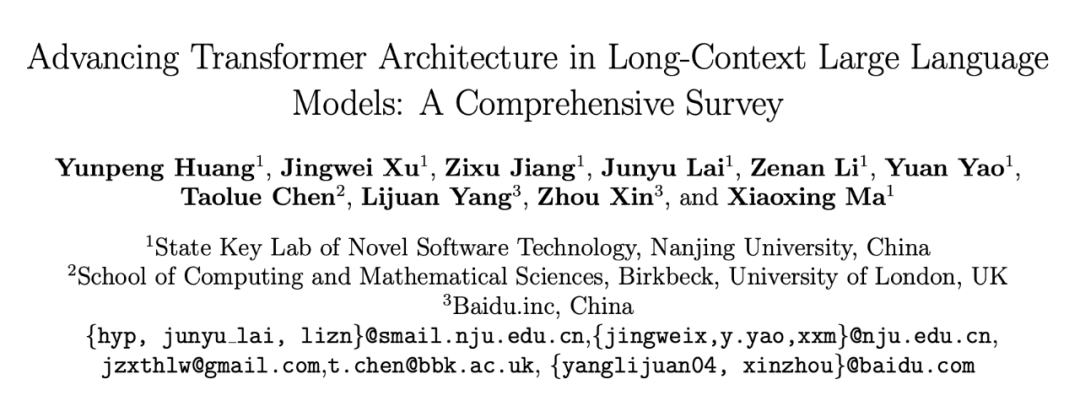

作者重点关注了基于 Transformer 的 LLM 模型体系结构在从预训练到推理的所有阶段中优化长上下文能力的进展。

Hyena处理长序列输入比FlashAttention速度高100倍!最新发布的StripedHyena模型可能成下一代AI架构的新标准?

华为盘古系列,带来架构层面上新!量子位获悉,华为诺亚方舟实验室等联合推出新型大语言模型架构:盘古-π。

一个来自MIT博士生的惊人发现:只需对Transformer的特定层进行一种非常简单的修剪,即可在缩小模型规模的同时显著提高模型性能。

近日,来自华为诺亚方舟实验室、北京大学等机构的研究者提出了盘古 π 的网络架构,尝试来构建更高效的大模型架构。