字节Seed发布扩散语言模型,推理速度达2146 tokens/s,比同规模自回归快5.4倍

字节Seed发布扩散语言模型,推理速度达2146 tokens/s,比同规模自回归快5.4倍用扩散模型写代码,不仅像开了倍速,改起来还特别灵活! 字节Seed最新发布扩散语言模型Seed Diffusion Preview,这款模型主要聚焦于代码生成领域,它的特别之处在于采用了离散状态扩散技术,在推理速度上表现出色。

用扩散模型写代码,不仅像开了倍速,改起来还特别灵活! 字节Seed最新发布扩散语言模型Seed Diffusion Preview,这款模型主要聚焦于代码生成领域,它的特别之处在于采用了离散状态扩散技术,在推理速度上表现出色。

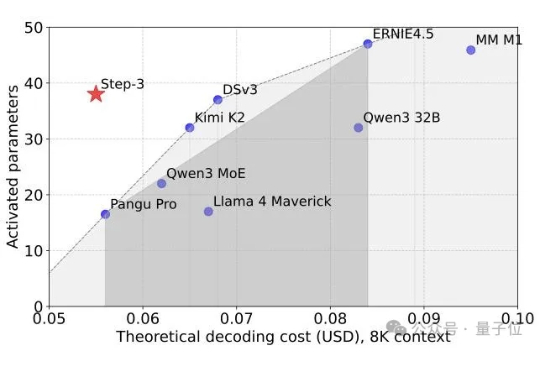

又一个SOTA基础模型开源,而且依然是国产。 刚刚,阶跃星辰兑现了WAIC上的承诺,将最新多模态推理模型Step-3正式开源! 在MMMU等多个多模态榜单上,它一现身就取得了开源多模态推理模型新SOTA的成绩。

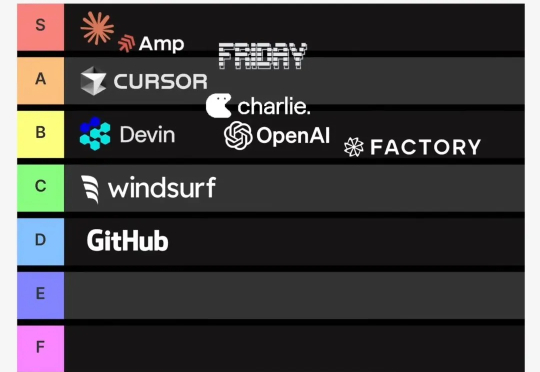

近期,AI 编程领域又一匹 AI Coding 黑马正在快速崛起。

放眼当下,到底哪个芯片跑满血DeepSeek是最快的? 答案很意外——不是你以为的英伟达,而是一家国产GPU。 因为现在它的速度,已经直接来到了100 tokens/s!

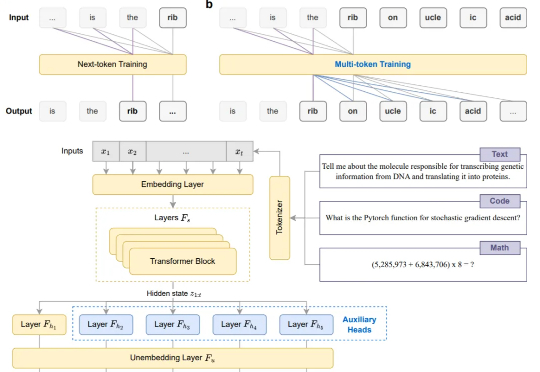

告别Next-token,现在模型微调阶段就能直接多token预测!

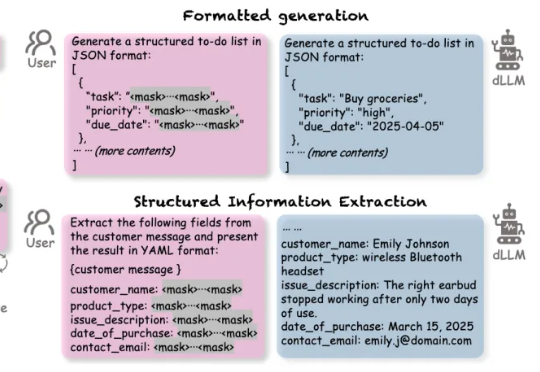

扩散语言模型(Diffusion-based LLMs,简称 dLLMs)以其并行解码、双向上下文建模、灵活插入masked token进行解码的特性,成为一个重要的发展方向。

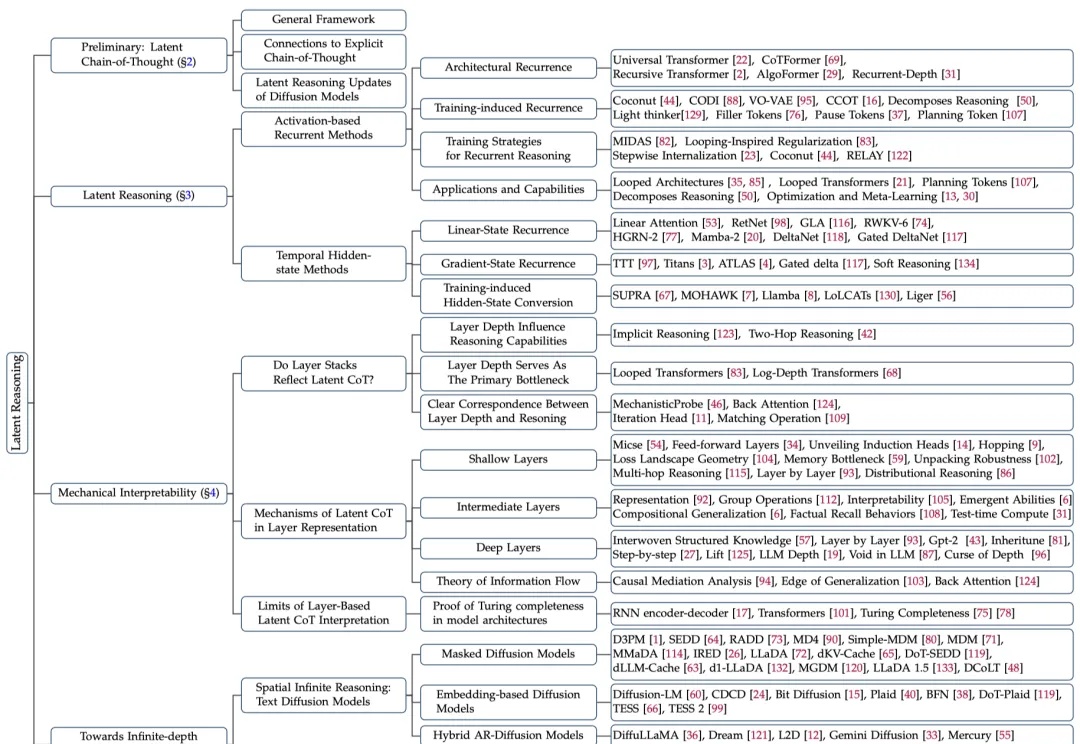

大模型在潜空间中推理,带宽能达到普通(显式)思维链(CoT)的2700多倍?

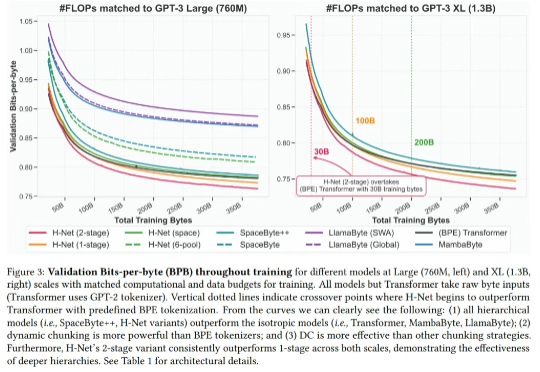

最近,Mamba 作者之一 Albert Gu 又发新研究,他参与的一篇论文《 Dynamic Chunking for End-to-End Hierarchical Sequence Modeling 》提出了一个分层网络 H-Net,其用模型内部的动态分块过程取代 tokenization,从而自动发现和操作有意义的数据单元。

「Tokenization(分词)是 Transformer 模型为弥补自身缺陷不得不戴上的枷锁。」

2025年6月,AI 代码编辑器 Cursor 因定价模式调整引发广泛争议。原先的“按次计费”(per-request billing)改为基于 token 的“按量计费”(usage-based pricing),导致部分用户面临意外扣费,社区反馈强烈Cursor 于7月5日发布致歉声明,承诺退款并澄清新计费模式。