英伟达又赚到了!FlashAttention3来了:H100利用率飙升至75%

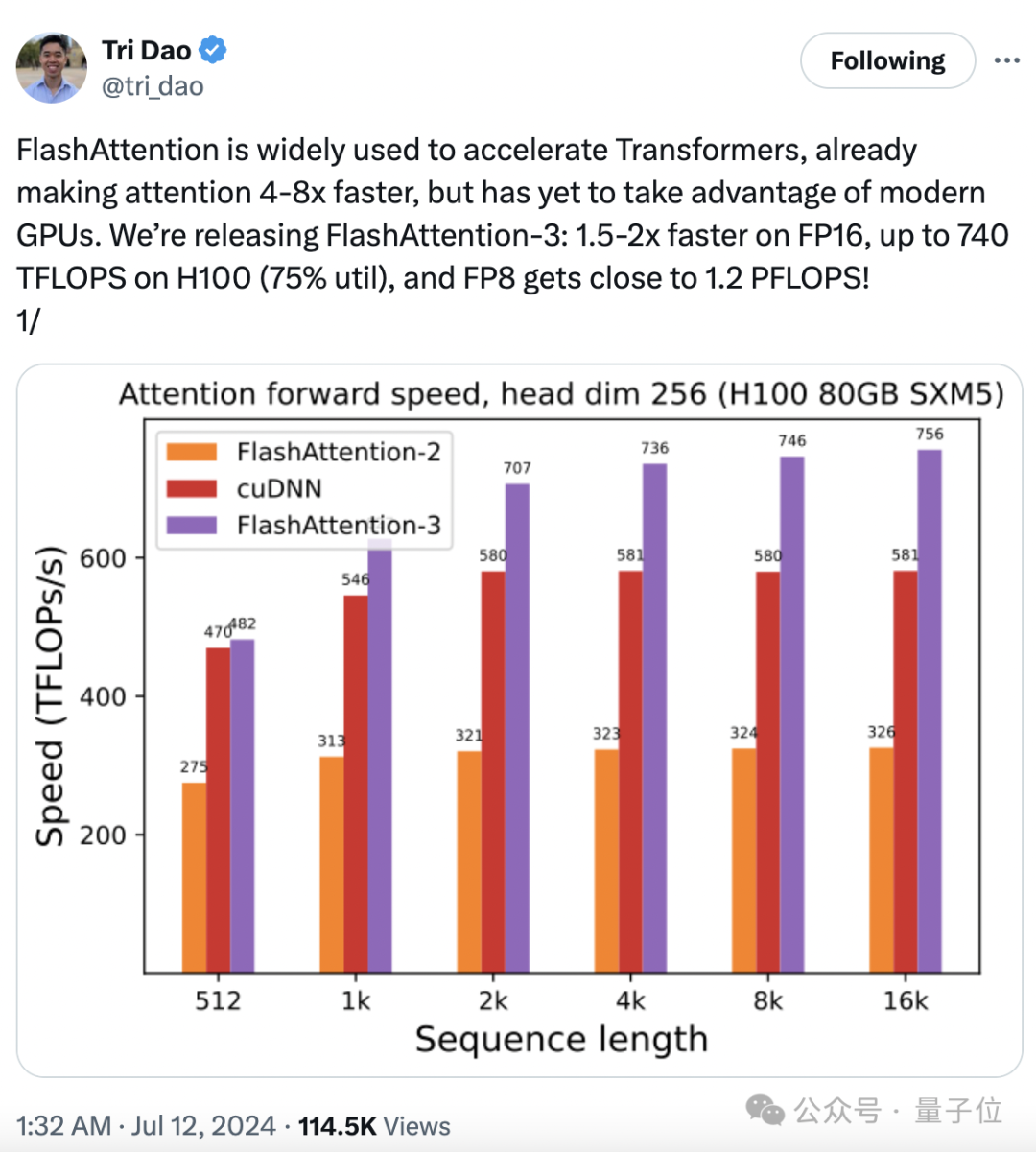

英伟达又赚到了!FlashAttention3来了:H100利用率飙升至75%740 TFLOPS!迄今最强 FlashAttention 来了。

740 TFLOPS!迄今最强 FlashAttention 来了。

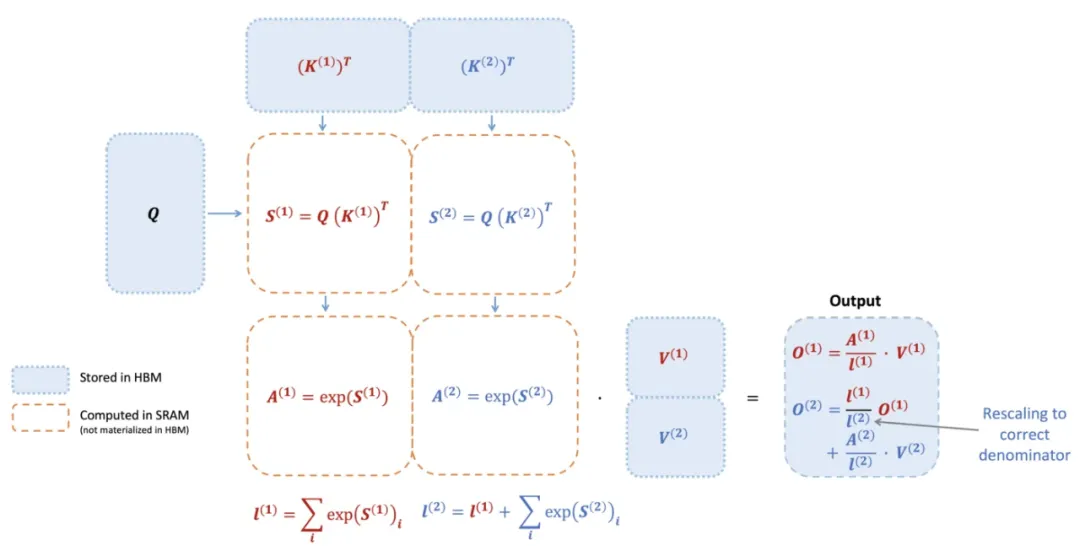

时隔一年,FlashAttention又推出了第三代更新,专门针对H100 GPU的新特性进行优化,在之前的基础上又实现了1.5~2倍的速度提升。

大模型训练推理神作,又更新了!

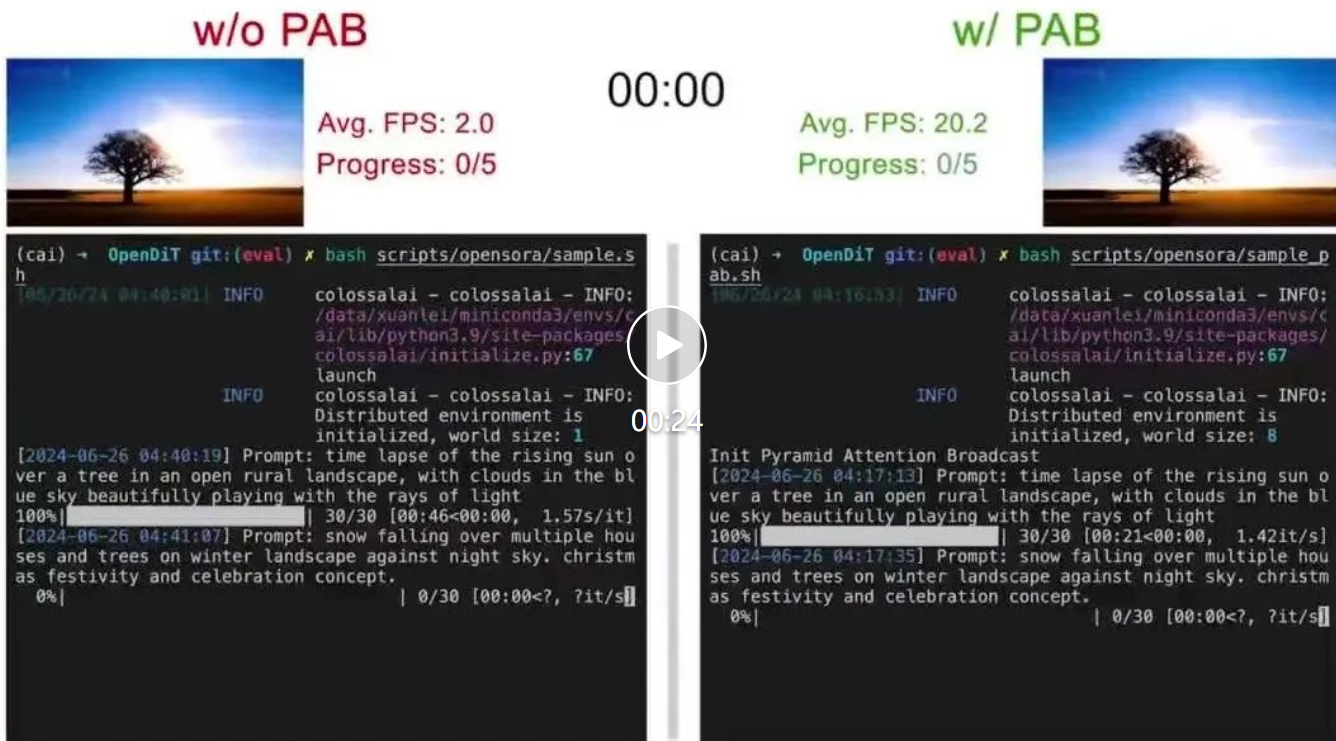

尤洋团队新作,首个基于DiT的实时视频生成方法来了!

在生成式模型的迅速发展中,Image Tokenization 扮演着一个很重要的角色,例如Diffusion依赖的VAE或者是Transformer依赖的VQGAN。这些Tokenizers会将图像编码至一个更为紧凑的隐空间(latent space),使得生成高分辨率图像更有效率。

2024 年 5 月,DreamTech 官宣了其高质量 3D 生成大模型 Direct3D,并公开了相关学术论文 Direct3D: Scalable Image-to-3D Generation via 3D Latent Diffusion Transformer。

AI算力资源越发紧张的当下,斯坦福新研究将GPU运行效率再提升一波——

如何突破 Transformer 的 Attention 机制?中国科学院大学与鹏城国家实验室提出基于热传导的视觉表征模型 vHeat。将图片特征块视为热源,并通过预测热传导率、以物理学热传导原理提取图像特征。相比于基于Attention机制的视觉模型, vHeat 同时兼顾了:计算复杂度(1.5次方)、全局感受野、物理可解释性。

只需上传一张照片,就能瞬间变换身份,获得高精度个人写真! 或是科幻电影中的超级英雄,或是穿越时空的复古角色…… 李飞飞在家做饭的样子有了,还有让斯嘉丽一键带圣诞帽。

众所周知,大语言模型的训练常常需要数月的时间,使用数百乃至上千个 GPU。以 LLaMA2 70B 模型为例,其训练总共需要 1,720,320 GPU hours。由于这些工作负载的规模和复杂性,导致训练大模型存在着独特的系统性挑战。