大模型量化训练极限在哪?腾讯混元提出低比特浮点数训练Scaling Laws

大模型量化训练极限在哪?腾讯混元提出低比特浮点数训练Scaling Laws大模型低精度训练和推理是大模型领域中的重要研究方向,旨在通过降低模型精度来减少计算和存储成本,同时保持模型的性能。因为在大模型研发成本降低上的巨大价值而受到行业广泛关注 。

大模型低精度训练和推理是大模型领域中的重要研究方向,旨在通过降低模型精度来减少计算和存储成本,同时保持模型的性能。因为在大模型研发成本降低上的巨大价值而受到行业广泛关注 。

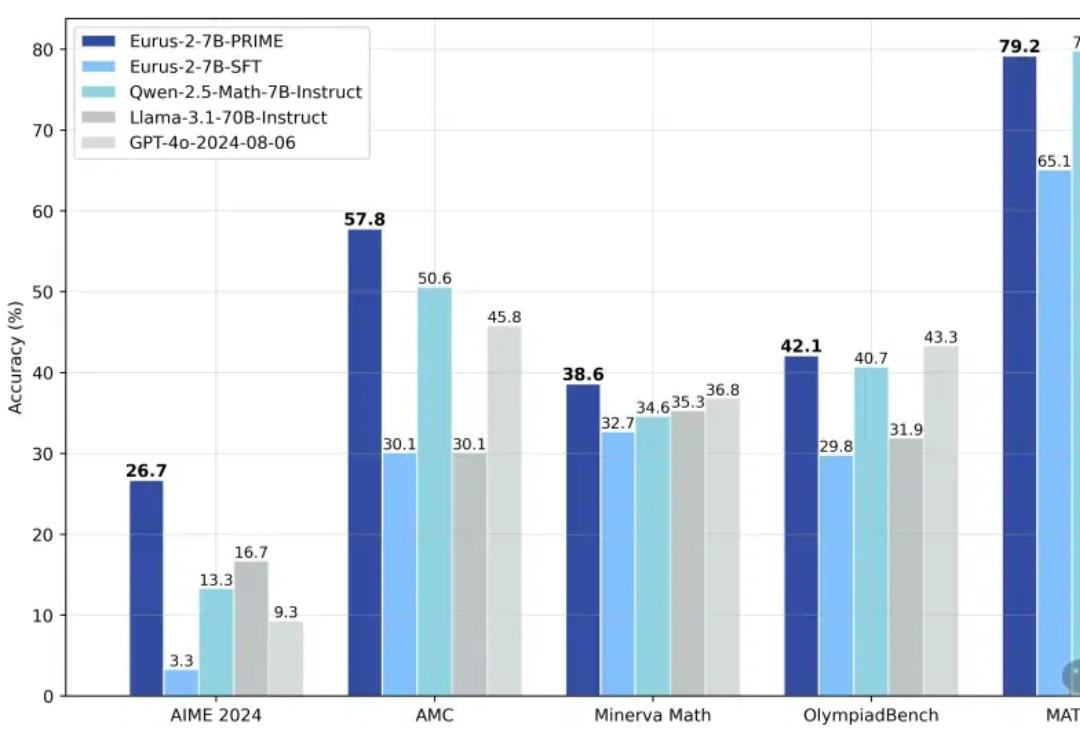

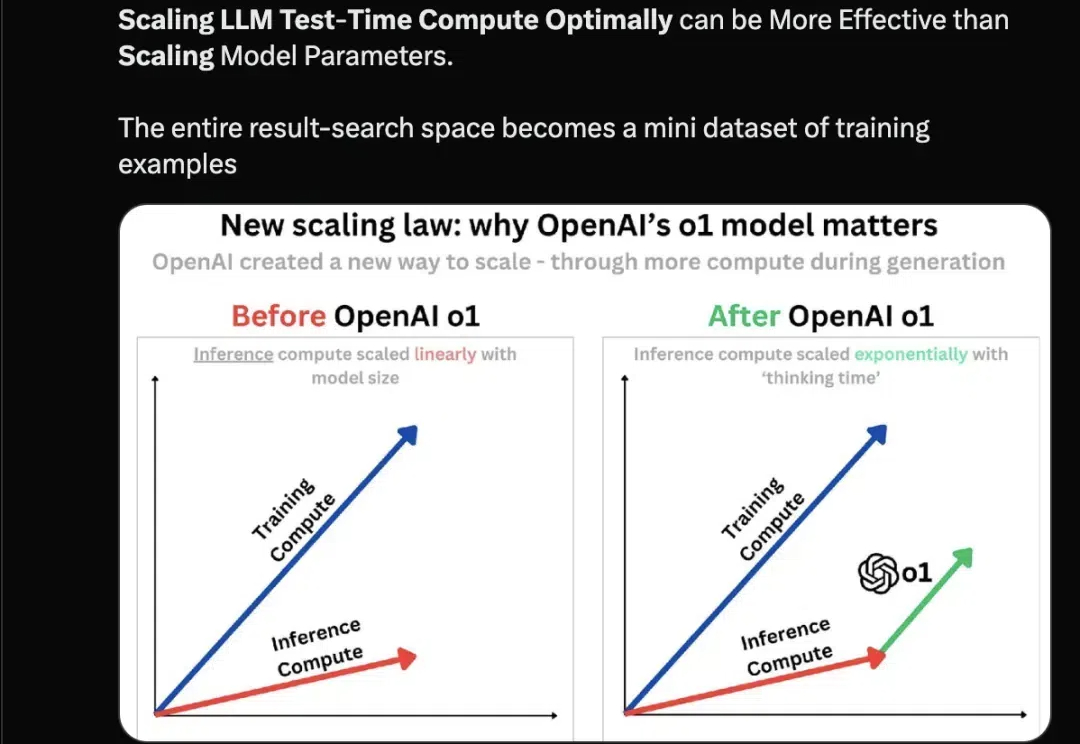

OpenAI 接连发布 o1 和 o3 模型,大模型的高阶推理能力正在迎来爆发式增强。在预训练 Scaling law “撞墙” 的背景下,探寻新的 Scaling law 成为业界关注的热点。高阶推理能力有望开启新的 Scaling law,为大模型的发展注入新的活力。

OpenAI o1和o3模型的发布证明了强化学习能够让大模型拥有像人一样的快速迭代试错、深度思考的高阶推理能力,在基于模仿学习的Scaling Law逐渐受到质疑的今天,基于探索的强化学习有望带来新的Scaling Law。

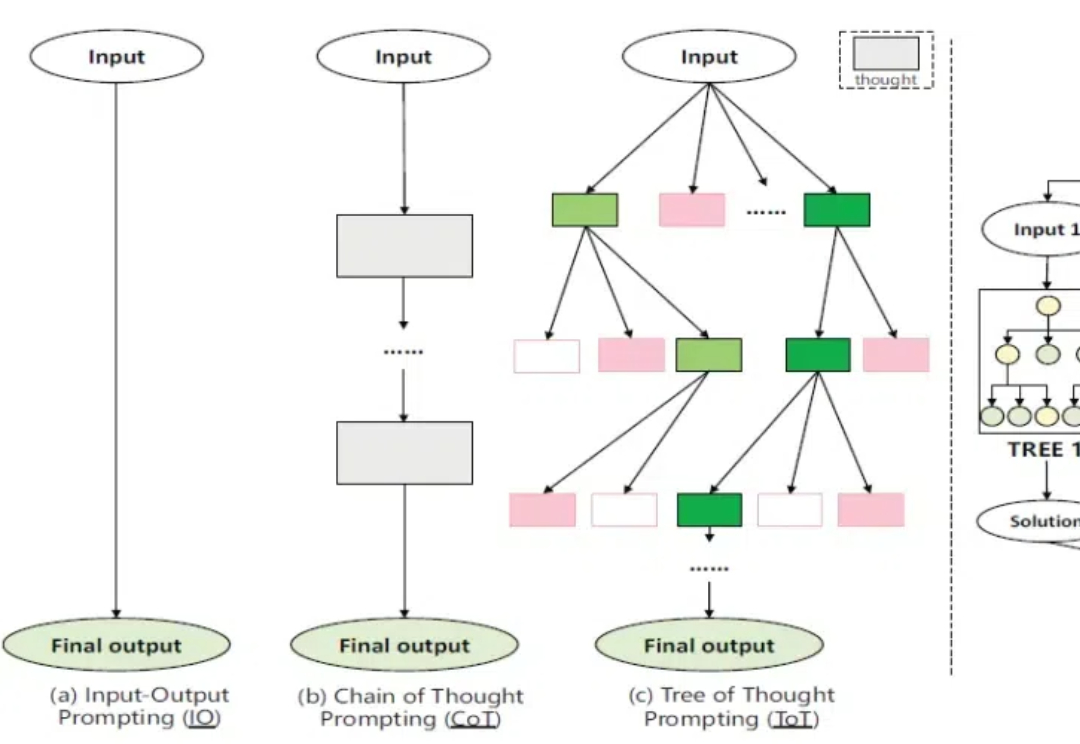

2023 年初,Jason Wei 加入了 OpenAI,参与了 ChatGPT 的构建以及 o1 等重大项目。他的工作使思维链提示、指令微调和涌现现象等技术和概念变得广为人知。

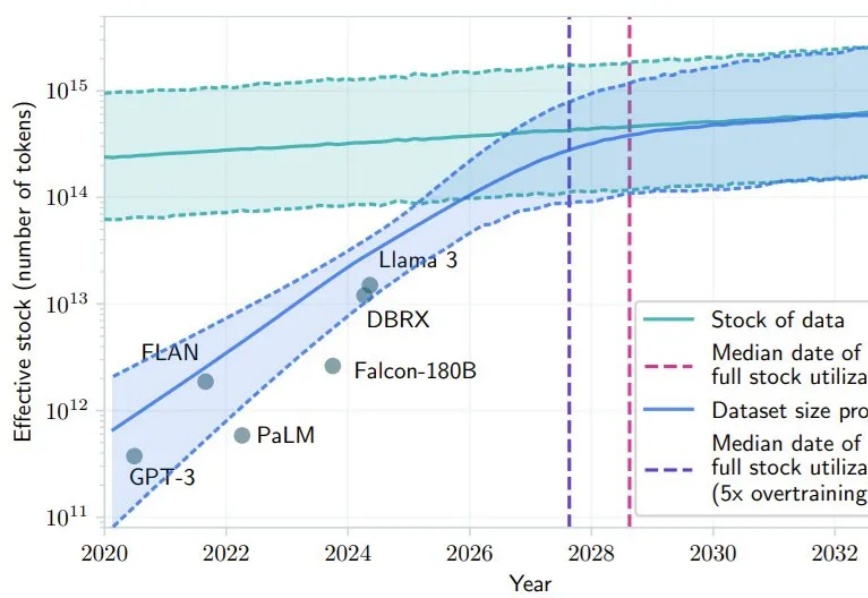

最近 AI 社区很多人都在讨论 Scaling Law 是否撞墙的问题。其中,一个支持 Scaling Law 撞墙论的理由是 AI 几乎已经快要耗尽已有的高质量数据,比如有一项研究就预计,如果 LLM 保持现在的发展势头,到 2028 年左右,已有的数据储量将被全部利用完。

过去一段时间,“预训练终结”成为了 AI 领域最热烈的讨论之一。OpenAI的GPT系列模型此前大踏步的前进,预训练是核心推动力。而前 OpenAI 首席科学家 Ilya Sutskever、预训练和scaling law(规模定律)最忠实的倡导者,却宣称预训练要终结了、scaling law要失效。由此,引发了大量争议。

在 2024 年的 NeurIPS 会议上,Ilya Sutskever 提出了一系列关于人工智能发展的挑战性观点,尤其集中于 Scaling Law 的观点:「现有的预训练方法将会结束」,这不仅是一次技术的自然演进,也可能标志着对当前「大力出奇迹」方法的根本性质疑。

随着 o1、o1 Pro 和 o3 的成功发布,我们明显看到,推理所需的时间和计算资源逐步上升。可以说,o1 的最大贡献在于它揭示了提升模型效果的另一种途径:在推理过程中,通过优化计算资源的配置,可能比单纯扩展模型参数更为高效。

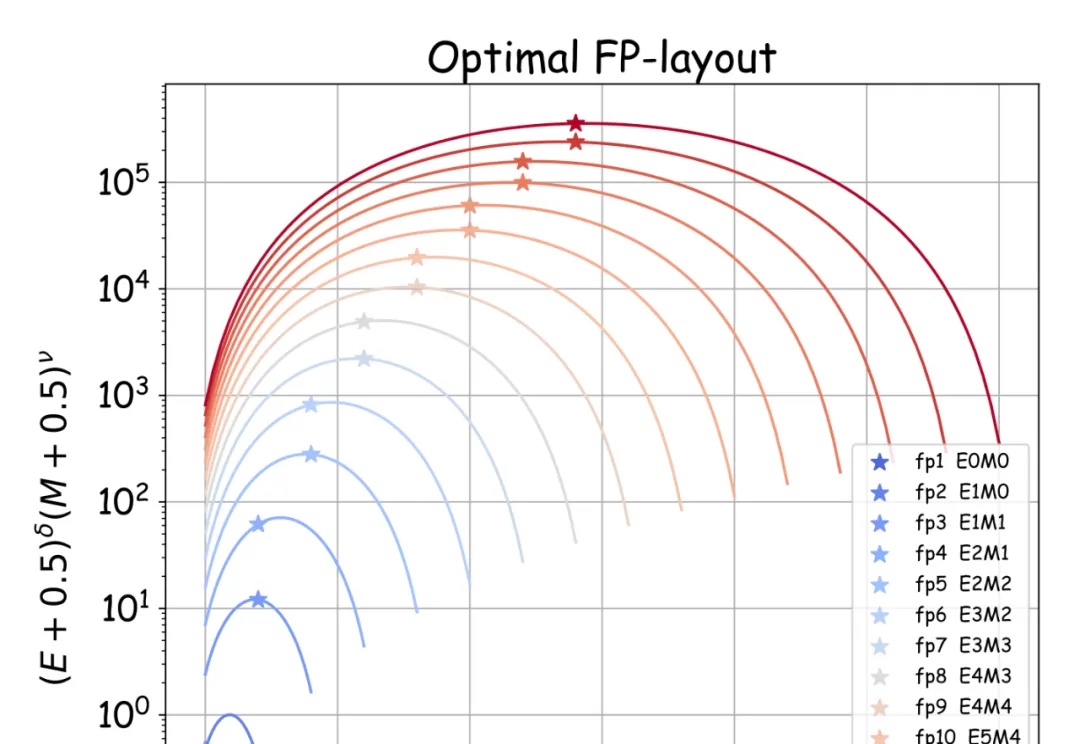

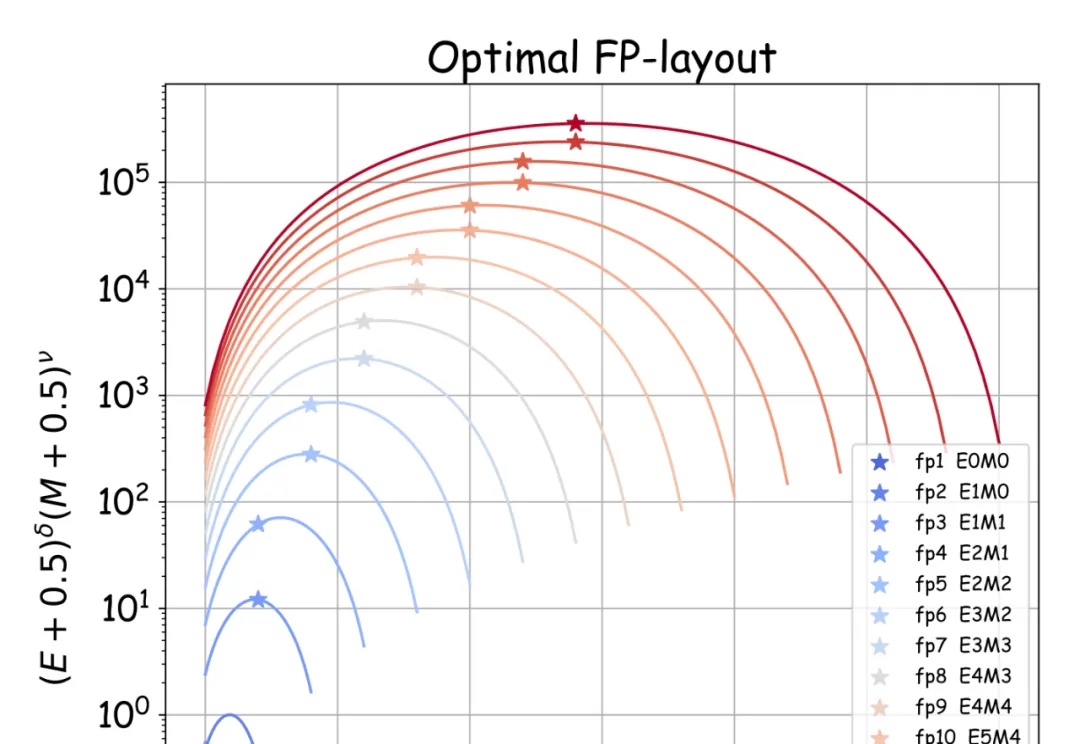

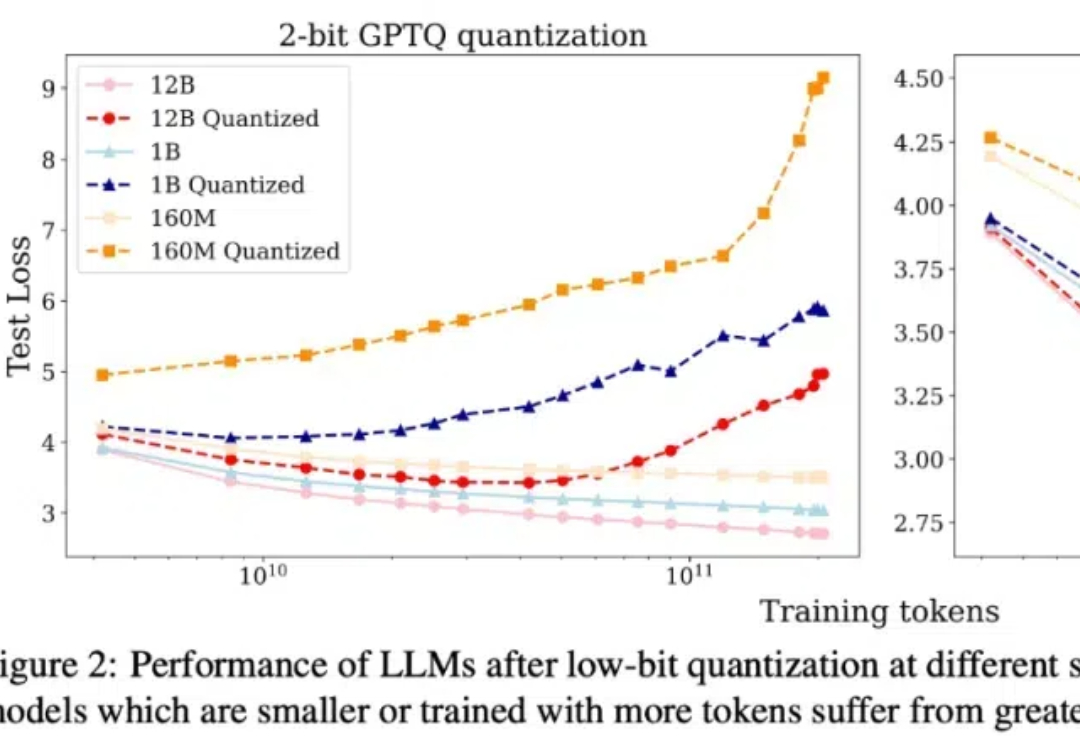

本文介绍了一套针对于低比特量化的 scaling laws。

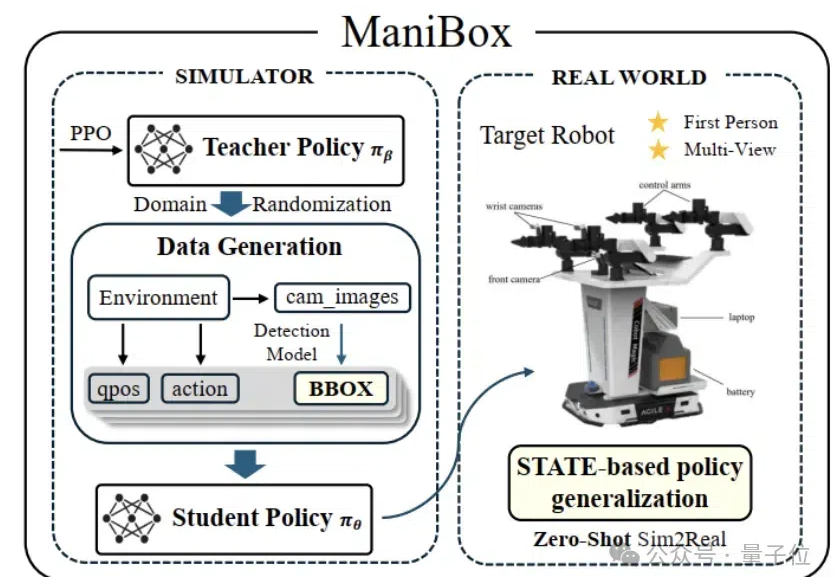

在机器人空间泛化领域,原来也有一套Scaling Law! 来自清华和新加坡国立大学的团队,发现了空间智能的泛化性规律。 在此基础上,他们提出了一套新颖的算法框架——ManiBox,让机器人能够在真实世界中应对多样化的物体位置和复杂的场景布置。