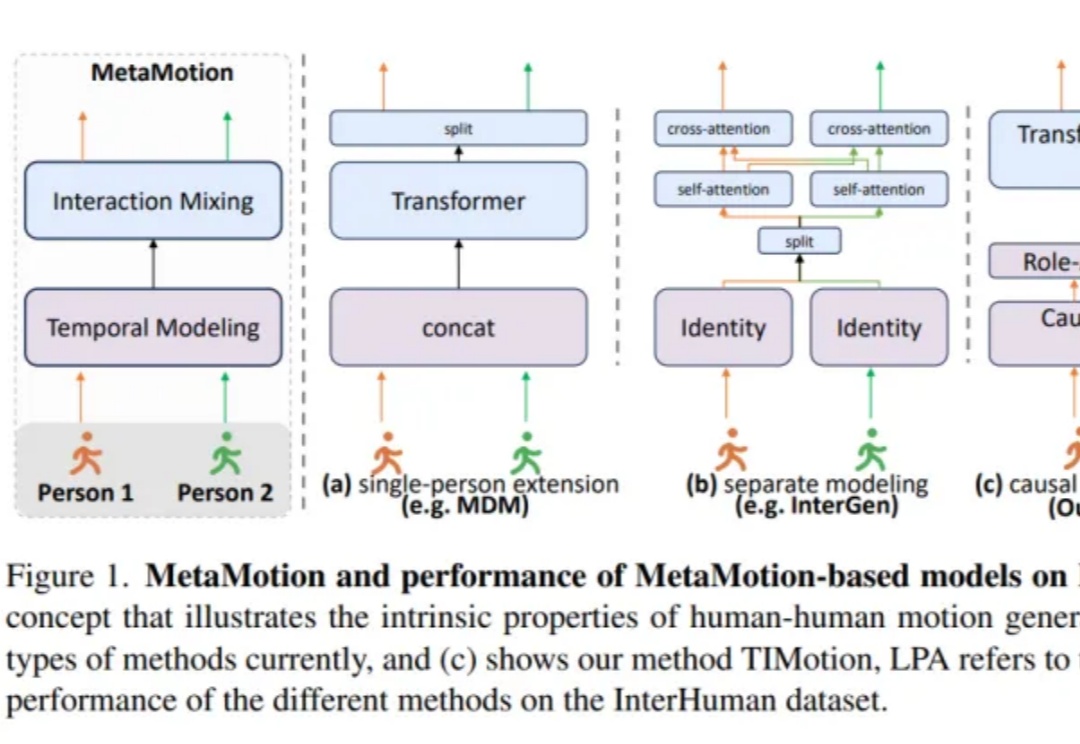

双人动作生成新SOTA!浙大提出TIMotion框架 | CVPR 2025

双人动作生成新SOTA!浙大提出TIMotion框架 | CVPR 2025双人动作生成新SOTA!

双人动作生成新SOTA!

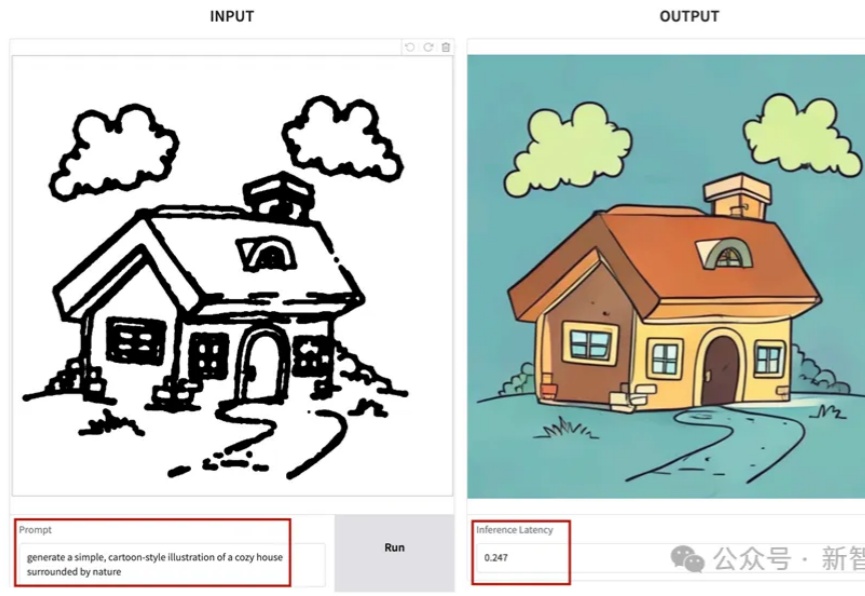

SANA-Sprint是一个高效的蒸馏扩散模型,专为超快速文本到图像生成而设计。通过结合连续时间一致性蒸馏(sCM)和潜空间对抗蒸馏(LADD)的混合蒸馏策略,SANA-Sprint在一步内实现了7.59 FID和0.74 GenEval的最先进性能。SANA-Sprint仅需0.1秒即可在H100上生成高质量的1024x1024图像,在速度和质量的权衡方面树立了新的标杆。

3D生成版DeepSeek再上新高度!

3 月 28 日,专注于构建通用 3D 大模型的 VAST 一口气开源了两个 3D 生成项目 ——TripoSG 和 TripoSF。前者是一款基础 3D 生成模型,在图像到 3D 生成任务上远超所有闭源模型;后者则是 VAST 新一代三维基础模型 TripoSF 能在所有闭源模型中同样取得 SOTA 的基础组件,用于高分辨率的三维重建和生成任务。

任意一张立绘,就可以生成可拆分3D角色!

文本到图像(Text-to-Image, T2I)生成任务近年来取得了飞速进展,其中以扩散模型(如 Stable Diffusion、DiT 等)和自回归(AR)模型为代表的方法取得了显著成果。然而,这些主流的生成模型通常依赖于超大规模的数据集和巨大的参数量,导致计算成本高昂、落地困难,难以高效地应用于实际生产环境。

全球首个开源多模态推理大模型来了!38B参数模型性能直逼DeepSeek-R1,同尺寸上横扫多项SOTA。而这家中国公司之所以选择无偿将技术思路开源,正是希望同DeepSeek一样,打造开源界的技术影响力。

超低成本图像生成预训练方案来了——仅需8张GPU训练,就能实现近SOTA的高质量图像生成效果。

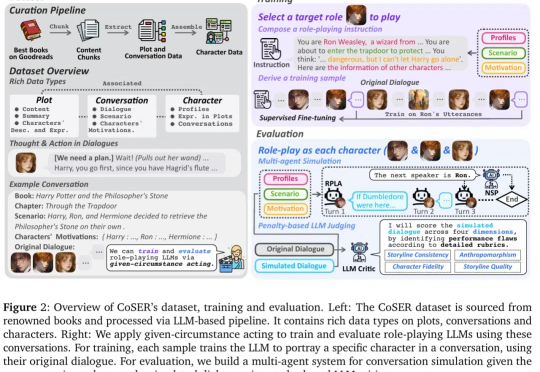

角色扮演 AI(Role-Playing Language Agents,RPLAs)作为大语言模型(LLM)的重要应用,近年来获得了广泛关注。

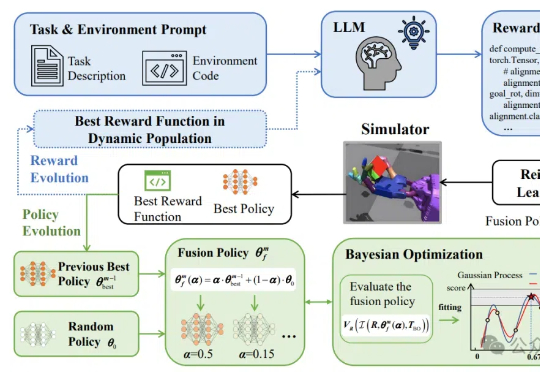

让机器人轻松学习复杂技能有新框架了!