2.5%KV缓存保持大模型90%性能,大模型金字塔式信息汇聚模式探秘|开源

2.5%KV缓存保持大模型90%性能,大模型金字塔式信息汇聚模式探秘|开源用KV缓存加速大模型的显存瓶颈,终于迎来突破。 北大、威斯康辛-麦迪逊、微软等联合团队提出了全新的缓存分配方案,只用2.5%的KV cache,就能保持大模型90%的性能。 这下再也不用担心KV占用的显存容量过高,导致显卡不够用了。

用KV缓存加速大模型的显存瓶颈,终于迎来突破。 北大、威斯康辛-麦迪逊、微软等联合团队提出了全新的缓存分配方案,只用2.5%的KV cache,就能保持大模型90%的性能。 这下再也不用担心KV占用的显存容量过高,导致显卡不够用了。

英特尔为了AI,再次做出重大架构变革: 像手机一样搞起SoC(系统级芯片),你的下一台笔记本不会再有独立内存条。 刚刚推出的新一代AI PC低功耗移动平台架构Lunar Lake,采用全新MoP(Memory on Package)封装,片上集成16或32GB的LPDDR5X内存,无法再额外连接更多RAM。

本文介绍了香港科技大学(广州)的一篇关于大模型高效微调(LLM PEFT Fine-tuning)的文章「Parameter-Efficient Fine-Tuning with Discrete Fourier Transform」

当地时间2024年5月22日,美国众议院外交事务委员会以压倒性多数,通过了一项限制AI模型出口的法案——《加强海外关键出口限制国家框架法案》(Enhancing National Frameworks for Overseas Critical Exports Act / HR 8315,以下简称ENFORCE法案),旨在扩大美国政府监管人工智能系统出口的权力。

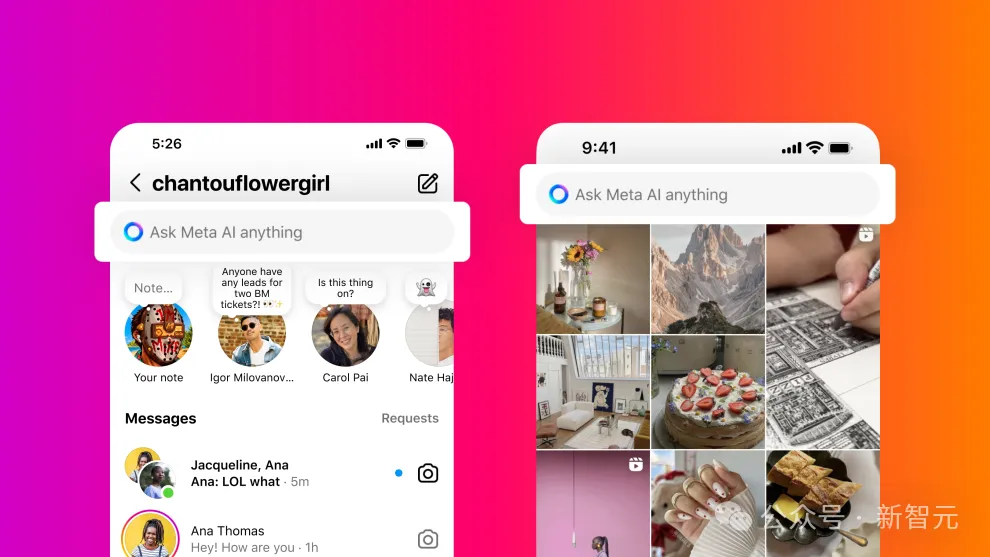

Llama 3开源后,聊天机器人Meta AI也宣布使用新模型作为基座,在Meta旗下的各种软件(Meta.ai、Instagram、Facebook、WhatsApp)中都可以进行免费体验。

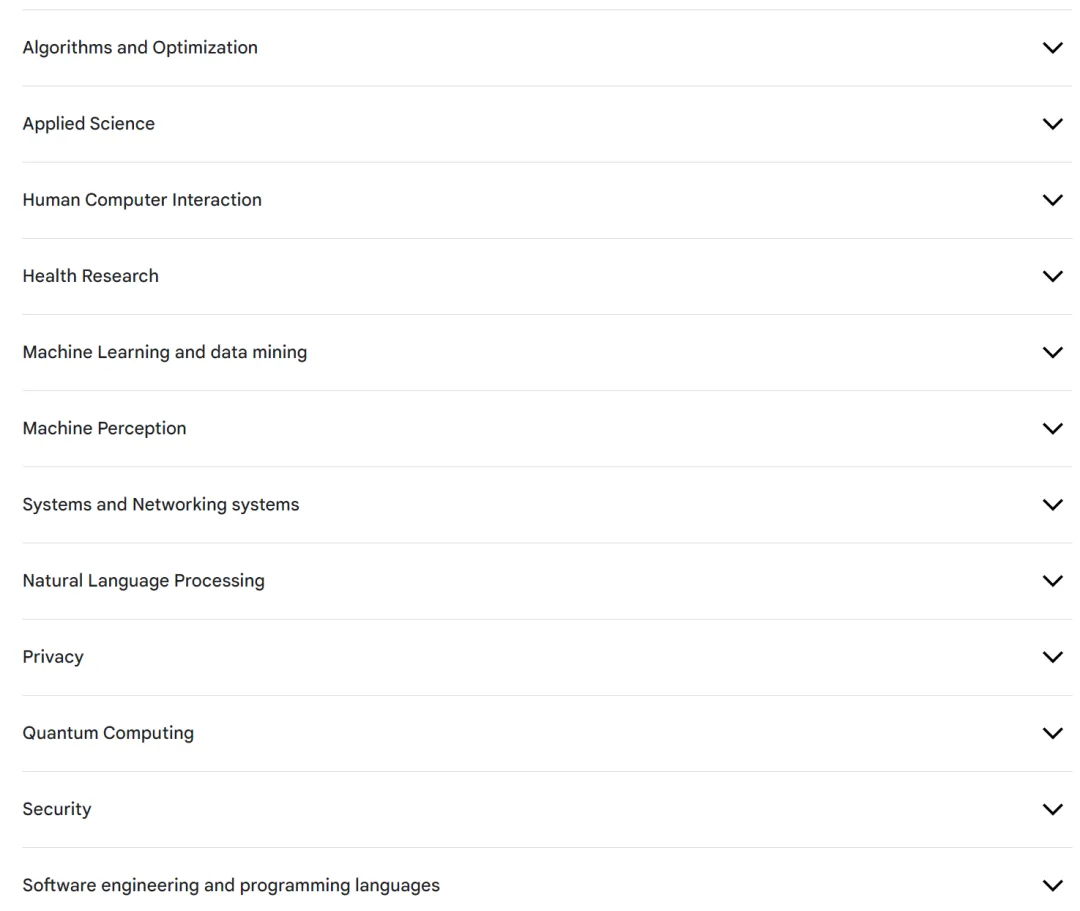

2024 年谷歌研究学者计划(Research Scholar Program)获奖名单公布了。获奖者最高将获得 6 万美元奖金,用于支持研究工作。

近,来自澳大利亚蒙纳士大学、蚂蚁集团、IBM 研究院等机构的研究人员探索了模型重编程 (model reprogramming) 在大语言模型 (LLMs) 上应用,并提出了一个全新的视角

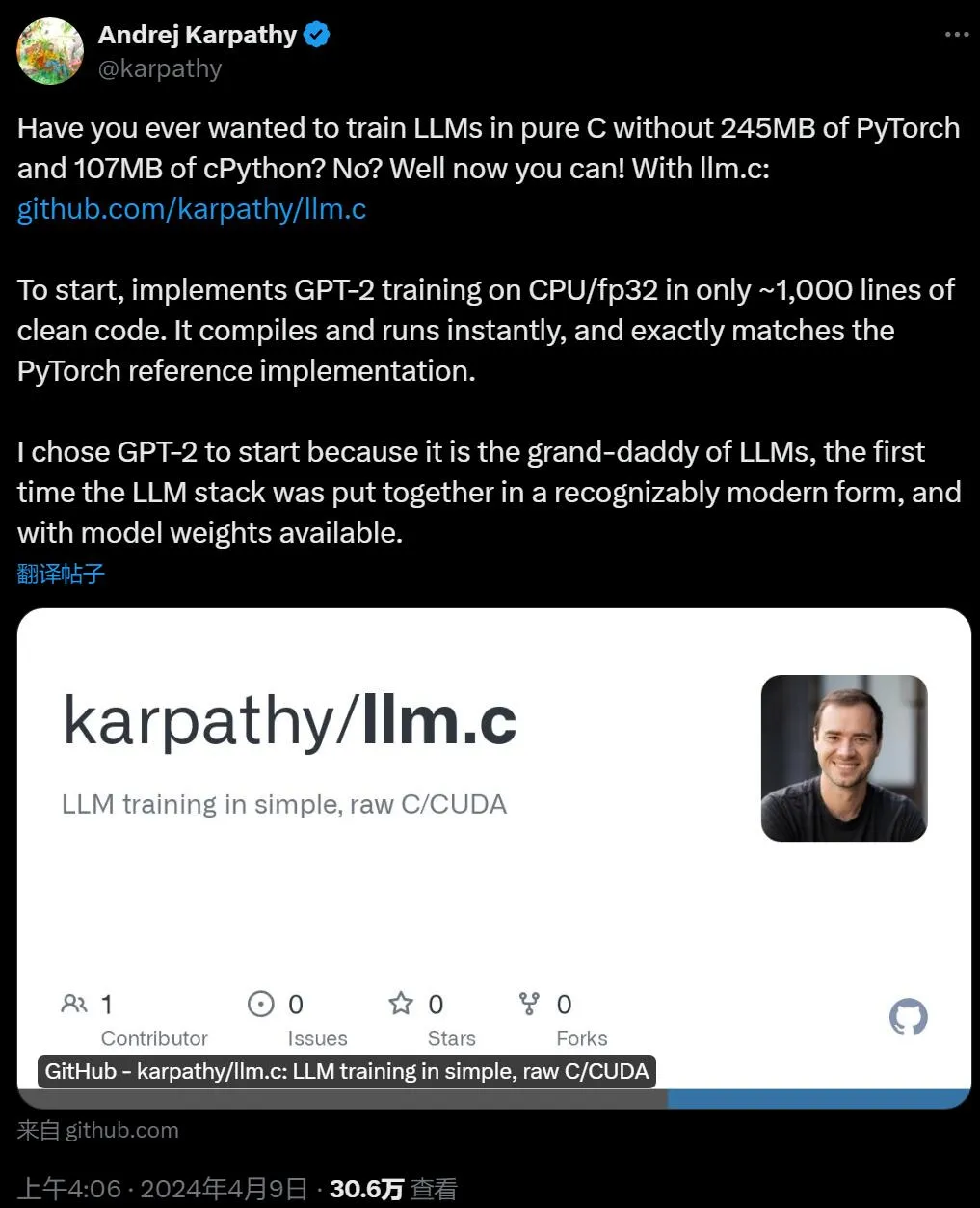

「Real men program in C.」 众所周知,大语言模型还在快速发展,应该有很多可以优化的地方。我用纯 C 语言来写,是不是能优化一大截? 也许很多人开过这样的脑洞,现在有大佬实现了。

“今年夏天,我会和我的AI男友结婚。”

没有谁能一直称王,但加上前缀谁都有称王的机会。AI 文生图,还能玩出什么新花样?在这片群雄割据的红海,头部被 Midjourney、DALL·E、Stable Diffusion 等占据,其余还能让人眼前一亮的产品并不多。然而,仍有黑马杀出:Ideogram,前 Google 工程师创立,硅谷 AI 大神投资,去年 8 月面世,2 月底发布了最新的模型。