人类打辩论不如GPT-4?!Nature子刊:900人实战演练,AI胜率64.4%,还更会说服人

人类打辩论不如GPT-4?!Nature子刊:900人实战演练,AI胜率64.4%,还更会说服人只需知道6项个人信息,GPT-4就有可能在辩论中打败你?!

只需知道6项个人信息,GPT-4就有可能在辩论中打败你?!

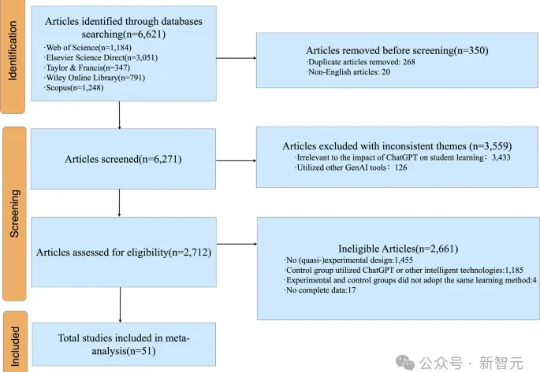

担心AI让学生懒?一篇Nature子刊的元分析汇总了51项研究,揭示ChatGPT显著提升中小学生学业表现和高阶思维能力。从语言到STEM,从短期突破到长期成长,AI正以科学的方式走向教育未来!

刚刚,全球规模最大的单细胞基础大模型来了,而且是纯国产!近日,中山大学杨跃东教授团队联合重庆大学、华为、新格元生物科技,研发单细胞基础大模型CellFM,成果发表在Nature Communications上。

可靠的地球系统预测对于推动人类进步和预防自然灾害至关重要。人工智能(AI)为提高该领域的预测精度和计算效率提供了巨大潜力,但在许多领域仍未得到充分开发。

京东探索研究院关于大模型的最新研究,登上了Nature旗下期刊!

洛桑联邦理工学院研究团队发现,当GPT-4基于对手个性化信息调整论点时,64%的情况下说服力超过人类。实验通过900人参与辩论对比人机表现,结果显示个性化AI达成一致概率提升81.2%。研究警示LLM可能被用于传播虚假信息,建议利用AI生成反叙事内容应对威胁,但实验环境与真实场景存在差异。

在麻省理工学院工作的好处之一,是能够窥见未来科技的轮廓——从量子计算的突破、可持续性能源的生产,到新型抗生素设计。若问我是否对这些领域都有深刻理解?答案是否定的。但当研究者邀请我为他们的工作拍摄纪实图像时,我能够理解其中的大部分内容。

近日,《自然》杂志独家专访了OpenAI首席科学家Jakub Pachocki,他揭示了推理模型、强化学习如何赋予AI自主发现科学的能力,并分享了AI如何在五年内重塑科学研究与经济格局的雄心。

近日,GPT-4.5核心开发者之一的Kai Chen因绿卡申请被拒,面临被迫离开美国的困境。与此同时,1700多名国际学生和研究人员因签证审查受阻,Nature调查显示75%的美国科学家正考虑逃离。这种人才流失或将影响美国在全球AI领域的领先地位。

ChatGPT潜入学术圈,已有超700篇论文偷用AI不报备。甚至,一些顶刊主动删除了100多篇论中的AI语。今天,最新Nature文章揭秘了学术论文背后的乱象。