Nature:科研人员最爱AI工具大盘点!从推理到编程,哪款才是最佳助手?

Nature:科研人员最爱AI工具大盘点!从推理到编程,哪款才是最佳助手?本文介绍了当前最受科研人员青睐的AI模型,推理出色的o3-mini、全能型DeepSeek-R1、科研常用的Llama、编程利器Claude 3.5 Sonnet和开源明星Olmo 2,它们各有优劣,为科研人员提供了多样选择。

本文介绍了当前最受科研人员青睐的AI模型,推理出色的o3-mini、全能型DeepSeek-R1、科研常用的Llama、编程利器Claude 3.5 Sonnet和开源明星Olmo 2,它们各有优劣,为科研人员提供了多样选择。

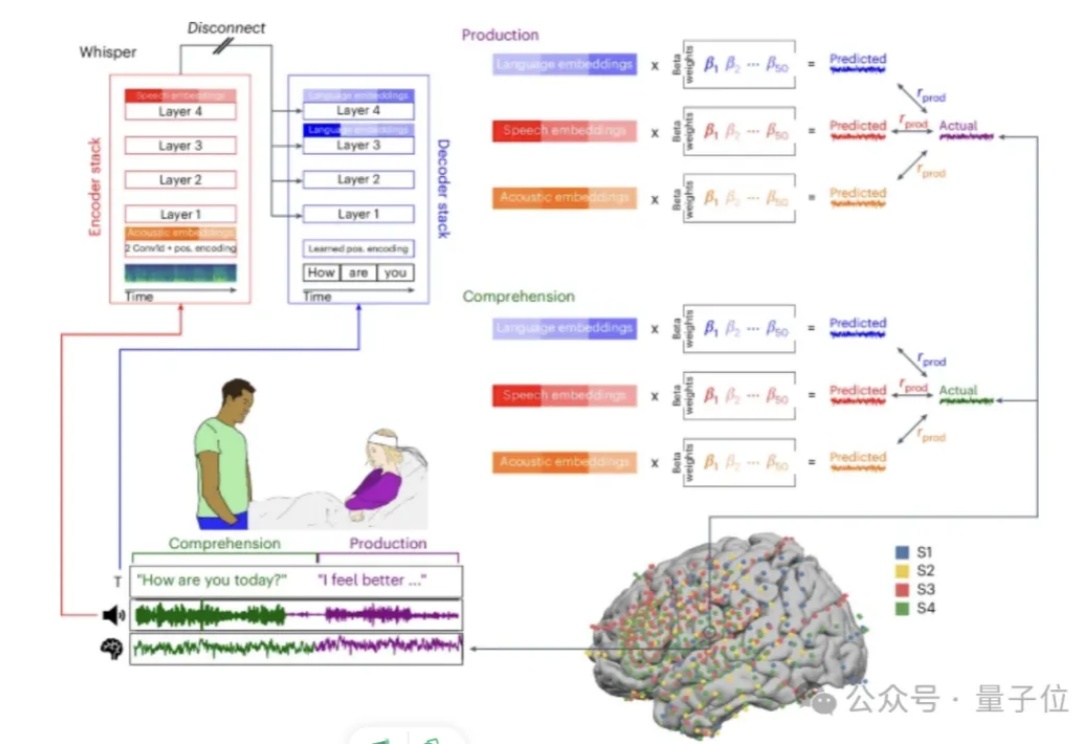

谷歌最新发现,大模型竟意外对应人脑语言处理机制?!

华人学者、斯坦福大学副教授 James Zou 领导的团队提出了 TextGrad ,通过文本自动化“微分”反向传播大语言模型(LLM)文本反馈来优化 AI 系统。只需几行代码,你就可以自动将用于分类数据的“逐步推理”提示转换为一个更复杂的、针对特定应用的提示。

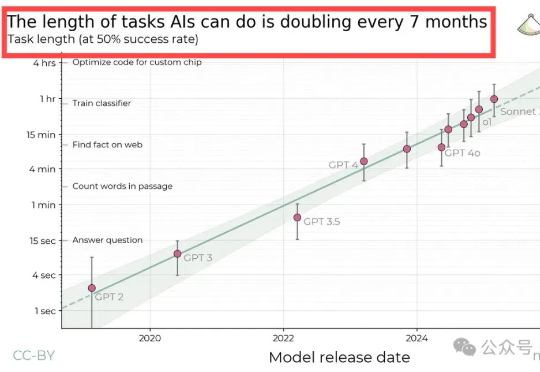

AI Agents(智能体)也有自己的“摩尔定律”了?!就在最近,Nature报道了一项来自非营利研究机构METR的最新发现:AI在完成长期任务方面的进步速度惊人,其时间跨度大约每七个月翻一番。

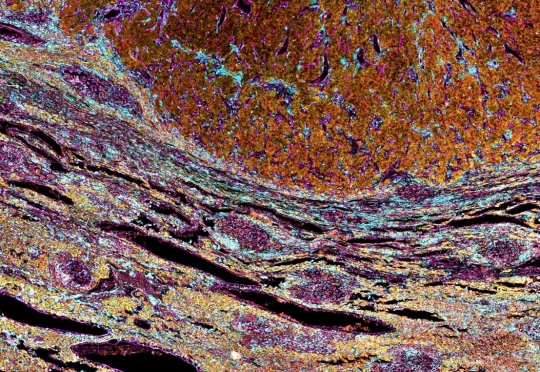

肝癌是全球癌症相关死亡的第三大原因,手术切除后的复发率高达70%,如何准确预测肿瘤手术切除后复发风险是一个难题。

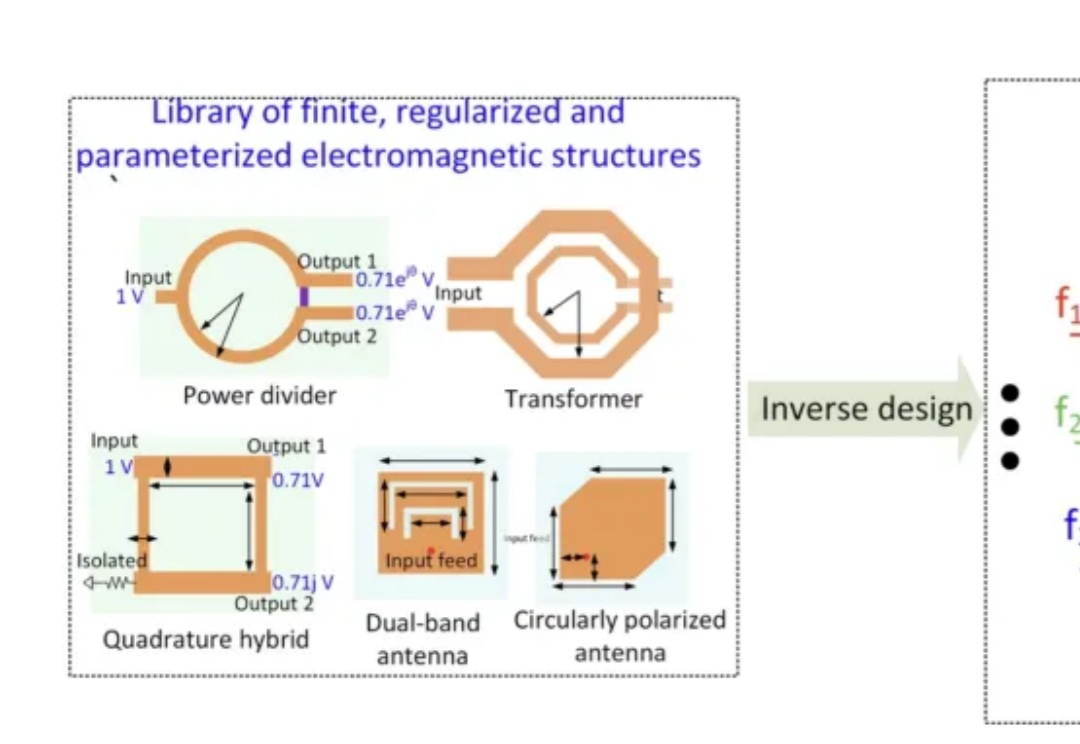

来自普林斯顿和印度技术学院的学者在《自然通讯》发表论文,他们发现,如果给定设计参数,AI可以在90nm的芯片上设计高性能集成电路。过去这是需要花费数周时间的高技能工作,但如今的AI可以在数小时内完成。

ChatGPT等AI模型爆发式增长引发关键问题:这场AI革命需要消耗多少能源?本文探究数据中心在乡村地区的快速扩张,以弗吉尼亚州为例,揭示研究者如何通过供应链分析和直接测量两种方法估算AI能耗。

近日,来自哥大的研究人员开发出了一种新AI系统,让机器人通过普通摄像头和深度神经网络实现自我建模、运动规划和自我修复,突破了传统机器人依赖工程师调整的局限,使机器人能像人类一样自主学习和适应环境变化,为具身智能发展带来新范式。

DeepSeek的风,也是飘到了科研领域——

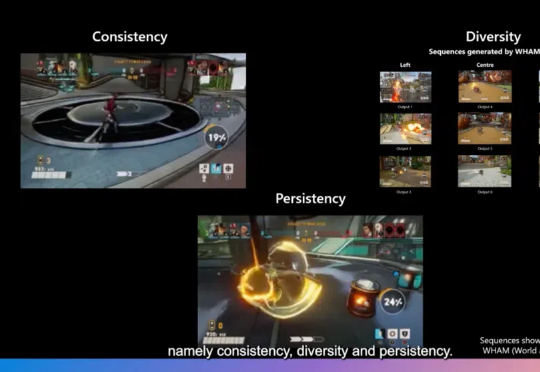

游戏开发不仅需要生成新颖的内容,更需要在保持游戏世界一致性、多样性和用户修改持续性方面达到高度平衡。近日,一篇发表在Nature上的研究论文World and Human Action Models towards Gameplay Ideation揭示了如何利用生成式AI模型推动游戏玩法创意的生成。