啪啪打脸!Search-R1让DeepSeek-R1实时获取信息,实现26%提升的争议与启发 | 最新

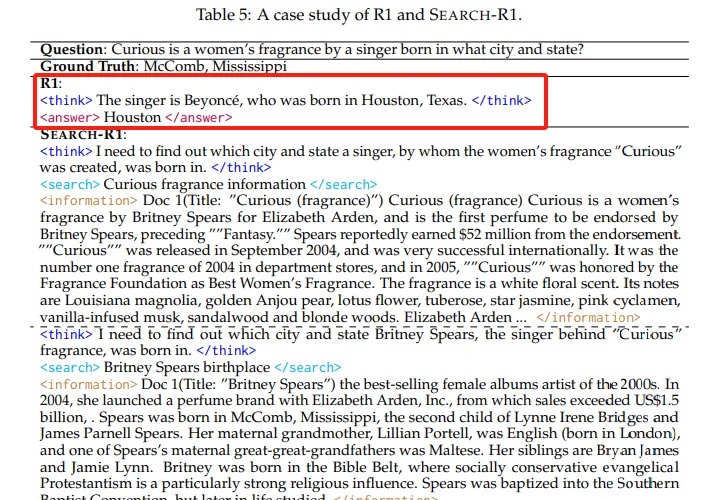

啪啪打脸!Search-R1让DeepSeek-R1实时获取信息,实现26%提升的争议与启发 | 最新本文介绍了Search-R1技术,这是一项通过强化学习训练大语言模型进行推理并利用搜索引擎的创新方法。实验表明,Search-R1在Qwen2.5-7B模型上实现了26%的性能提升,使模型能够实时获取准确信息并进行多轮推理。本文详细分析了Search-R1的工作原理、训练方法和实验结果,为AI产品开发者提供了重要参考。