音乐界迎来自己的DeepSeek!全球首个音乐推理大模型Mureka O1上线,超越Suno

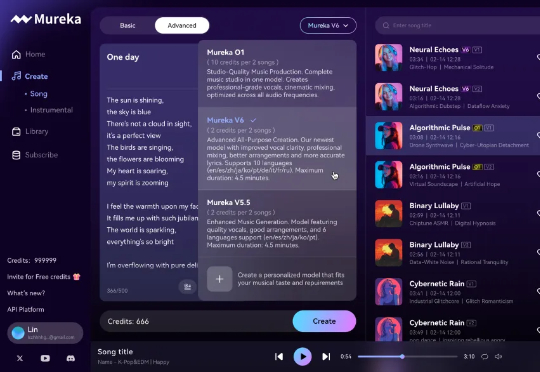

音乐界迎来自己的DeepSeek!全球首个音乐推理大模型Mureka O1上线,超越Suno2025 年第一款现象级的 AI 音乐爆品,就这么华丽丽地来了!3 月 26 日,国内「All in AGI 与 AIGC」的科技公司 —— 昆仑万维,发布了最新音乐大模型 Mureka V6 和 O1,给全球音乐圈带来了不小的震撼。

2025 年第一款现象级的 AI 音乐爆品,就这么华丽丽地来了!3 月 26 日,国内「All in AGI 与 AIGC」的科技公司 —— 昆仑万维,发布了最新音乐大模型 Mureka V6 和 O1,给全球音乐圈带来了不小的震撼。

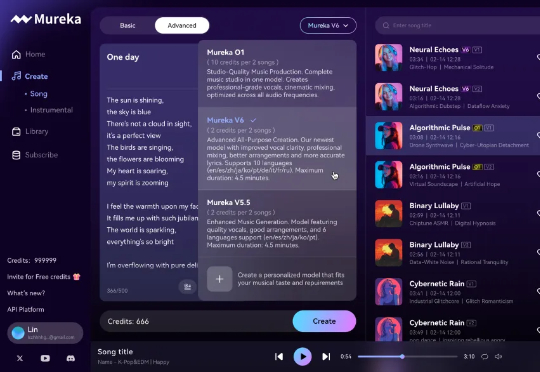

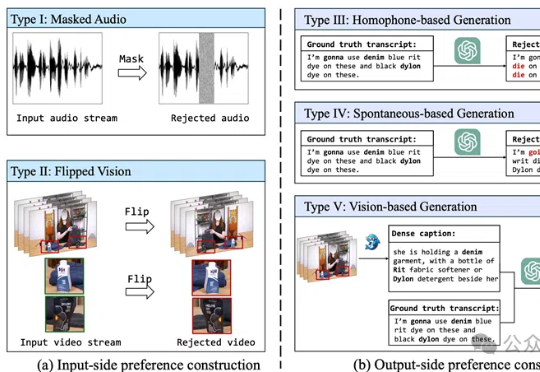

视觉+语音=更强的语音识别!BPO-AVASR通过优化音视频输入和输出偏好,提升语音识别在真实场景中的准确性,解决了传统方法在噪声、口语化和视觉信息利用不足的问题。

如今,哈佛斯坦福这类顶尖名校的中国毕业生,开始向DeepSeek等中国AI公司疯狂投简历了!与此同时,美国众议院则被曝出直接质问斯坦福、CMU等六所大学:为何招收如此多中国学生参加STEM项目?并且要求上交所有中国学生信息。

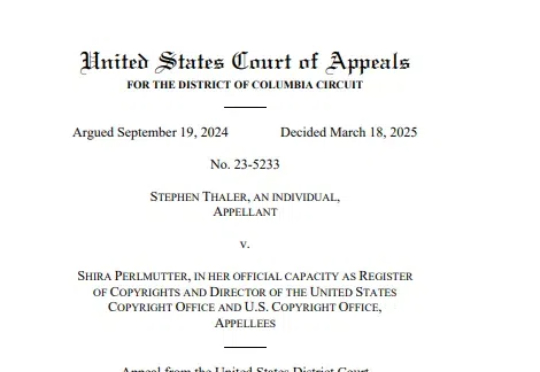

3月18日,美国哥伦比亚特区巡回上诉法院就科学家Stephen Thaler(史蒂芬·泰勒博士,下称泰勒)诉Shira Perlmutter(美国版权局注册官及美国版权办公室主任)以及美国版权局作出标志性判决,认定所有受版权保护的作品必须首先由人类创作。尽管AI技术的发展使得非人类创作的作品越来越多,但根据现有的法律框架,这些作品无法获得版权保护。

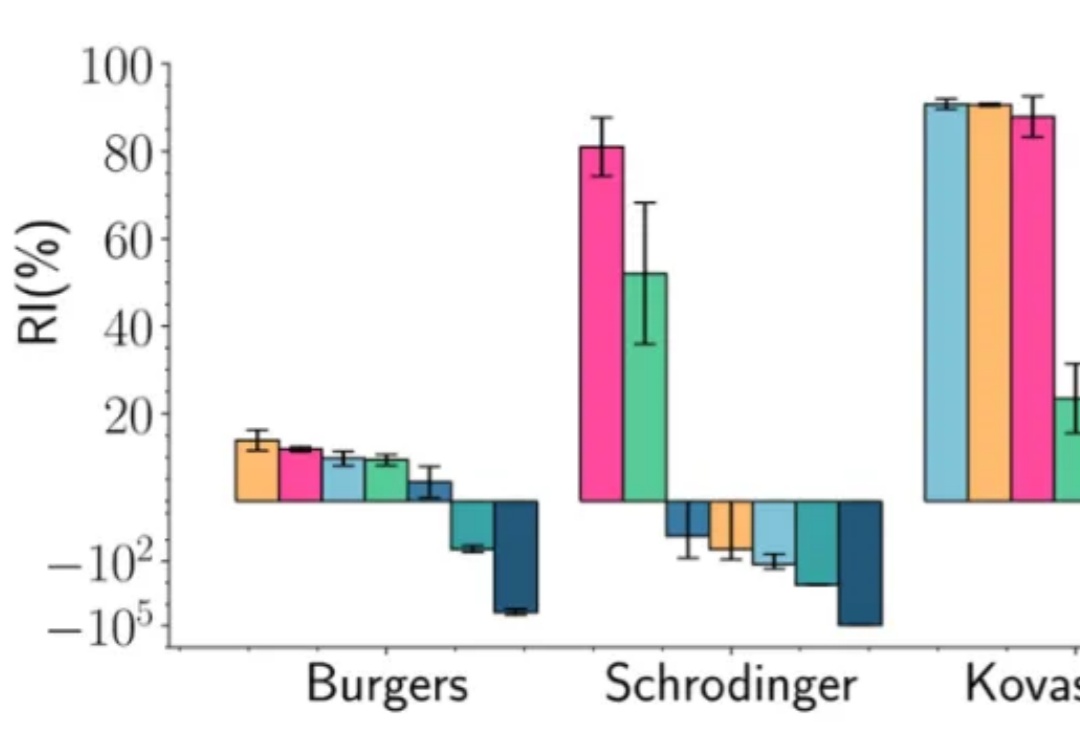

在深度学习的多个应用场景中,联合优化多个损失项是一个普遍的问题。典型的例子包括物理信息神经网络(Physics-Informed Neural Networks, PINNs)、多任务学习(Multi-Task Learning, MTL)和连续学习(Continual Learning, CL)。然而,不同损失项的梯度方向往往相互冲突,导致优化过程陷入局部最优甚至训练失败。

尽管 DeepSeek-R1 在单模态推理中取得了显著成功,但已有的多模态尝试(如 R1-V、R1-Multimodal-Journey、LMM-R1)尚未完全复现其核心特征。

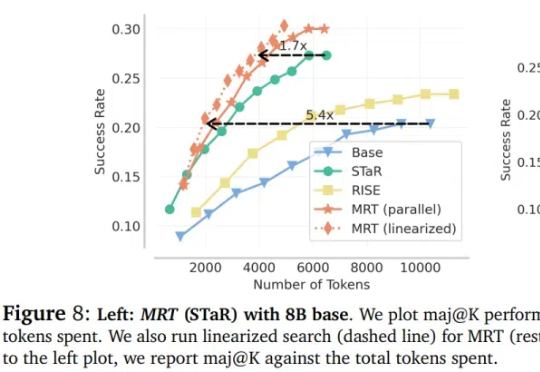

大语言模型(LLM)在推理领域的最新成果表明了通过扩展测试时计算来提高推理能力的潜力,比如 OpenAI 的 o1 系列。

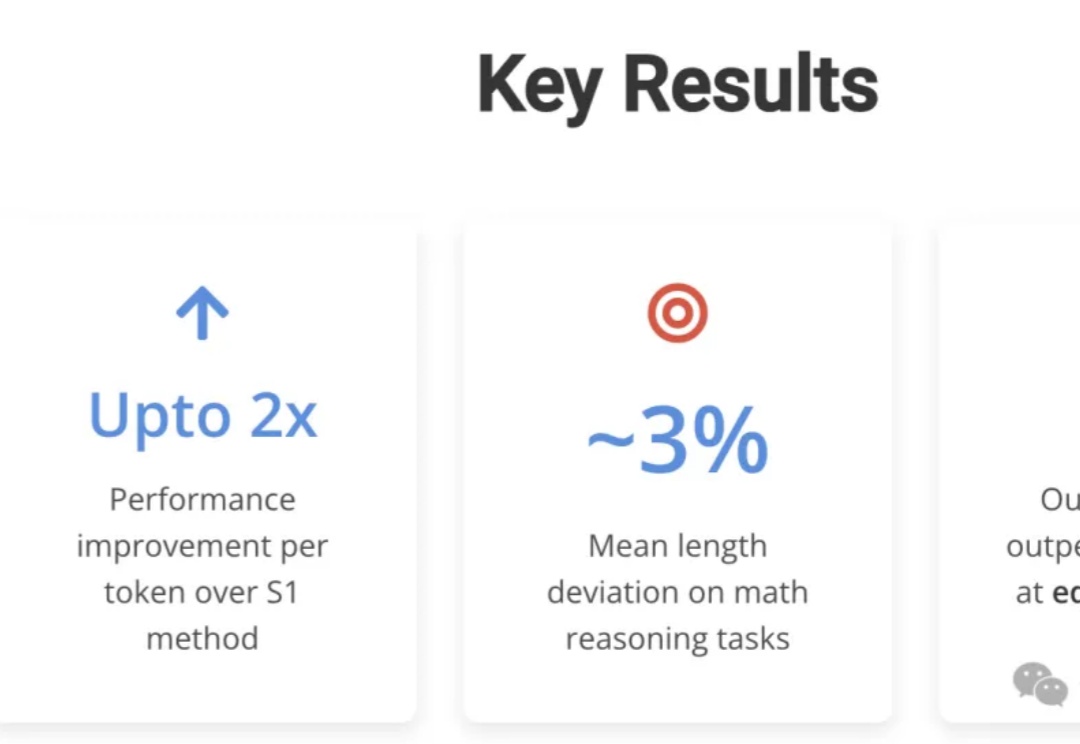

CMU团队用LCPO训练了一个15亿参数的L1模型,结果令人震惊:在数学推理任务中,它比S1相对提升100%以上,在逻辑推理和MMLU等非训练任务上也能稳定发挥。更厉害的是,要求短推理时,甚至击败了GPT-4o——用的还是相同的token预算!

在面对复杂的推理任务时,SFT往往让大模型显得力不从心。最近,CMU等机构的华人团队提出了「批判性微调」(CFT)方法,仅在 50K 样本上训练,就在大多数基准测试中优于使用超过200万个样本的强化学习方法。

DeepSeek-R1 作为 AI 产业颠覆式创新的代表轰动了业界,特别是其训练与推理成本仅为同等性能大模型的数十分之一。多头潜在注意力网络(Multi-head Latent Attention, MLA)是其经济推理架构的核心之一,通过对键值缓存进行低秩压缩,显著降低推理成本 [1]。