从零手搓MoE大模型,大神级教程来了

从零手搓MoE大模型,大神级教程来了Hugging Face上有一位机器学习大神,分享了如何从头开始建立一套完整的MoE系统。

Hugging Face上有一位机器学习大神,分享了如何从头开始建立一套完整的MoE系统。

一张名为《大模型的深渊》的图,在去年广为流行。吃瓜群众惊诧地发现,原来绝大多数大模型,都挤在深不见底的层级,“宣称自己快要落地的”“再等等决定啥时候落地的”“什么落地不落地的”“怎么还有这么多没听说过的大模型啊”……

一项ICLR拒稿结果让AI研究者集体破防,纷纷刷起小丑符号。争议论文为Transformer架构挑战者Mamba,开创了大模型的一个新流派。发布两个月不到,后续研究MoE版本、多模态版本等都已跟上。

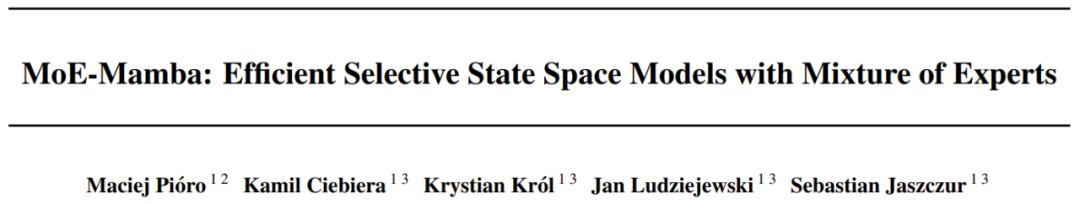

状态空间模型(SSM)是近来一种备受关注的 Transformer 替代技术,其优势是能在长上下文任务上实现线性时间的推理、并行化训练和强大的性能。而基于选择性 SSM 和硬件感知型设计的 Mamba 更是表现出色,成为了基于注意力的 Transformer 架构的一大有力替代架构。

本文将介绍 MoE 的构建模块、训练方法以及在使用它们进行推理时需要考虑的权衡因素。

这项综述性研究报告批判性地分析了生成式AI的发展现状和发展方向,并探究了谷歌Gemini和备受期待的OpenAI Q*等创新成果将如何改变多个领域的实际应用。

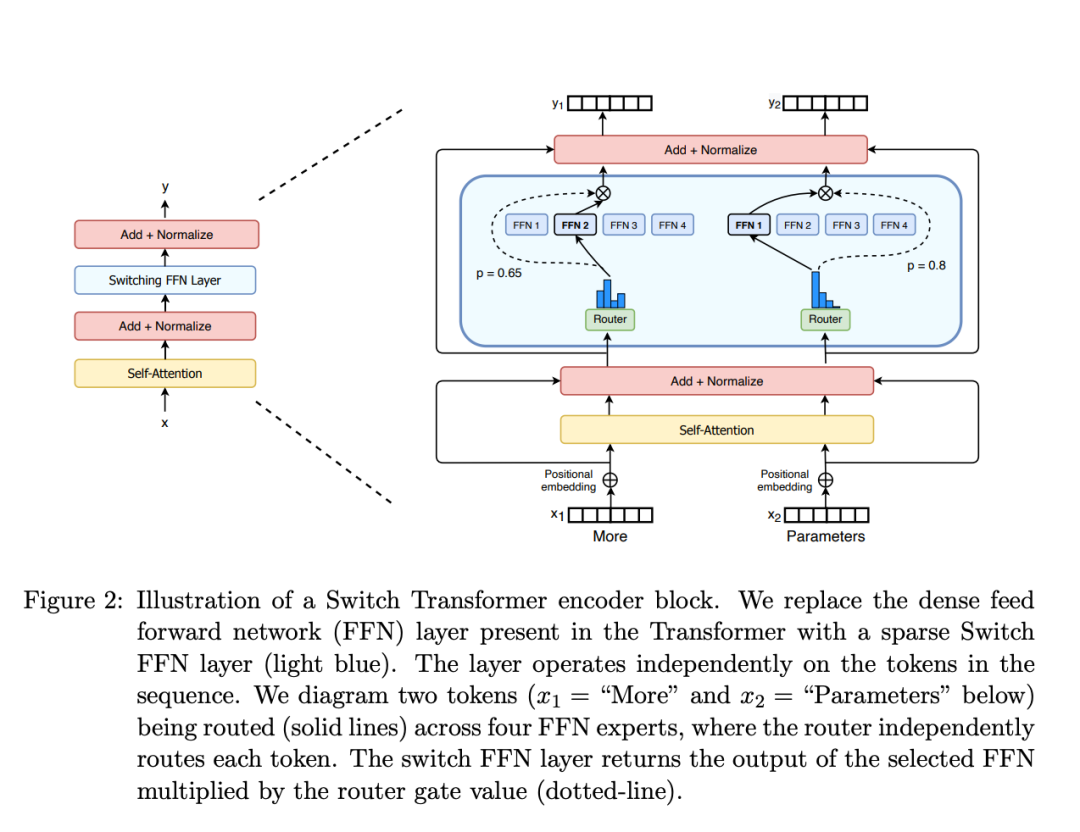

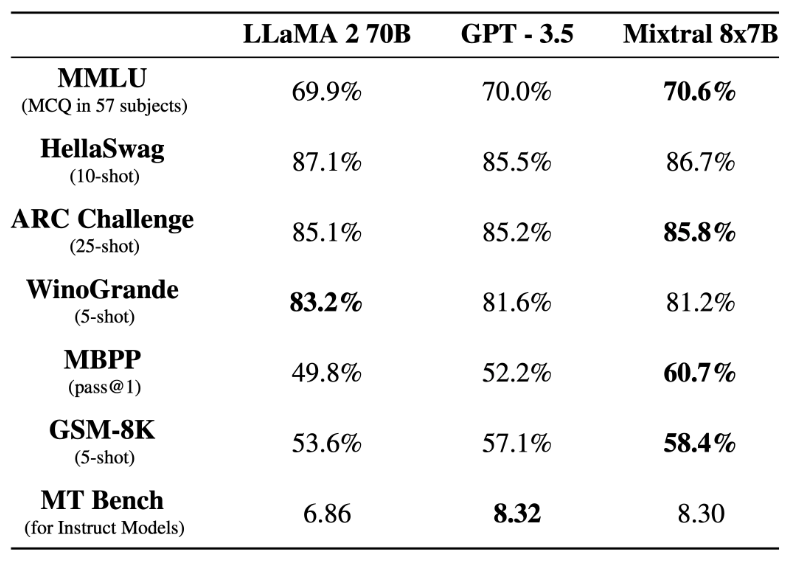

前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

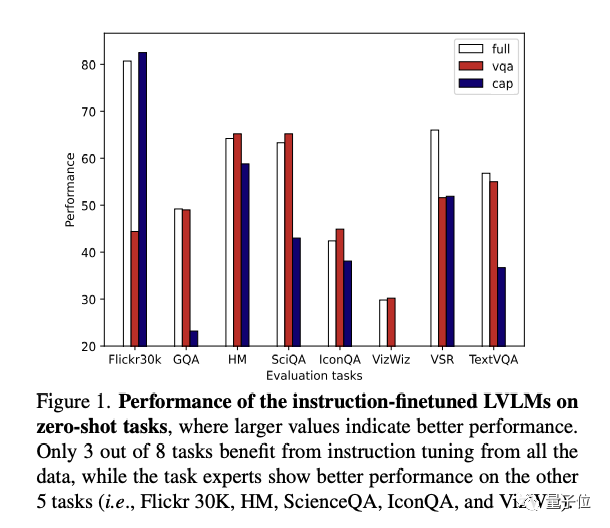

多模态大模型做“多任务指令微调”,大模型可能会“学得多错得多”,因为不同任务之间的冲突,导致泛化能力下降。

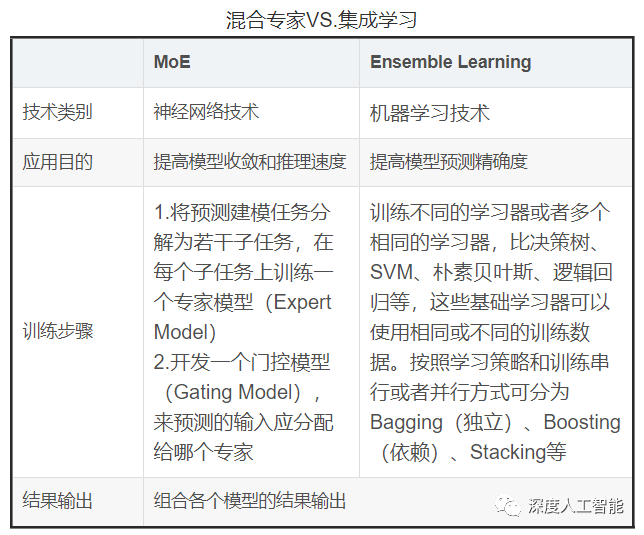

混合专家模型(MoE)成为最近关注的热点。

一条神秘磁力链接引爆整个AI圈,现在,正式测评结果终于来了:首个开源MoE大模型Mixtral 8x7B,已经达到甚至超越了Llama 2 70B和GPT-3.5的水平。