2B小钢炮碾压Mistral-7B,旗舰级端侧模型炸场开年黑马!1080Ti可训,170万tokens成本仅1元

2B小钢炮碾压Mistral-7B,旗舰级端侧模型炸场开年黑马!1080Ti可训,170万tokens成本仅1元2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!

2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!

近日,一则关于「Mistral-Medium 模型泄露」的消息引起了大家的关注。

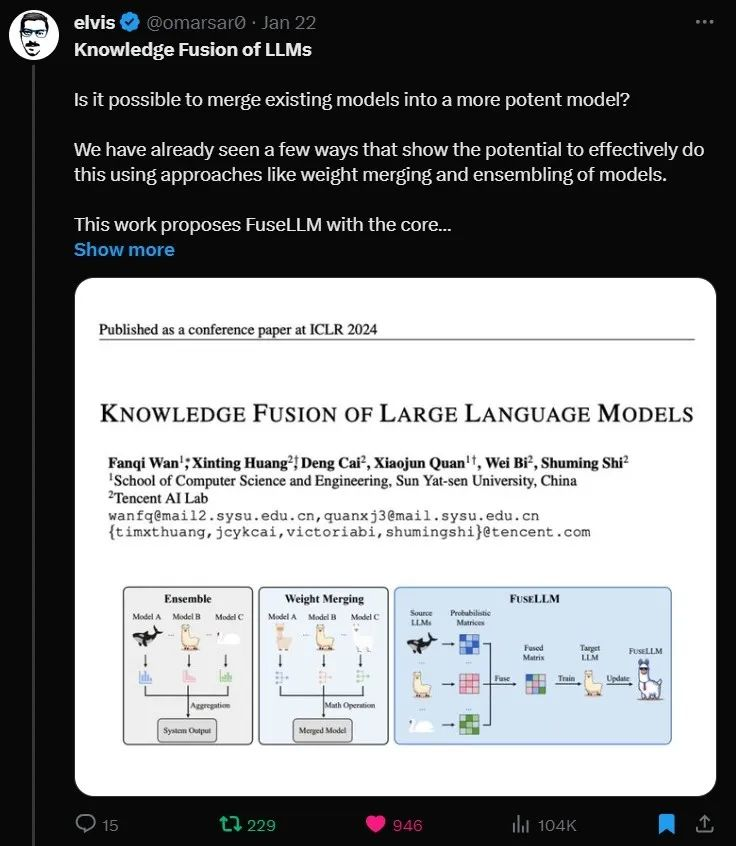

融合多个异构大语言模型,中山大学、腾讯 AI Lab 推出 FuseLLM

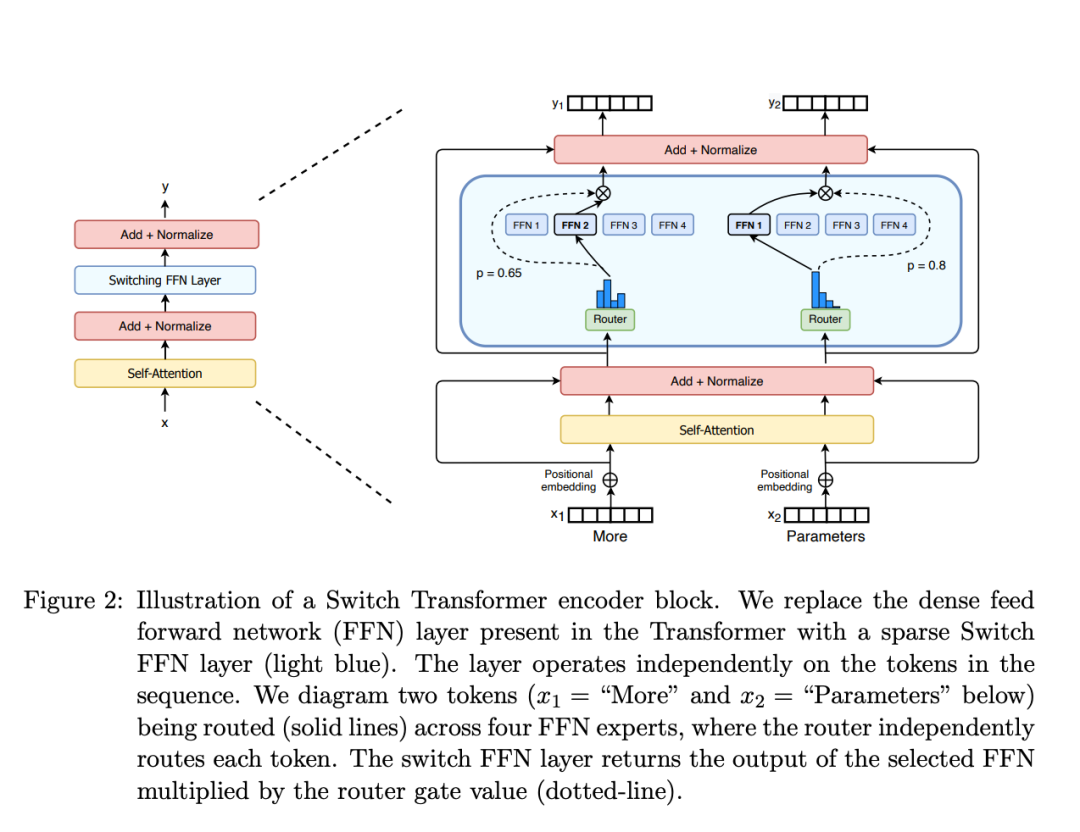

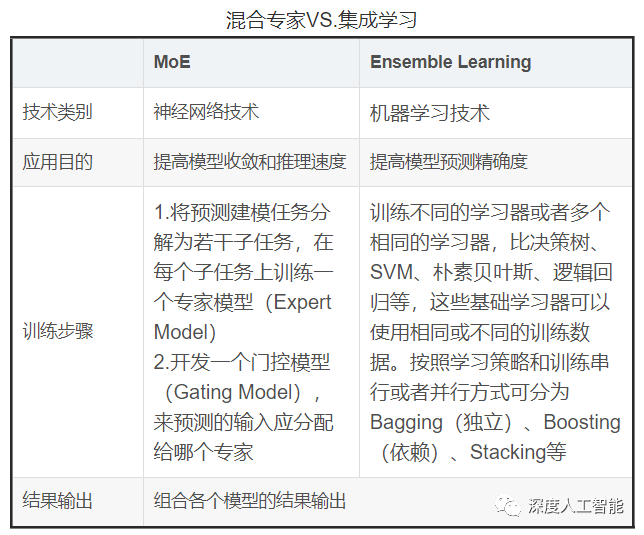

本文将介绍 MoE 的构建模块、训练方法以及在使用它们进行推理时需要考虑的权衡因素。

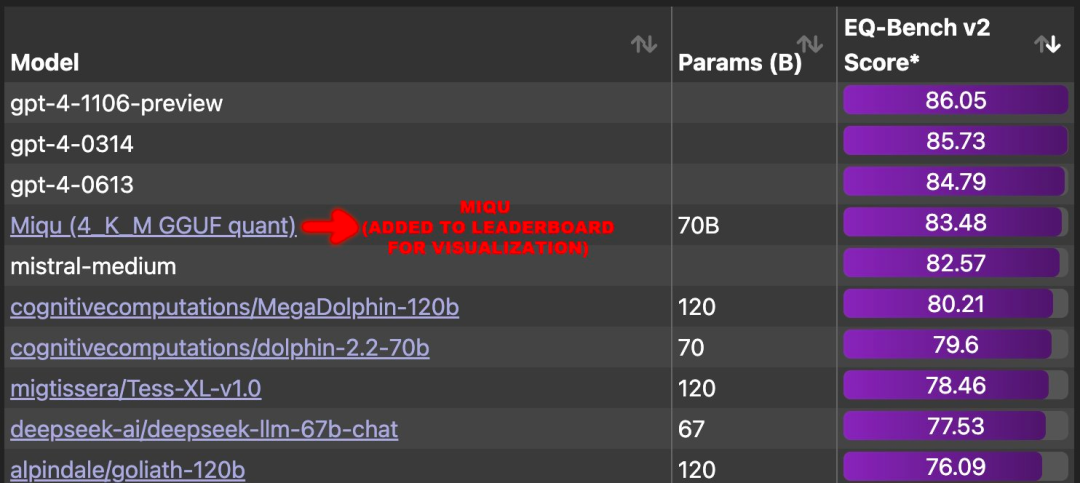

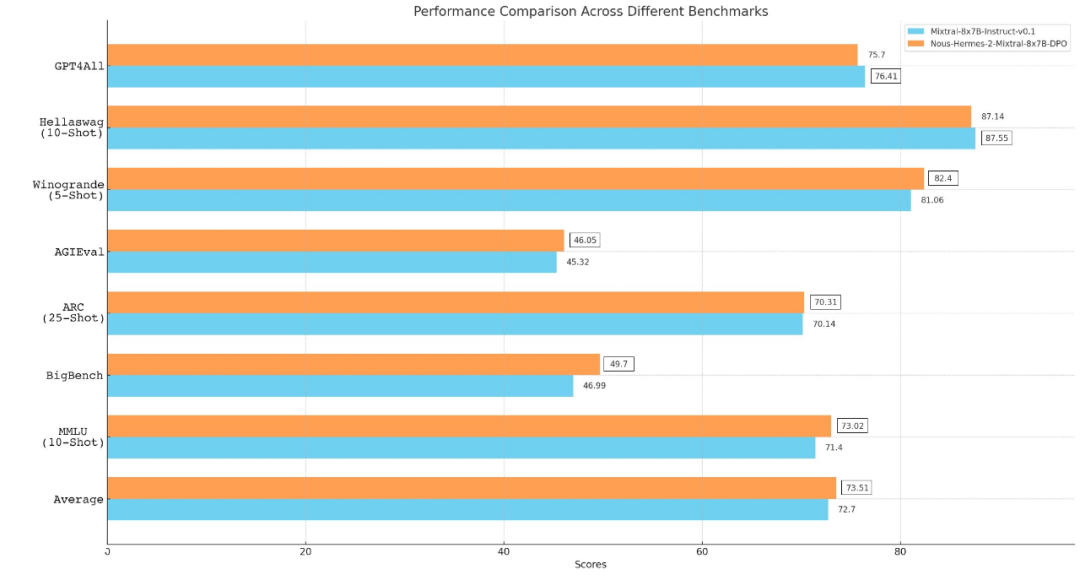

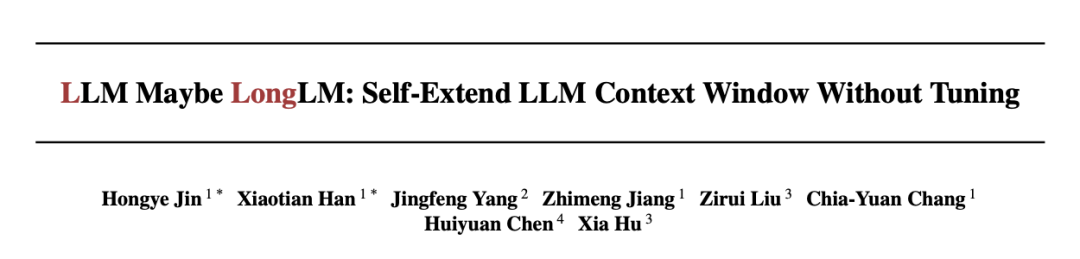

从 Llama、Llama 2 到 Mixtral 8x7B,开源模型的性能记录一直在被刷新。由于 Mistral 8x7B 在大多数基准测试中都优于 Llama 2 70B 和 GPT-3.5,因此它也被认为是一种「非常接近 GPT-4」的开源选项。

2023年,有超过10家AI初创公司接受了传统科技巨头的大额投资,不断建立并且强化了微软—OpenAI式的合作关系,甚至引发了英美两国的监管机构的关注。

爆火社区的Mixtral 8x7B模型,今天终于放出了arXiv论文!所有模型细节全部公开了。

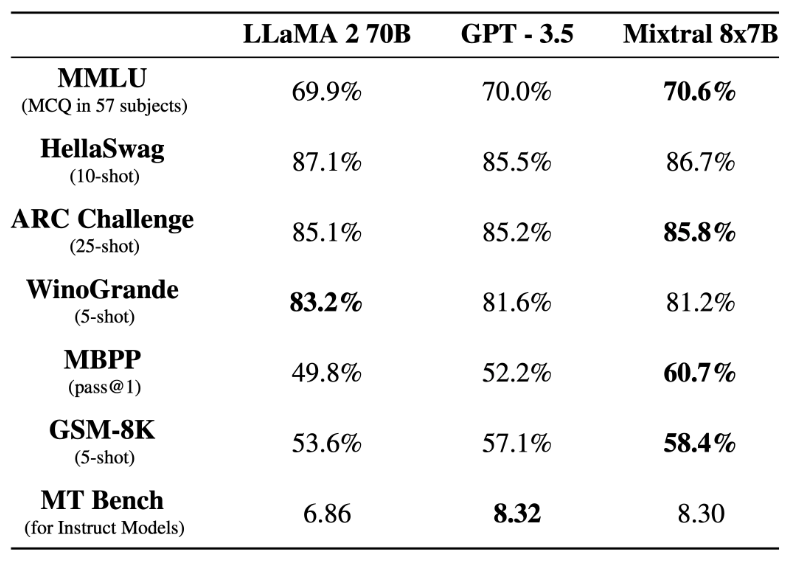

无需微调,只要四行代码就能让大模型窗口长度暴增,最高可增加3倍!而且是“即插即用”,理论上可以适配任意大模型,目前已在Mistral和Llama2上试验成功。

前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

混合专家模型(MoE)成为最近关注的热点。