完全使用「自生成数据」实现LLM自我纠正,DeepMind新突破SCoRe:纠正性能提升15.9%

完全使用「自生成数据」实现LLM自我纠正,DeepMind新突破SCoRe:纠正性能提升15.9%Google DeepMind的SCoRe方法通过在线多轮强化学习,显著提升了大型语言模型在没有外部输入的情况下的自我修正能力。该方法在MATH和HumanEval基准测试中,分别将自我修正性能提高了15.6%和9.1%。

Google DeepMind的SCoRe方法通过在线多轮强化学习,显著提升了大型语言模型在没有外部输入的情况下的自我修正能力。该方法在MATH和HumanEval基准测试中,分别将自我修正性能提高了15.6%和9.1%。

OpenAI的o1系列一发布,传统数学评测基准都显得不够用了。

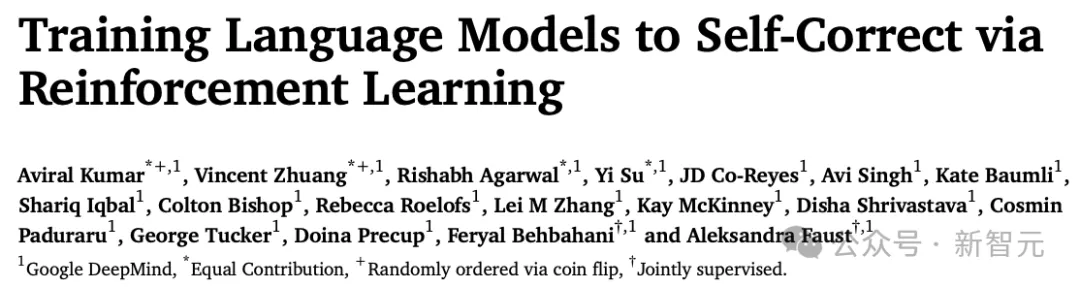

AI 与数学普惠。这一期将作为“AI+教育”系列的中篇来聊一聊 AI 在数学领域的应用。

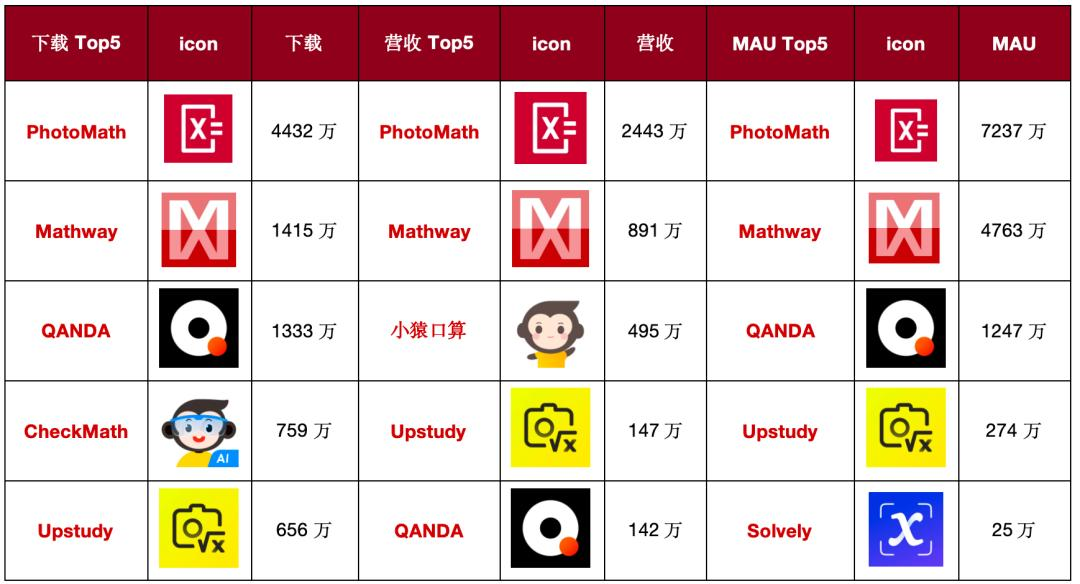

快速更迭的开源大模型领域,又出现了新王:Reflection 70B。 横扫 MMLU、MATH、IFEval、GSM8K,在每项基准测试上都超过了 GPT-4o,还击败了 405B 的 Llama 3.1。 这个新模型 Reflection 70B,来自 AI 写作初创公司 HyperWrite。

现在,最强数学大模型,人人都可上手玩了!

这几日,AI 圈又一“震惊”事件!!

网友很好奇,Mathstral能不能搞定「9.11和9.9谁大」这一问题。

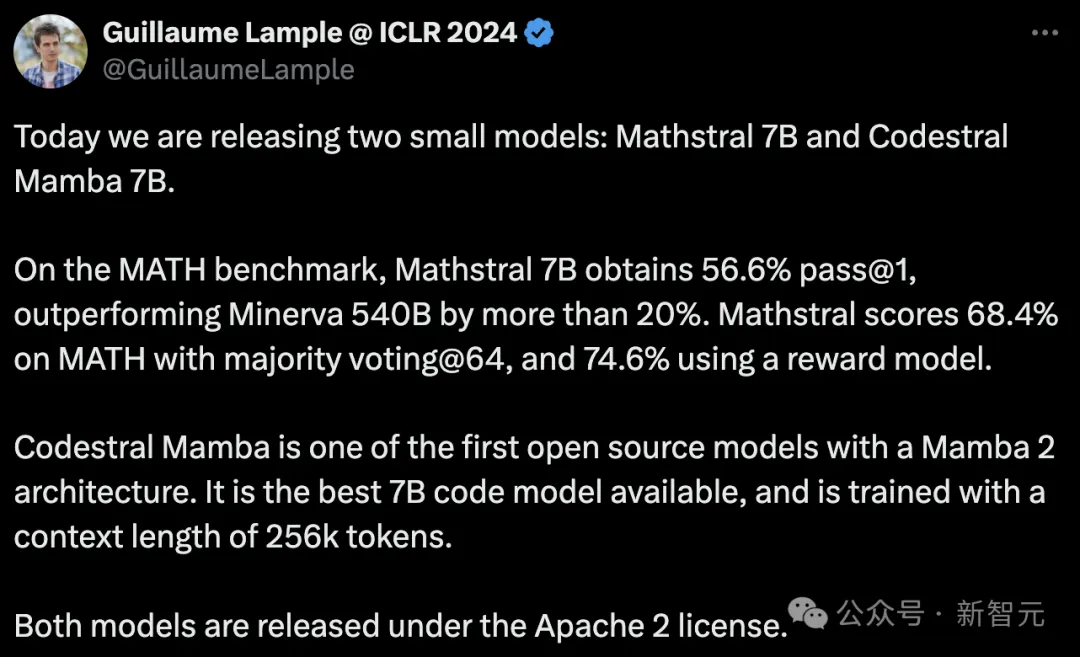

最近,7B小模型又成为了AI巨头们竞相追赶的潮流。继谷歌的Gemma2 7B后,Mistral今天又发布了两个7B模型,分别是针对STEM学科的Mathstral,以及使用Mamaba架构的代码模型Codestral Mamba。

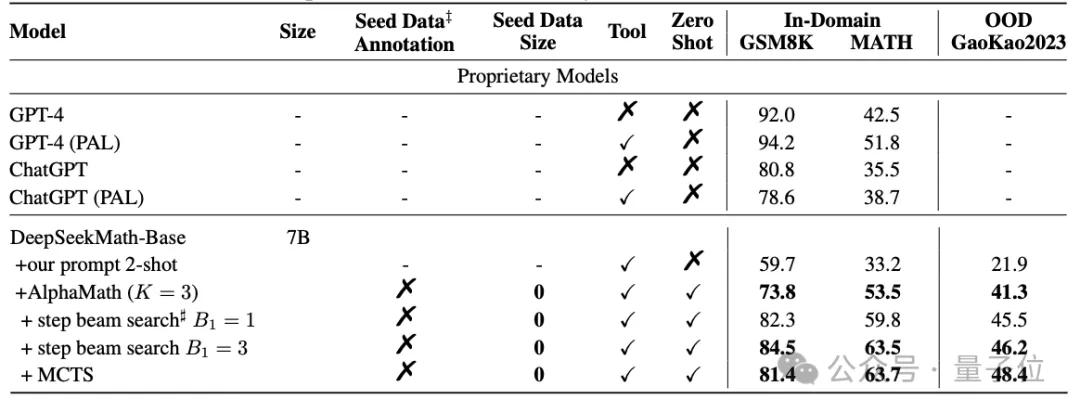

把AlphaGo的核心算法用在大模型上,“高考”成绩直接提升了20多分。

在大算力的数字化时代下,大语言模型(LLM)以其令人瞩目的发展速度,正引领着技术的潮流