三个LLM顶一个OpenAI?2亿条性能记录加持,路由n个「小」模型逆袭

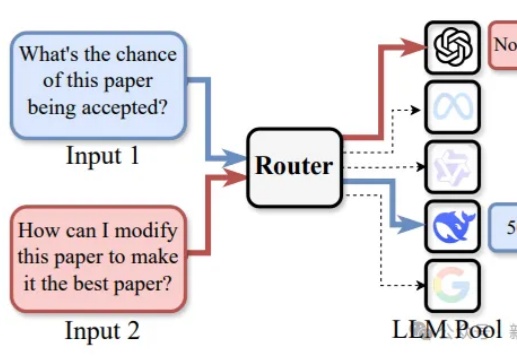

三个LLM顶一个OpenAI?2亿条性能记录加持,路由n个「小」模型逆袭路由LLM是指一种通过router动态分配请求到若干候选LLM的机制。论文提出且开源了针对router设计的全面RouterEval基准,通过整合8500+个LLM在12个主流Benchmark上的2亿条性能记录。将大模型路由问题转化为标准的分类任务,使研究者可在单卡甚至笔记本电脑上开展前沿研究。

路由LLM是指一种通过router动态分配请求到若干候选LLM的机制。论文提出且开源了针对router设计的全面RouterEval基准,通过整合8500+个LLM在12个主流Benchmark上的2亿条性能记录。将大模型路由问题转化为标准的分类任务,使研究者可在单卡甚至笔记本电脑上开展前沿研究。

今年年初,OpenAI 上线 Deep Research,开启了智能体又一新阶段,其能根据用户需求自主进行网络信息检索、整合多源信息、深度分析数据,并最终为用户提供全面深入的解答。

近年来,代码评测集数量激增,但质量参差不齐。为规范其开发,香港科技大学联合多所高校研究了过去十年的274个代码评测集,发现诸多问题,如数据重复、测试用例错误、隐私信息未删除等。基于此,他们推出了《代码评测集发展指南55项》(How2Bench),涵盖设计、构建、评测、分析、发布五大阶段,旨在提升代码评测集的质量与可靠性。

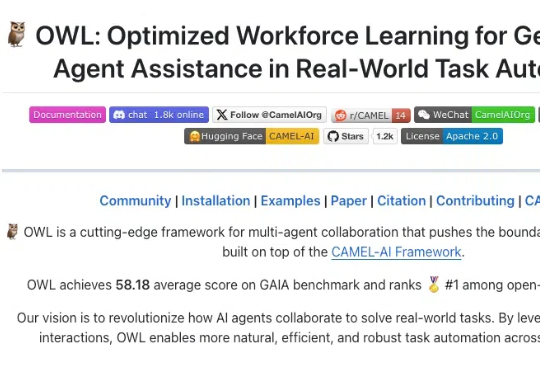

自媒体的反应堪称狂热:“通用Agent终于实现了!”“这是继DeepSeek之后的又一技术革命!”这样夸张的赞誉随处可见。从Benchmark来看,它的表现确实非常亮眼,在GAIA测试中超越了之前的各种Agent以及OpenAI的DeepResearch。

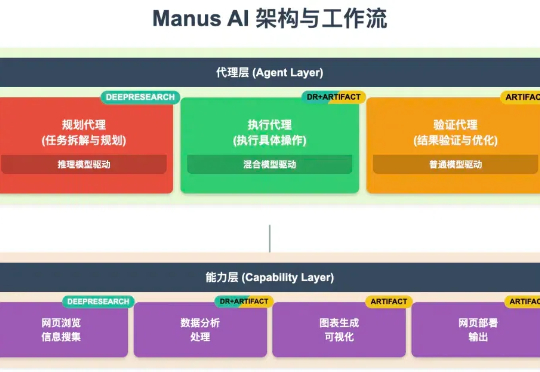

最近AI圈最炸的瓜,毫无疑问是——Manus!一个AI Agent,不仅能刷GAIA Benchmark,还能远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」。听起来确实很能打?但我们 CAMEL-AI的🦉OWL项目看完Manus视频,集体摊手:就这?0天复刻走起!

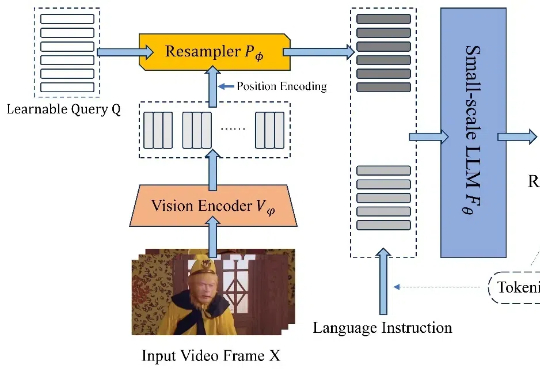

近日,北京航空航天大学的研究团队基于 TinyLLaVA_Factory 的原项目,推出小尺寸简易视频理解框架 TinyLLaVA-Video,其模型,代码以及训练数据全部开源。在计算资源需求显著降低的前提下,训练出的整体参数量不超过 4B 的模型在多个视频理解 benchmark 上优于现有的 7B + 模型。

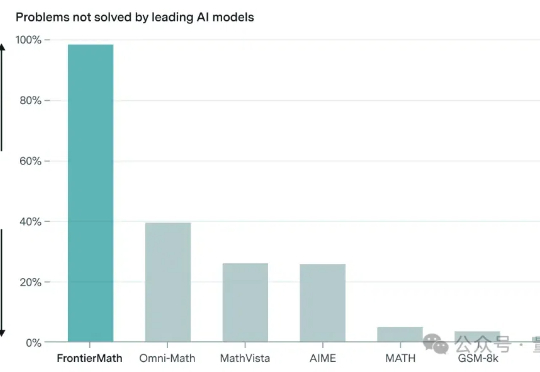

OpenAI o3还没上线,就被曝数学成绩是靠作弊得来?!Benchmark发布机构内部人员爆料称,OpenAI给了他们经费赞助。就连包括陶哲轩在内参与出题的60余名数学家,在消息曝光之前也都和普通公众一样蒙在鼓里。

AI编程蓝皮书火了,发布3天,阅读量超过3万!

2024年11月15日,加州理工学院生物学和生物工程系的Jieyu Zheng和Markus Meister发表了一篇震撼学界的论文《The Unbearable Slowness of Being: Why do we live at 10 bit/s?》[1]。这项研究揭示了一个令人不安的事实:人类大脑每秒仅能处理大约10比特信息。

2023 年,阿里妈妈首次提出了 AIGB(AI-Generated Bidding)Bidding 模型训练新范式(参阅:阿里妈妈生成式出价模型(AIGB)详解)。