李飞飞对话 a16z:LLM 是有损压缩,世界模型才是真正重要方向,应用远超机器人

李飞飞对话 a16z:LLM 是有损压缩,世界模型才是真正重要方向,应用远超机器人World Labs 是由著名 AI 专家、斯坦福大学教授李飞飞于 2024 年创办的初创公司,致力于开发具备“空间智能”的下一代 AI 系统。

World Labs 是由著名 AI 专家、斯坦福大学教授李飞飞于 2024 年创办的初创公司,致力于开发具备“空间智能”的下一代 AI 系统。

李飞飞空间智能创业公司World Labs,开源一项核心技术!

人工智能搜索引擎Perplexity重磅发布新产品Perplexity Labs,这是一款面向专业版用户(20美金/月)的智能Agent工具,为用户提供了更强大的生产力解决方案。用户可以在搜索框下方一键切换至"实验室模式",通过该模式可高效生成:专业分析报告、结构化电子表格、交互式网页应用、数据可视化图表等。

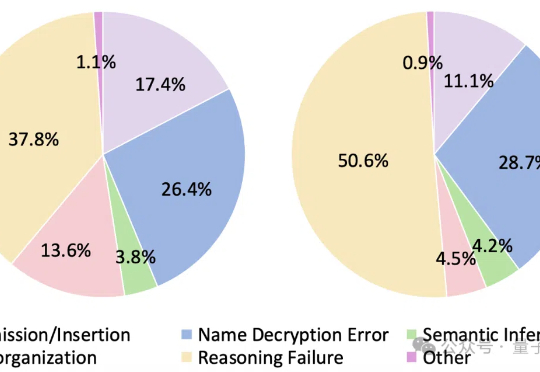

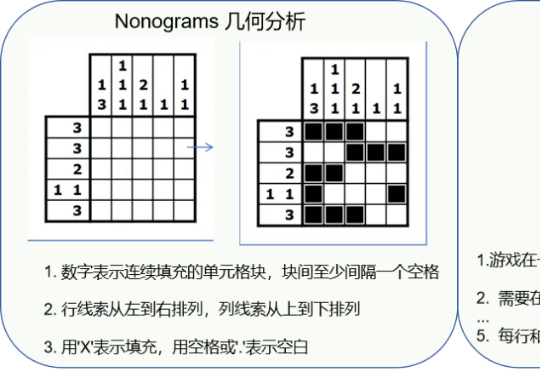

大语言模型遇上加密数据,即使是最新Qwen3也直冒冷汗!

上周的开发者大会,谷歌冷不丁地掏出个 Veo3 就惊艳了全球。

第一财经「新皮层」独家获得消息称,小红书已将内部大模型技术与应用产品团队升级为「hi lab」(人文智能实验室,Humane Intelligence Lab)。同时,小红书今年年初开始组建「AI人文训练师」团队,邀请有深厚人文背景的研究者与AI领域的算法工程师、科学家共同完成对AI的后训练,以训练AI具有更好的人文素养以及表现上的一致性。而这个「AI人文训练师」团队也隶属于「hi lab」。

2002年,在拿下中国高校第一个ACM(计算机领域最顶尖的程序设计大赛)金牌后,上海交大设立了“ACM班”,这个用最高竞赛命名的班级后来人尽皆知,成为中国AI人才的重要阵地。也在那年,李磊成为ACM班第一届的学生。在ACM班他第一次意识到,“原来计算机能帮助解决人类的这么多问题。”

围棋因其独特的复杂性和对人类智能的深刻体现,可作为衡量AI专业能力最具代表性的任务之一。

OpenAI 研究员姚顺雨近期发布文章,指出:AI 下半场将聚焦问题定义与评估体系重构。在 AI 发展新阶段,行业需要通过设计更有效的模型评测体系,弥补 AI 能力与真实需求的差距。

来自香港科技大学、腾讯西雅图AI Lab、爱丁堡大学、Miniml.AI、英伟达的研究者联合提出了MMLongBench,旨在全面评估多模态模型的长文本理解能力。