100 页 Agentic RL 综述!牛津、新国立、AI Lab 等联合定义 LLM 下半场

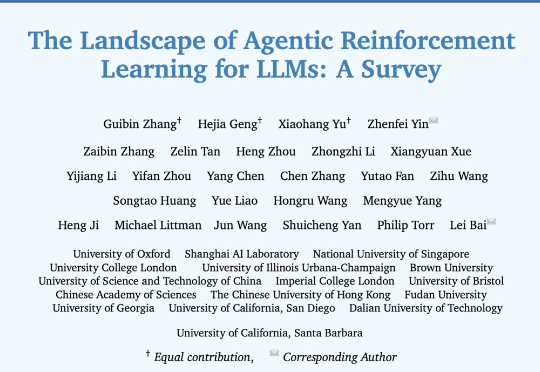

100 页 Agentic RL 综述!牛津、新国立、AI Lab 等联合定义 LLM 下半场来自牛津大学、新加坡国立大学、伊利诺伊大学厄巴纳-香槟分校,伦敦大学学院、帝国理工学院、上海人工智能实验室等等全球 16 家顶尖研究机构的学者,共同撰写并发布了长达百页的综述:《The Landscape of Agentic Reinforcement Learning for LLMs: A Survey》。