2B小钢炮碾压Mistral-7B,旗舰级端侧模型炸场开年黑马!1080Ti可训,170万tokens成本仅1元

2B小钢炮碾压Mistral-7B,旗舰级端侧模型炸场开年黑马!1080Ti可训,170万tokens成本仅1元2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!

2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!

羊驼家族的“最强开源代码模型”,迎来了它的“超大杯”——就在今天凌晨,Meta宣布推出Code Llama的70B版本。

删除权重矩阵的一些行和列,让 LLAMA-2 70B 的参数量减少 25%,模型还能保持 99% 的零样本任务性能,同时计算效率大大提升。这就是微软 SliceGPT 的威力。

Meta 正式发布 Code Llama 70B,这是 Code Llama 系列有史以来最大、性能最好的型号。

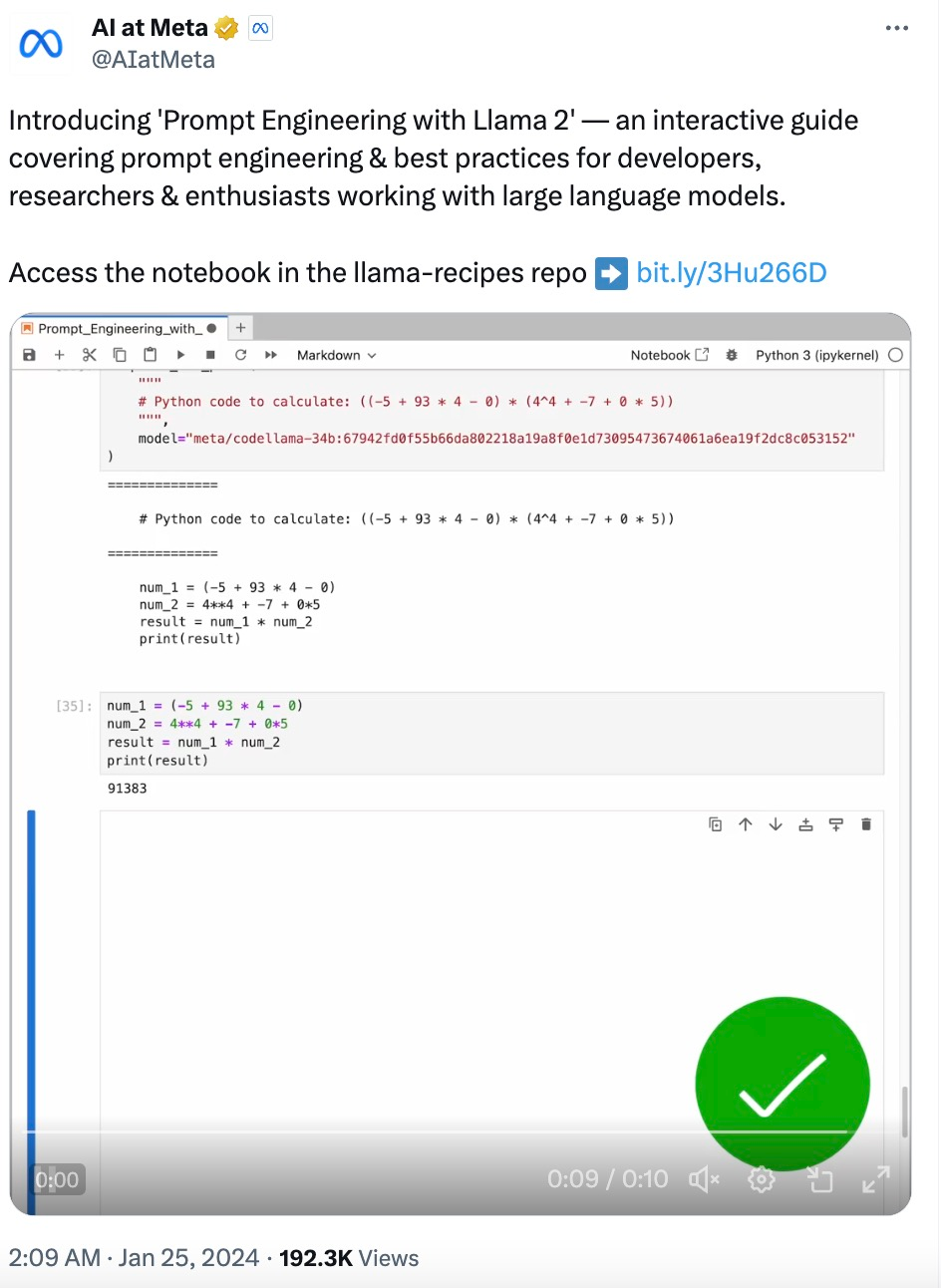

随着大型语言模型(LLM)技术日渐成熟,提示工程(Prompt Engineering)变得越来越重要。一些研究机构发布了 LLM 提示工程指南,包括微软、OpenAI 等等。

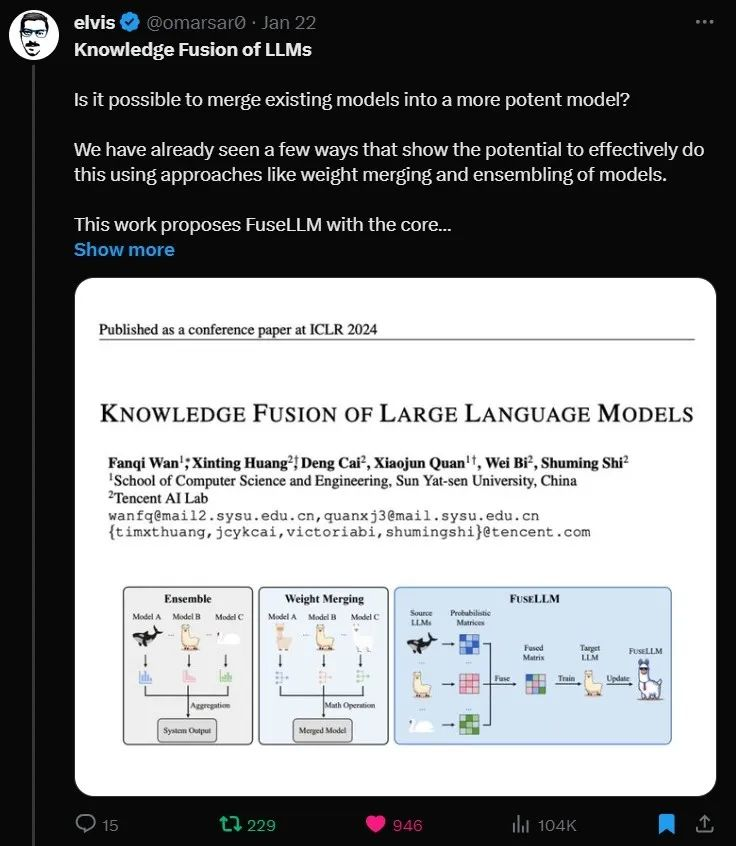

融合多个异构大语言模型,中山大学、腾讯 AI Lab 推出 FuseLLM

1月18日,马克·扎克伯格宣布,Meta正在计划构建自己的AGI(通用人工智能),将在绝大多数领域中都达到或超越人类智能水平。同时他强调,保证会向大众开放这一技术,以便人人都能从中获益。

AI训AI必将成为一大趋势。Meta和NYU团队提出让大模型「自我奖励」的方法,让Llama2一举击败GPT-4 0613、Claude 2、Gemini Pro领先模型。

昨天,Meta、纽约大学的研究者用「自我奖励方法」,让大模型自己生成自己的微调数据,从而在 Llama 2 70B 的迭代微调后超越了 GPT-4。今天,英伟达的全新对话 QA 模型「ChatQA-70B」在不使用任何 GPT 模型数据的情况下,在 10 个对话 QA 数据集上的平均得分略胜于 GPT-4。

智东西1月19日消息,今日,外媒The Verge刊登了Meta的首席执行官马克·扎克伯格(Mark Zuckerberg)的一场最新专访,小扎首次明确宣布投身通用人工智能(AGI)并谈及具体规划。