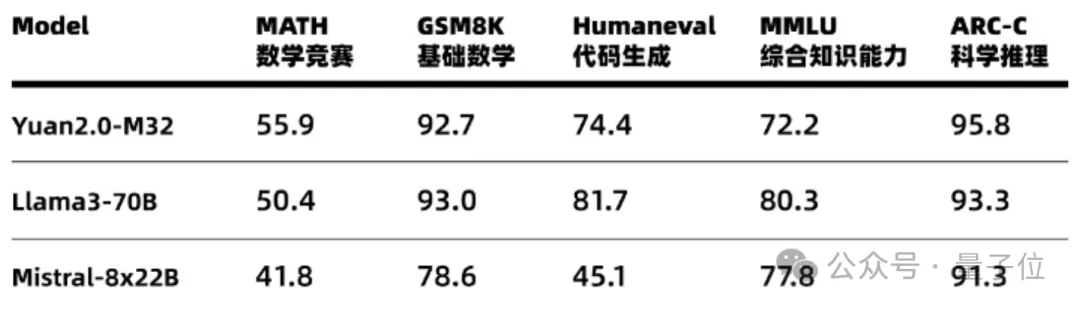

开源模型进展盘点:最新Mixtral、Llama 3、Phi-3、OpenELM到底有多好?

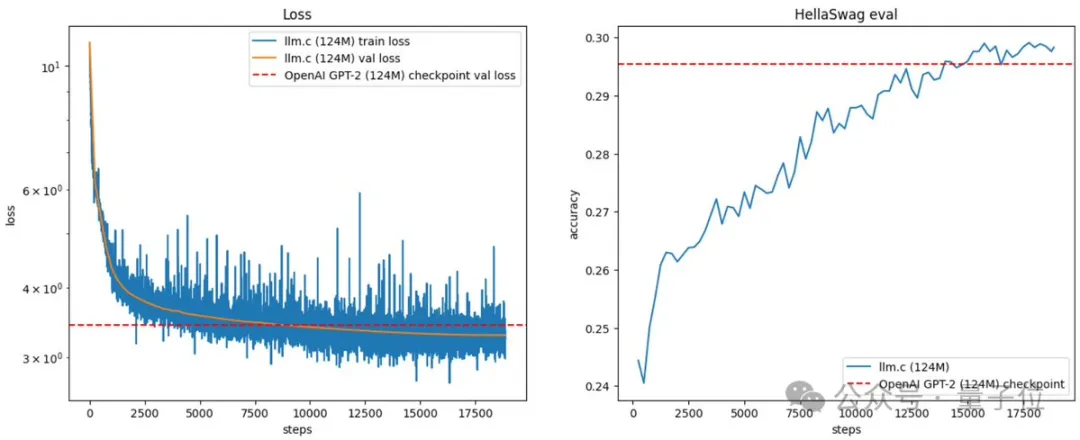

开源模型进展盘点:最新Mixtral、Llama 3、Phi-3、OpenELM到底有多好?深度学习领域知名研究者、Lightning AI 的首席人工智能教育者 Sebastian Raschka 对 AI 大模型有着深刻的洞察,也会经常把一些观察的结果写成博客。在一篇 5 月中发布的博客中,他盘点分析了 4 月份发布的四个主要新模型:Mixtral、Meta AI 的 Llama 3、微软的 Phi-3 和苹果的 OpenELM。