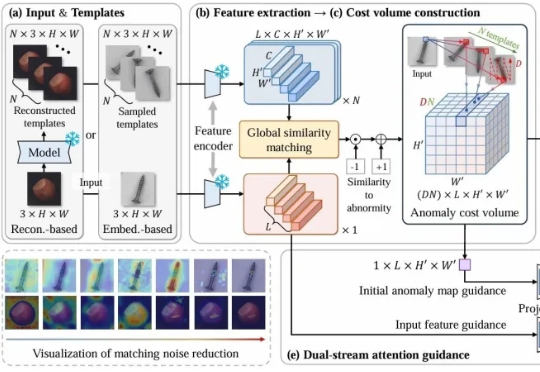

刷新无监督异常检测上限!首提「匹配代价滤波for异常检测」范式 | ICML'25

刷新无监督异常检测上限!首提「匹配代价滤波for异常检测」范式 | ICML'25CostFilter-AD通过构建异常代价体并滤波来优化异常检测,能精准识别微小缺陷,无需缺陷样本训练。可作为通用插件提升现有检测系统,帮助工厂提前发现缺陷,提高产品质量。

CostFilter-AD通过构建异常代价体并滤波来优化异常检测,能精准识别微小缺陷,无需缺陷样本训练。可作为通用插件提升现有检测系统,帮助工厂提前发现缺陷,提高产品质量。

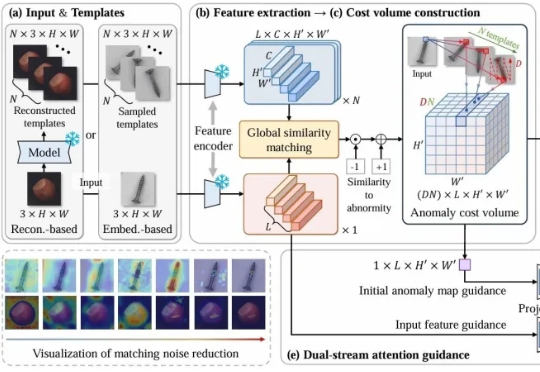

大语言模型(Large Language Model, LLM)在复杂推理任务中表现卓越。借助链式思维(Chain-of-Thought, CoT),LLM 能够将复杂问题分解为简单步骤,充分探索解题思路并得出正确答案。LLM 已在多个基准上展现出优异的推理能力,尤其是数学推理和代码生成。

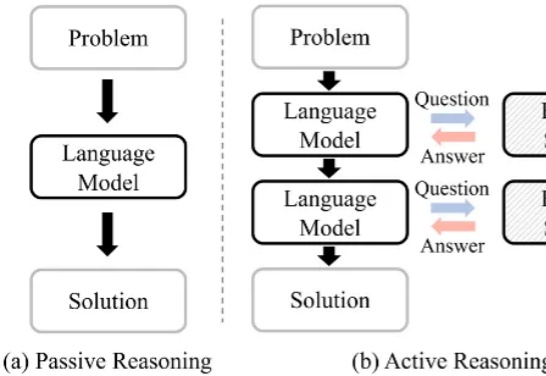

大语言模型(Large Language Models,LLMs)技术的迅猛发展,正在深刻重塑医疗行业。医疗领域正成为这一前沿技术的 “新战场” 之一。大模型具备强大的文本理解与生成能力,能够快速读取医学文献、解读病历记录,甚至基于患者表述生成初步诊断建议,有效辅助医生提升诊断的准确性与效率。

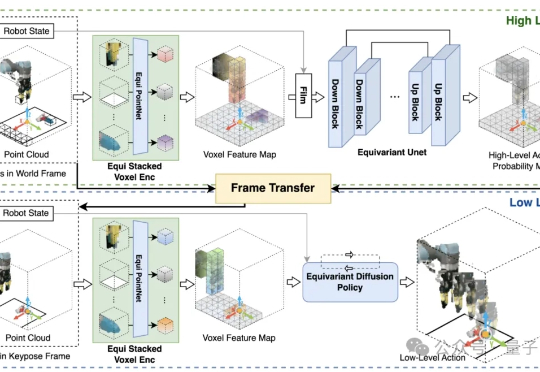

如何让AI像人一样,仅凭少量演示,就能稳健适应复杂多变的真实场景? 美国东北大学和波士顿动力RAI提出了HEP(Hierarchical Equivariant Policy via Frame Transfer)框架,首创“坐标系转移接口”,让机器人学习更高效、泛化更灵活。

大模型有苦恼,记性太好,无法忘记旧记忆,也区分不出新记忆!基于工作记忆的认知测试显示,LLM的上下文检索存在局限。在一项人类稳定保持高正确率的简单检索任务中,模型几乎一定会混淆无效信息与正确答案。

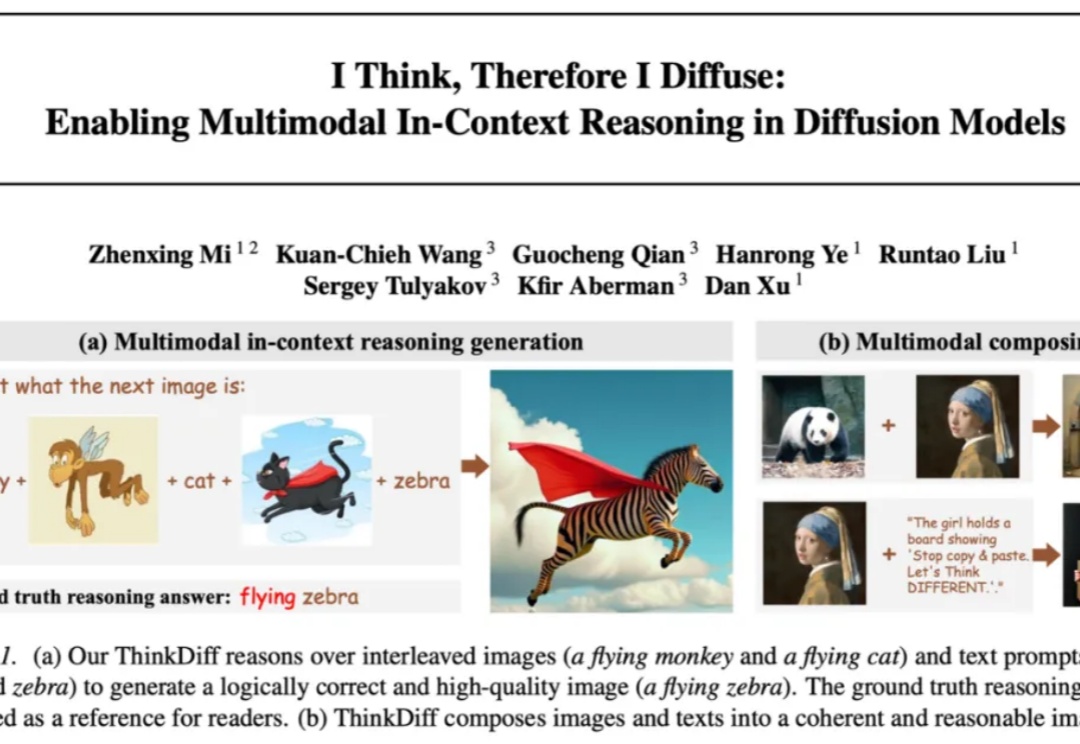

自 Stable Diffusion、Flux 等扩散模型 (Diffusion models) 席卷图像生成领域以来,文本到图像的生成技术取得了长足进步。但它们往往只能根据精确的文字或图片提示作图,缺乏真正读懂图像与文本、在多模 态上下文中推理并创作的能力。能否让模型像人类一样真正读懂图像与文本、完成多模态推理与创作,一直是学术界和工业界关注的热门问题。

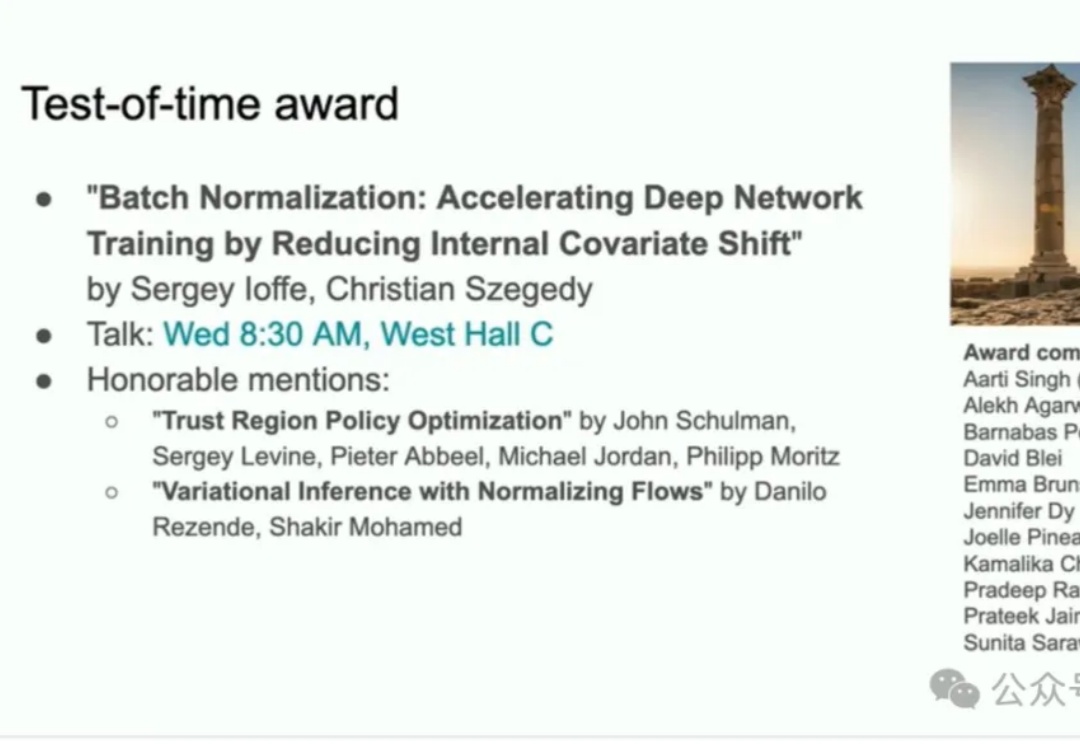

深度学习界的传奇论文,终于等来了它的“封神”时刻!

包括 6 篇杰出论文奖和 2 篇杰出立场论文奖。

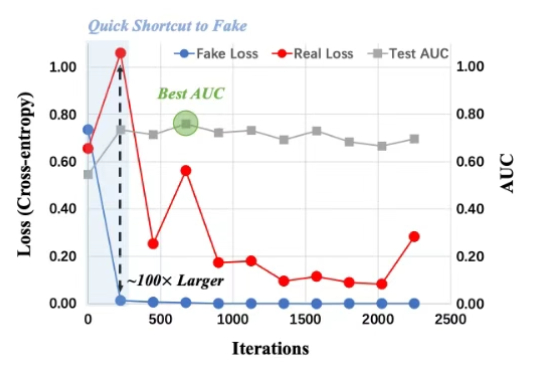

随着 OpenAI 推出 GPT-4o 的图像生成功能,AI 生图能力被拉上了一个新的高度,但你有没有想过,这光鲜亮丽的背后也隐藏着严峻的安全挑战:如何区分生成图像和真实图像?

您有没有遇到过这样的场景:为了调试一个LLM应用的效果,您需要在一大堆Python代码中翻找那些零散的提示词字符串?每次想要A/B测试不同的提示时,就像在做开颅手术一样小心翼翼。