无需大量标注也能理解3D!新研究登上ICLR 2025 Spotlight

无需大量标注也能理解3D!新研究登上ICLR 2025 Spotlight来自哥本哈根大学、苏黎世联邦理工学院等机构的研究人员,提出了一个全新的多模态Few-shot 3D分割设定和创新方法。无需额外标注成本,该方法就可以融合文本、2D和3D信息,让模型迅速掌握新类别。

来自哥本哈根大学、苏黎世联邦理工学院等机构的研究人员,提出了一个全新的多模态Few-shot 3D分割设定和创新方法。无需额外标注成本,该方法就可以融合文本、2D和3D信息,让模型迅速掌握新类别。

LLM一个突出的挑战是如何有效处理和理解长文本。就像下图所示,准确率会随着上下文长度显著下降,那么究竟应该怎样提升LLM对长文本理解的准确率呢?

什么,你在开发RAG竟然还没听说过Embedding模型还有排名?在AI应用开发热潮中,Embedding模型的选择已成为决定RAG系统成败的关键因素。然而,令人惊讶的是,许多开发者仍依靠直觉或跟风选择模型,而非基于系统化评估。

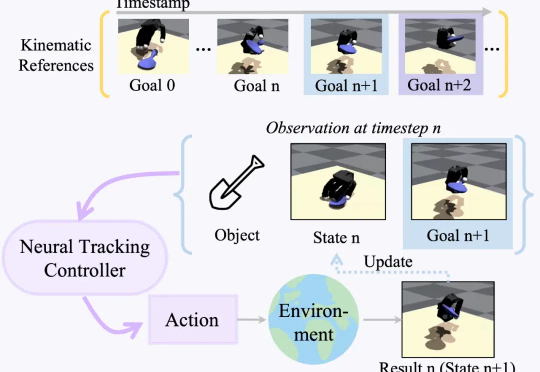

现实世界的机器人距离科幻小说里的机器人世界还有多远?通用灵巧操控何时才能实现?朝着这一伟大的目标,研究通用灵巧操控轨迹跟踪的 DexTrack 便应用而生。

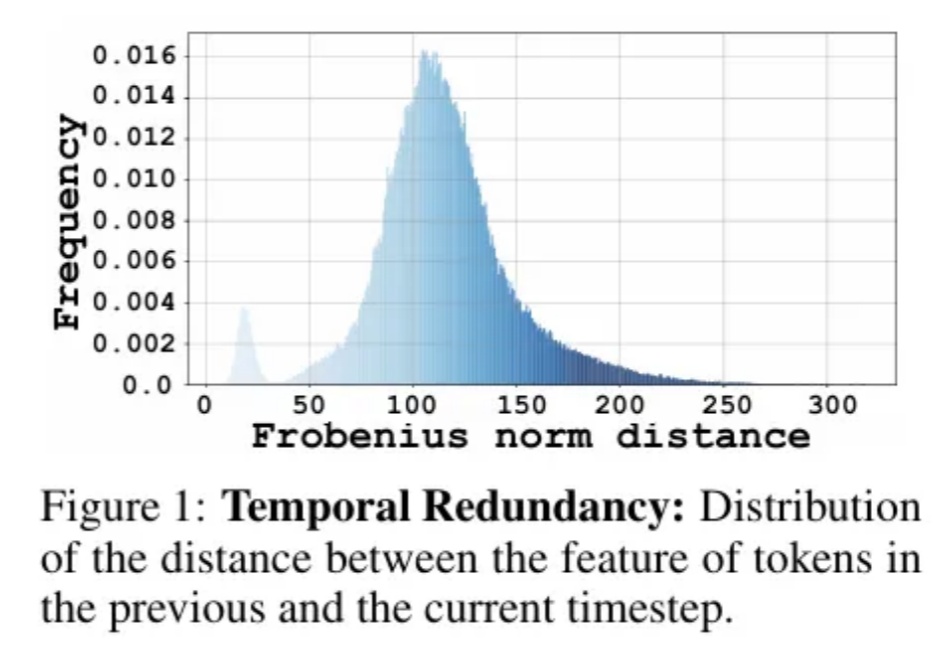

Diffusion Transformer模型模型通过token粒度的缓存方法,实现了图像和视频生成模型上无需训练的两倍以上的加速。

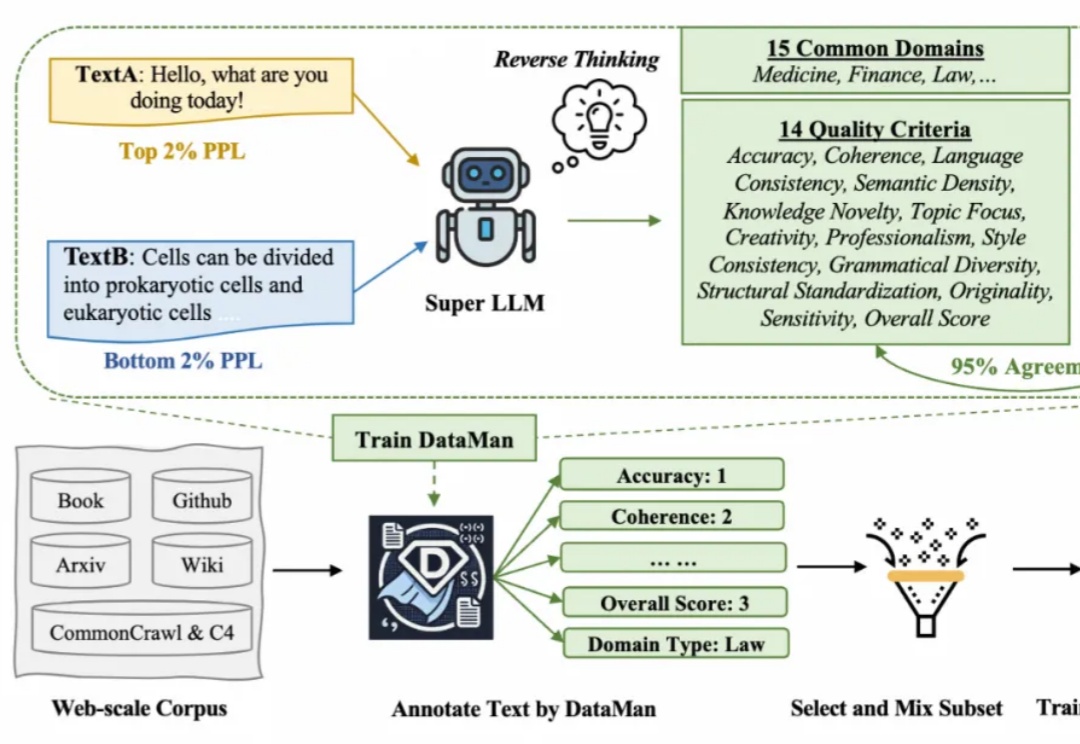

在 Scaling Law 背景下,预训练的数据选择变得越来越重要。然而现有的方法依赖于有限的启发式和人类的直觉,缺乏全面和明确的指导方针。在此背景下,该研究提出了一个数据管理器 DataMan,其可以从 14 个质量评估维度对 15 个常见应用领域的预训练数据进行全面质量评分和领域识别。

高效闭环控制是复杂系统控制的核心要求。传统控制方法受限于效率与适用性挑战;而新兴的扩散模型虽然表现出色,却难以满足高效闭环控制的要求。西湖大学研究团队最新提出的 CL-DiffPhyCon 框架,通过异步并行去噪技术,在闭环控制要求下,显著提升了控制效率和效果。论文最近被人工智能领域顶级会议 ICLR 2025 接收。

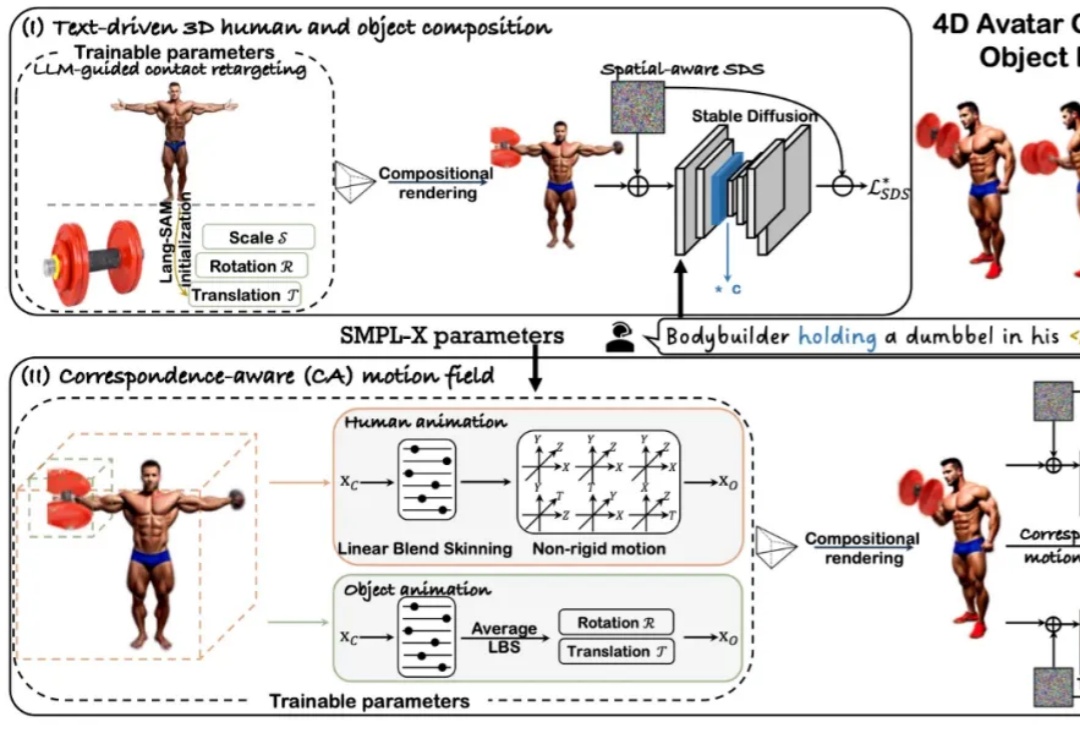

近年来,随着扩散模型和 Transformer 技术的快速发展,4D 人体 - 物体交互(HOI)的生成与驱动效果取得了显著进展。然而,当前主流方法仍依赖 SMPL [1] 这一人体先验模型来生成动作。

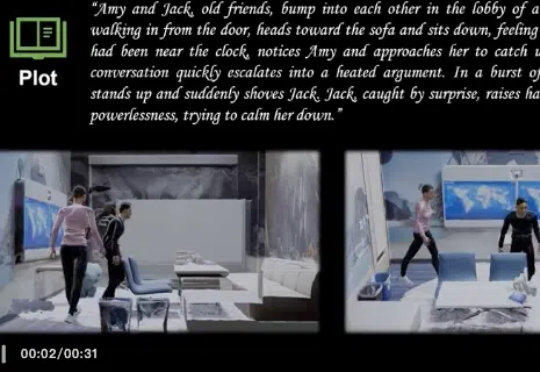

设定一个3D场景,你便可以用文字编织你的剧情。一句话,就能让两个人激烈争吵。来自北京航空航天大学、香港中文大学(深圳)、悉尼科技大学、中山大学等高校的研究者提出Sitcom-Crafter。成果已被ICLR 2025会议接收。

AI生成内容已深度渗透至生活的方方面面,从艺术创作到设计领域,再到信息传播与版权保护,其影响力无处不在。