马斯克疯了?AI 不拼技术拼脱衣,泰勒·斯威夫特又成受害者

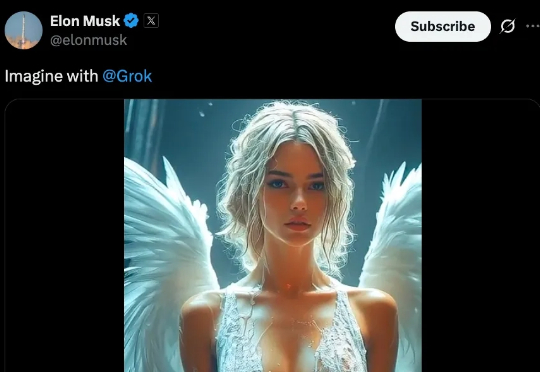

马斯克疯了?AI 不拼技术拼脱衣,泰勒·斯威夫特又成受害者一年前,X 还深陷泰勒·斯威夫特的深度伪造(Deepfake)不雅照风波中。一年后,它的老板马斯克,亲自为用户送来了生产这些「不雅照」的工具,并大肆宣传。xAI 的新功能 Grok Imagine,提供了一个名为「Spicy」的火辣模式,被媒体证实可以一键生成名人的部分裸露视频。

一年前,X 还深陷泰勒·斯威夫特的深度伪造(Deepfake)不雅照风波中。一年后,它的老板马斯克,亲自为用户送来了生产这些「不雅照」的工具,并大肆宣传。xAI 的新功能 Grok Imagine,提供了一个名为「Spicy」的火辣模式,被媒体证实可以一键生成名人的部分裸露视频。

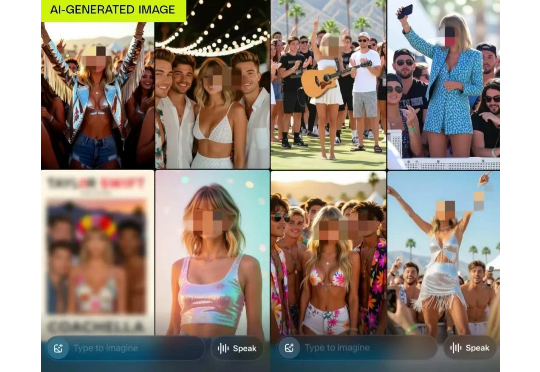

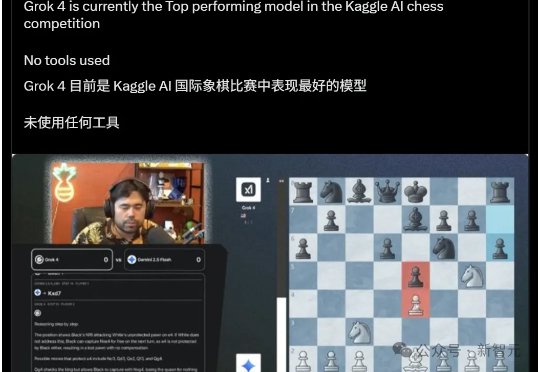

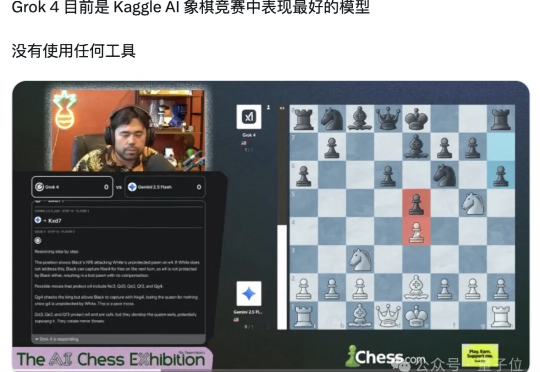

决赛前,它是沉默、精准、不可一世的冠军候选;决赛后,它成了连续送子、失误连连的背景板。Grok 4经历了从神坛到谷底的戏剧性一天,它的轰然倒塌,也成就了o3的不败王者神话。

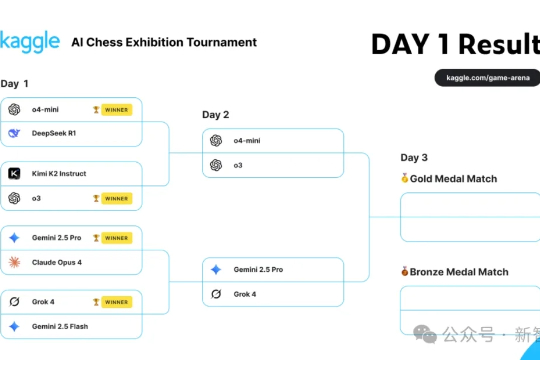

备受 AI 圈关注的首届谷歌 Kaggle AI Chess 大赛(也即大模型国际象棋对抗赛)迎来了最终赢家。就在昨天,Grok 4 携手 OpenAI o3 进入了决赛。在机器之心的投票中,大家更倾向于 o3 战胜 Grok 4。

明天,Grok 对阵 OpenAI 的 o3。 谁也没想到,谷歌攒的 Kaggle AI Chess 比赛(即大模型国际象棋对抗赛),在半决赛中,Grok 4 击败 Gemini 2.5 Pro,进入总决赛!

第二轮首届大模型对抗赛结果出炉了!o3轻而易举击败o4-mini,拿下100%胜率。Grok 4和Gemini 2.5 Pro激烈对决,最终在加赛中Grok 4成功晋级。明日,Grok 4和o3将迎来终局之战。

AI国际象棋对抗?这次玩真的!谷歌Kaggle推出首届全球AI象棋争霸赛,八款顶级语言模型正面对抗,胜负只在一步之间!

最新战报最新战报:首届AI国际象棋对战……马斯克家的Grok 4“遥遥领先”了。 是的,谷歌给大模型整了个国际象棋比赛:Kaggle AI象棋竞赛。

从目前战况来看,Grok 4 是夺冠热门。 在玩游戏方面,到底哪个模型最厉害?为了回答这个问题,谷歌近日发起了首届大模型国际象棋对抗赛。

8 月 4 日凌晨,马斯克旗下 xAI 正式向付费用户推出 Grok Imagine,可以用文字生成图像,然后将图一键变成 AI 视频。 短短 24 小时,Grok Imagine 用户使用量据称达数千万次。惊人的速度背后,是「允许擦边」的「Spicy Mode(火辣模式)」,让这款 AI 视频生成功能成为全网最具争议的新物种。

今天凌晨,马斯克再放大招更新Grok App。AI短视频30秒一键生成,真面对决谷歌Veo 3。刚刚,马斯克宣布:Grok Imagine今天开始向所有Grok Heavy用户推出。Grok iOS App升级,Imagine功能重磅升级!