韩国两大AI芯片公司谋求合并,英伟达迎来新挑战者

韩国两大AI芯片公司谋求合并,英伟达迎来新挑战者分头作战,不如选择抱团?

来自主题: AI资讯

10385 点击 2024-06-13 10:51

分头作战,不如选择抱团?

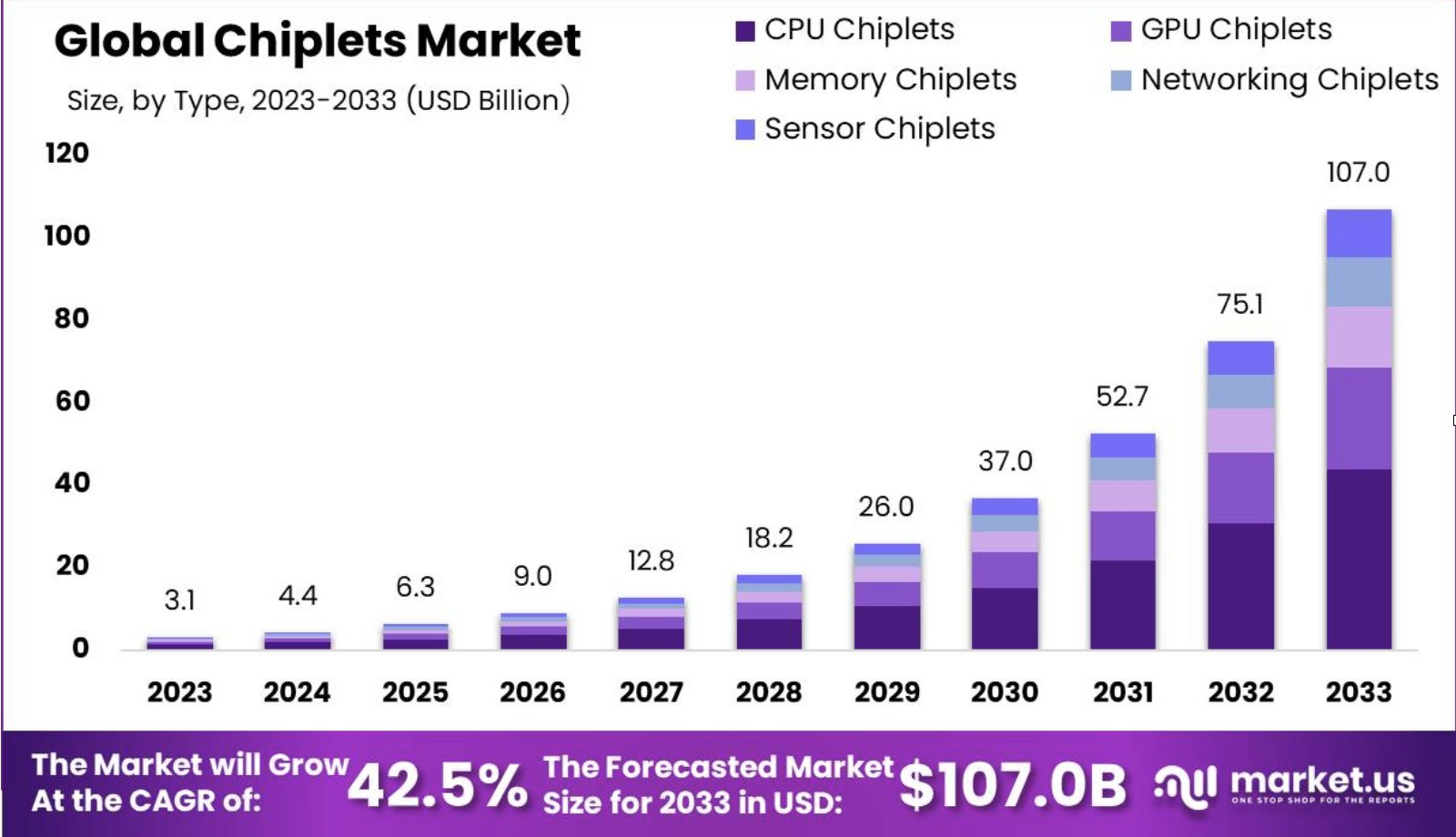

近日,「北极雄芯」宣布完成新一轮融资,引入云晖资本。本次融资资金将主要用于首批核心Chiplets流片及封装测试,构建国内首个可独立销售的“Chiplet产品库”。

都是可选择的一环

一年一代,展现AI领域"芯"速度

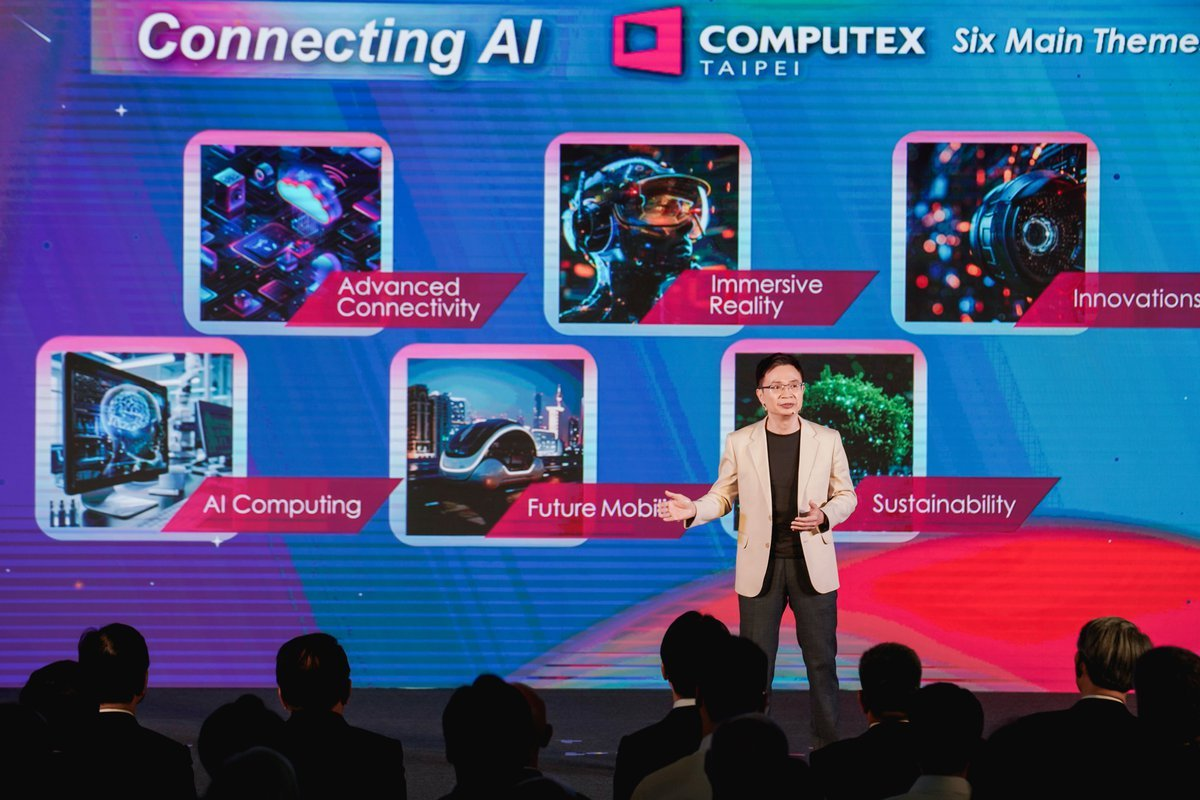

为期三天的2024年台北电脑展(Computex 2024),6月7日已落下帷幕。在这一次的展会上,AI成为贯穿一切的主题。英伟达、AMD、英特尔、高通等芯片大厂的话事人们纷纷做了主题演讲,也让这次展会的参与人数比上一届暴涨了 80%。

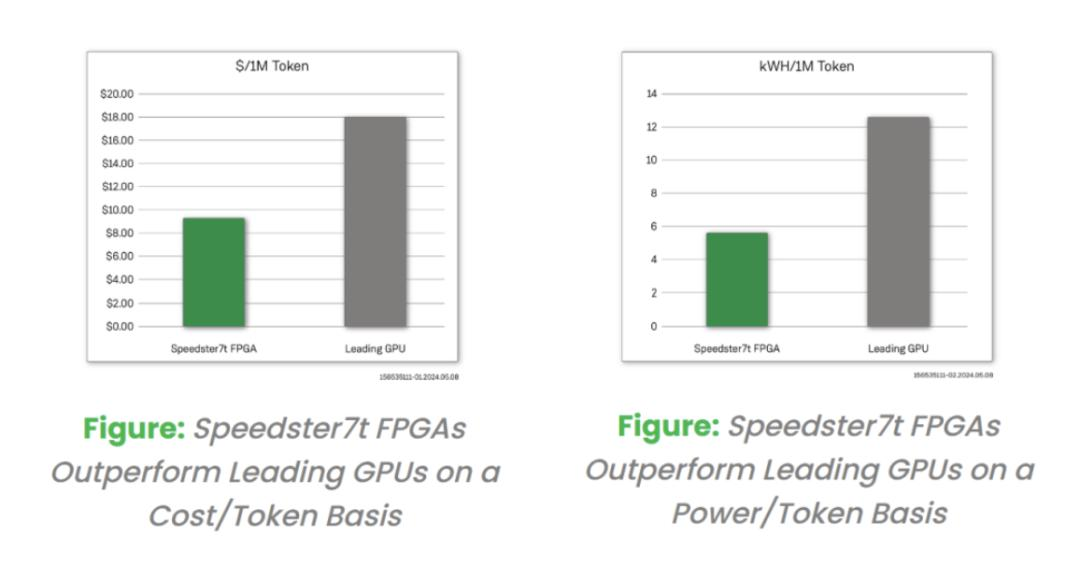

如何制服AI吞电兽?

AI算力资源越发紧张的当下,斯坦福新研究将GPU运行效率再提升一波——

马斯克:到年底算力将拥有8.5万块H100

你方唱罢我登场。

AI PC市场将迎来一场恶战。2024 台北电脑展,各家大厂都铆足了劲,尤其是英伟达、AMD、高通以及英特尔这几家。昨天,也就是 2024 台北电脑展前夜,英伟达率先举办了首场主题演讲,但这场演讲的内容与消费者的直接关系并不大,更多还是关于之前发布的 Blackwell GPU,Omniverse 和数字孪生技术。