放弃博士学位加入OpenAI,他要为ChatGPT和AGI引入记忆与人格

放弃博士学位加入OpenAI,他要为ChatGPT和AGI引入记忆与人格今天,一位研究者加入 OpenAI 的消息吸引了很多人的关注。

今天,一位研究者加入 OpenAI 的消息吸引了很多人的关注。

AI两天爆肝12年研究,精准吊打人类!多大、哈佛MIT等17家机构联手放大招,基于GPT-4.1和o3-mini,筛选文献提取数据,效率飙3000倍重塑AI科研工作流。

在人工智能领域,ChatGPT 作为 OpenAI 推出的聊天机器人一直以其强大的文字生成能力受到关注。然而近期一项独特的实验显示,当 ChatGPT 与一款诞生于 1977 年(48 年前)的经典游戏机雅达利 2600(Atari 2600)对弈国际象棋时,却遭遇了意想不到的失败。

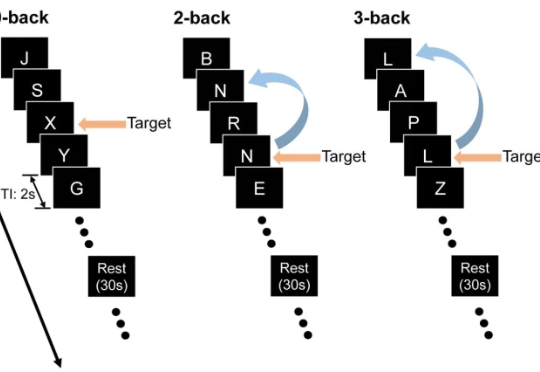

最近,来自约翰・霍普金斯大学与中国人民大学的团队设计了三套实验,专门把关键线索藏在上下文之外,逼模型「凭记忆」作答,从而检验它们是否真的在脑海里保留了信息。

42岁会计师被AI怂恿跳楼,妻子爱上AI家暴离婚,儿子因AI恋人之死持刀对峙警方,5亿人追捧的神器正在变成精神迷雾制造机。当算法学会无限迎合,我们离「皇帝的新LLM」还有多远?

Landbase 践行着Daniel Saks (萨克斯)称之为"氛围感市场进入"的策略,利用 AI 实现营销触达自动化。本周该公司宣布完成 3000 万美元 A 轮融资,由 Sound Ventures 与现有投资者 Picus Capital 共同领投,8VC、A*和 Firstminute Capital 等既有投资方跟投。

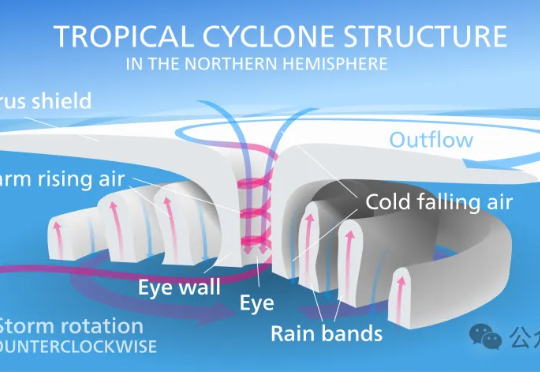

昨天,谷歌DeepMind与谷歌研究团队正式推出交互式气象平台Weather Lab,用于共享人工智能天气模型。在热带气旋路径预测方面,谷歌这次的新模型刷新SOTA,是首个在性能上明确超越主流物理模型的AI预测模型。

Transformer已满8岁,革命性论文《Attention Is All You Need》被引超18万次,掀起生成式AI革命。Transformer催生了ChatGPT、Gemini、Claude等诸多前沿产品。更重要的是,它让人类真正跨入了生成式AI时代。

4月份,李飞飞教授领先编制的《2025年人工智能指数报告》提供的数据显示,2024年全年具有特殊影响力的模型(Notable AI models)当中,排名前5的几乎都来自美国、中国的科技巨头。

积木与算法碰撞,美泰在玩具箱里藏了一颗AI心脏。美东时间6月12日,一则看似寻常的商业合作消息在科技与玩具行业掀起涟漪:芭比娃娃制造商美泰宣布与OpenAI达成战略合作,共同开发人工智能玩具和游戏,并预计今年晚些时候推出首款AI产品。