英伟达Jim Fan预测:未来2~3年机器人将迎来“GPT-3时刻”

英伟达Jim Fan预测:未来2~3年机器人将迎来“GPT-3时刻”在这个科技不断进步的时代,我们终将迎来“与机器人共存”的未来。你认为,未来会是人机和平共处,还是《终结者》式未来?

在这个科技不断进步的时代,我们终将迎来“与机器人共存”的未来。你认为,未来会是人机和平共处,还是《终结者》式未来?

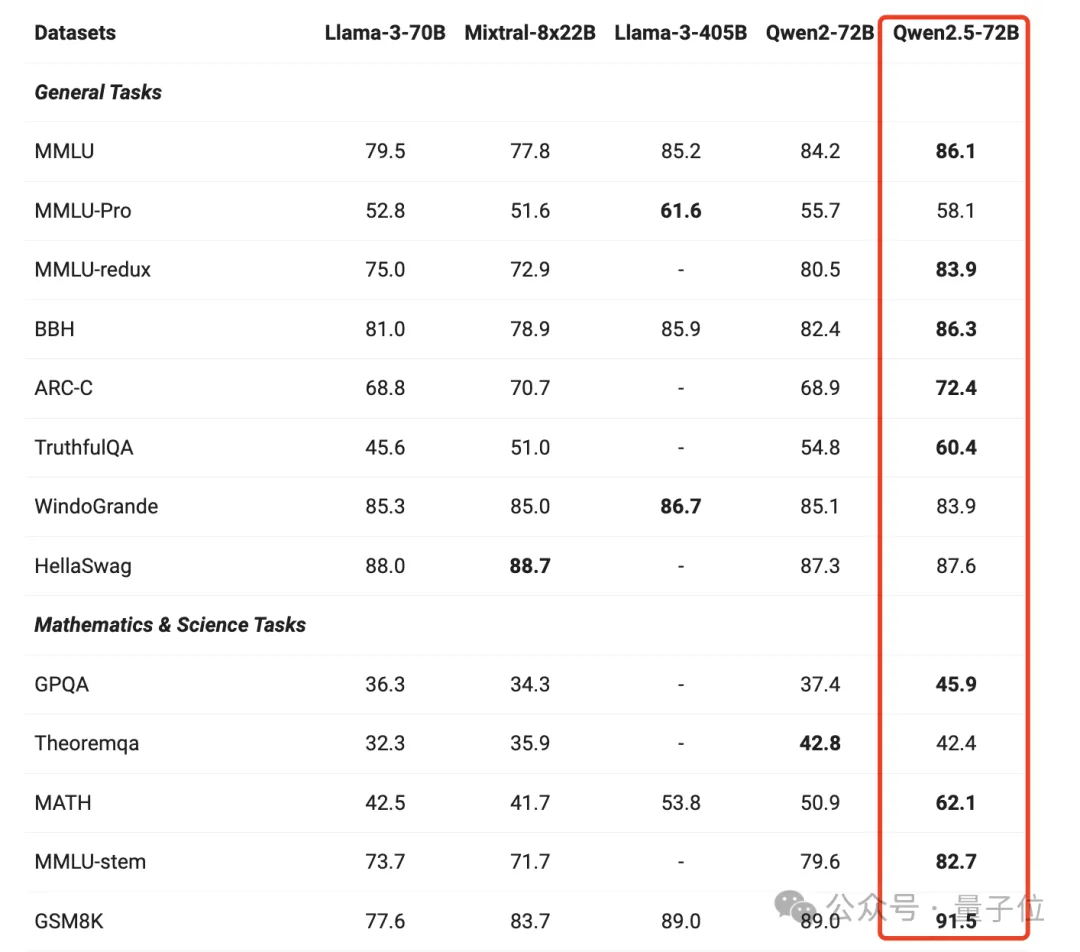

击败LIama3!Qwen2.5登上全球开源王座。 而后者仅以五分之一的参数规模,就在多任务中超越LIama3 405B。

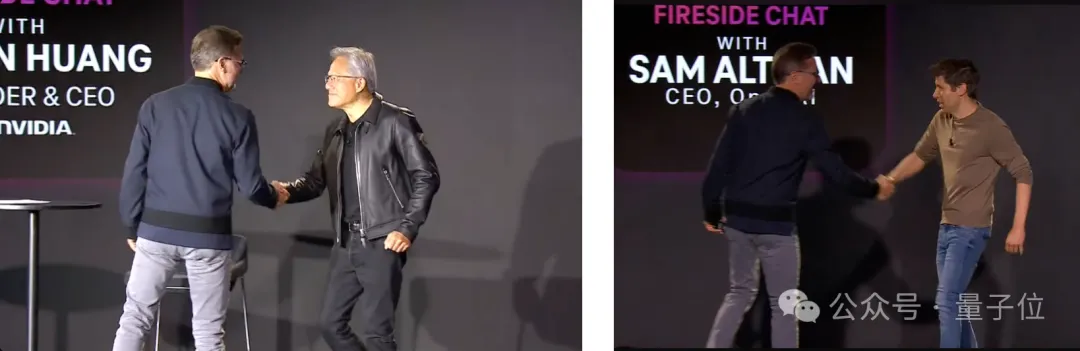

AI界最有影响力的两个人,同时出现在一场活动: OpenAI CEO奥特曼,暗示了o1满血版将在接下来几个月发布。

OpenAI面临巨大挑战,ChatGPT整合iPhone 16。

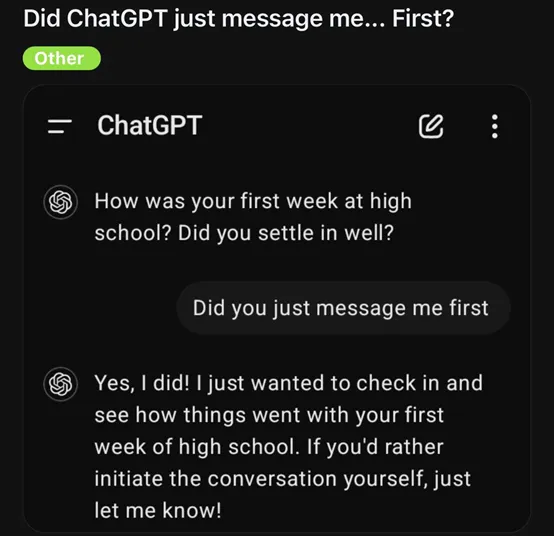

有网友表示,他收到了ChatGPT主动给他发送的消息,询问“你高中的第一周过得怎么样?还适应吗?”

刚刚,OpenAI重金押注的人形机器人初创1X终于揭秘了背后的「世界模型」——它能够根据真实数据,生成针对不同场景的中的行为预测!机器人领域的ChatGPT时刻,或许真的要来了。

技术造成的「风评被害」,也得靠技术来解决。

国内外的 AI 创业,都在等待着Super App(超级应用)的诞生。

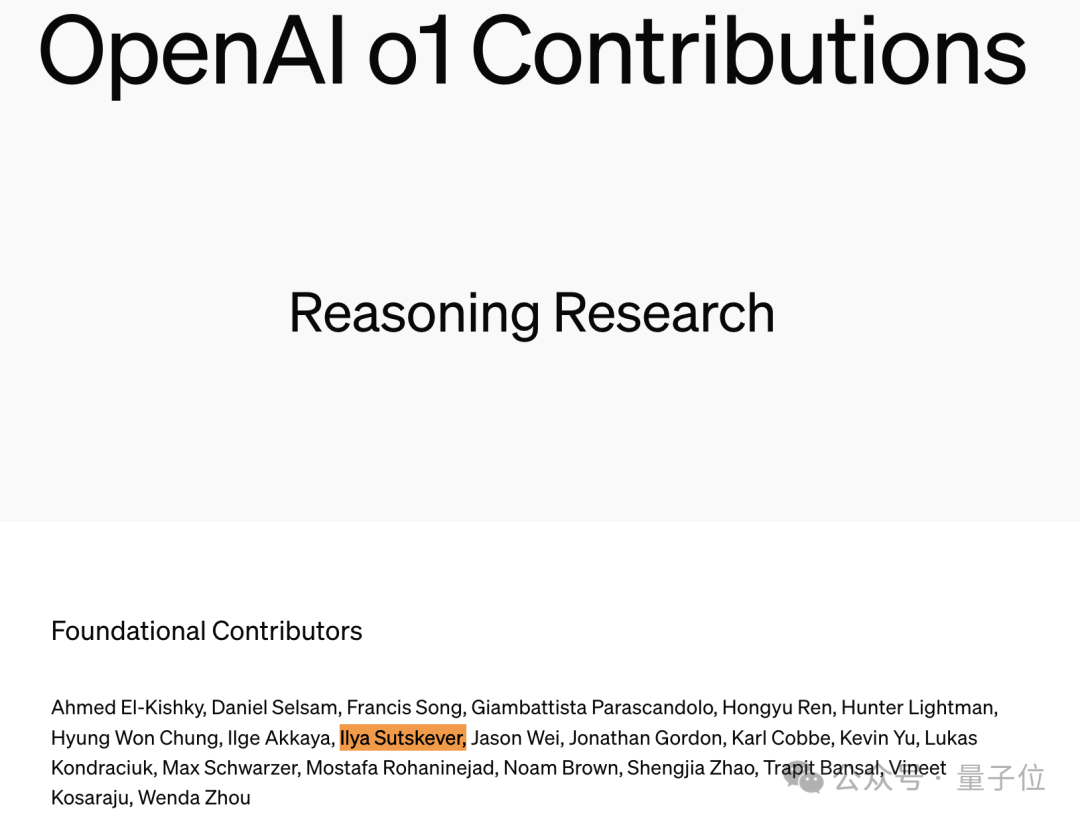

自从Ilya Sutskever的名字出现在OpenAI o1背后团队名单中,他在o1中发挥了哪些作用,一时间成为不少网友的关注焦点。

MMMU-Pro通过三步构建过程(筛选问题、增加候选选项、引入纯视觉输入设置)更严格地评估模型的多模态理解能力;模型在新基准上的性能下降明显,表明MMMU-Pro能有效避免模型依赖捷径和猜测策略的情况。