GPT-4惨遭削弱,偷懒摸鱼绝不多写一行代码,OpenAI已介入调查

GPT-4惨遭削弱,偷懒摸鱼绝不多写一行代码,OpenAI已介入调查有网友想在Android系统开发一个能够与OpenAI API实时交互的应用。于是把方法示例链接发给GPT-4,让它参考用Kotlin语言编写代码。

有网友想在Android系统开发一个能够与OpenAI API实时交互的应用。于是把方法示例链接发给GPT-4,让它参考用Kotlin语言编写代码。

来自中国科学院深圳先进技术研究院、中国科学院大学和 VIVO AI Lab 的研究者联合提出了一个无需训练的文本生成视频新框架 ——GPT4Motion。GPT4Motion 结合了 GPT 等大型语言模型的规划能力、Blender 软件提供的物理模拟能力,以及扩散模型的文生图能力,旨在大幅提升视频合成的质量。

由南洋理工华人团队新提出的80亿参数多模态大模型OtterHD,不仅可以搞定让GPT-4V都发愁的难题,甚至还可以数出来《清明上河图》(局部)里到底有多少只骆驼!

比尔·盖茨一句爆料,成为机器学习社区热议焦点: “GPT-5不会比GPT-4好多少。”

我们都知道,大语言模型(LLM)能够以一种无需模型微调的方式从少量示例中学习,这种方式被称为「上下文学习」(In-context Learning)。这种上下文学习现象目前只能在大模型上观察到。比如 GPT-4、Llama 等大模型在非常多的领域中都表现出了杰出的性能,但还是有很多场景受限于资源或者实时性要求较高,无法使用大模型。

该篇文章是一位中国开发者对其开发的AI女友产品的失败总结。他通过讨论产品的开发过程、用户反馈以及经济压力等方面,总结了自己的教训和困惑。

AGI 到底离我们还有多远?在 ChatGPT 引发的新一轮 AI 爆发之后,伯克利和香港大学的马毅教授领导的一个研究团队给出了自己的最新研究结果:包括 GPT-4 在内的当前 AI 系统所做的正是压缩。

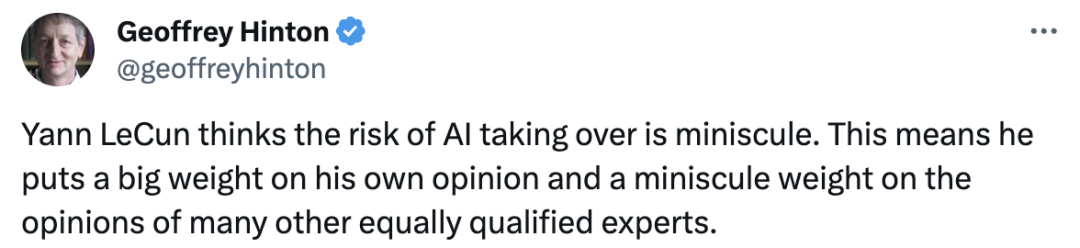

大模型能否理解自己所说,Hinton和LeCun再次吵起来了。LeCun新论文证明,GPT-4回答问题准确率仅为15%,自回归模型不及人类。AI大佬的激战再次掀起。Hinton在线直接点名LeCun,说他对AI接管风险的看法对人类的影响微乎其微。 这意味着,他把自己的意见看得很重,而把许多其他同样有资格的专家的意见看得很轻

最新发布的AI模型Inflection-2在各项基准测试中表现出色,仅次于OpenAI的GPT-4,但性能超越了谷歌和Meta的主流替代方案。Inflection-2的参数量达到1750亿,被认为是当今世界上第二强的大模型。

月初刚测了GPT-4 Turbo上下文真实实力的大神Greg Kamradt又盯上了Anthropic刚更新的Claude 2.1。他自己花了1016刀测完之后显示,Claude 2.1在上下文长度达到90K后,性能就会出现明显下降。