超越GPT-4,Claude 3超大杯成新王!

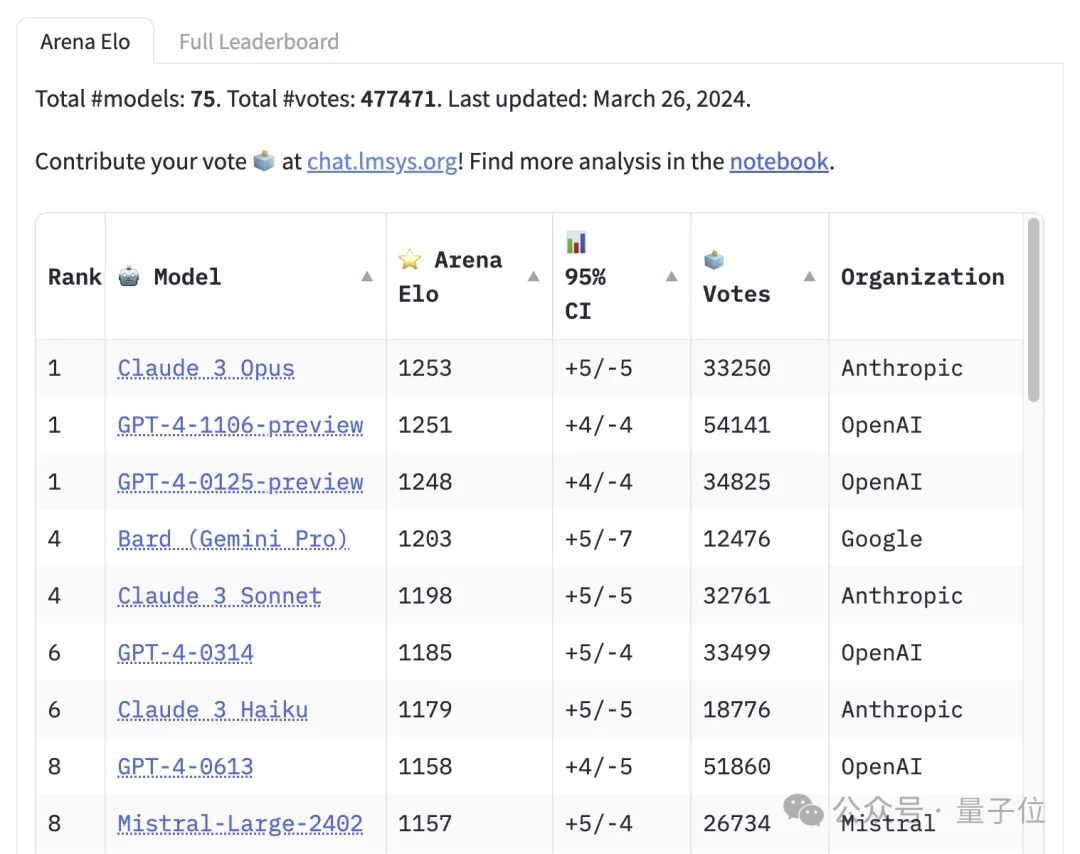

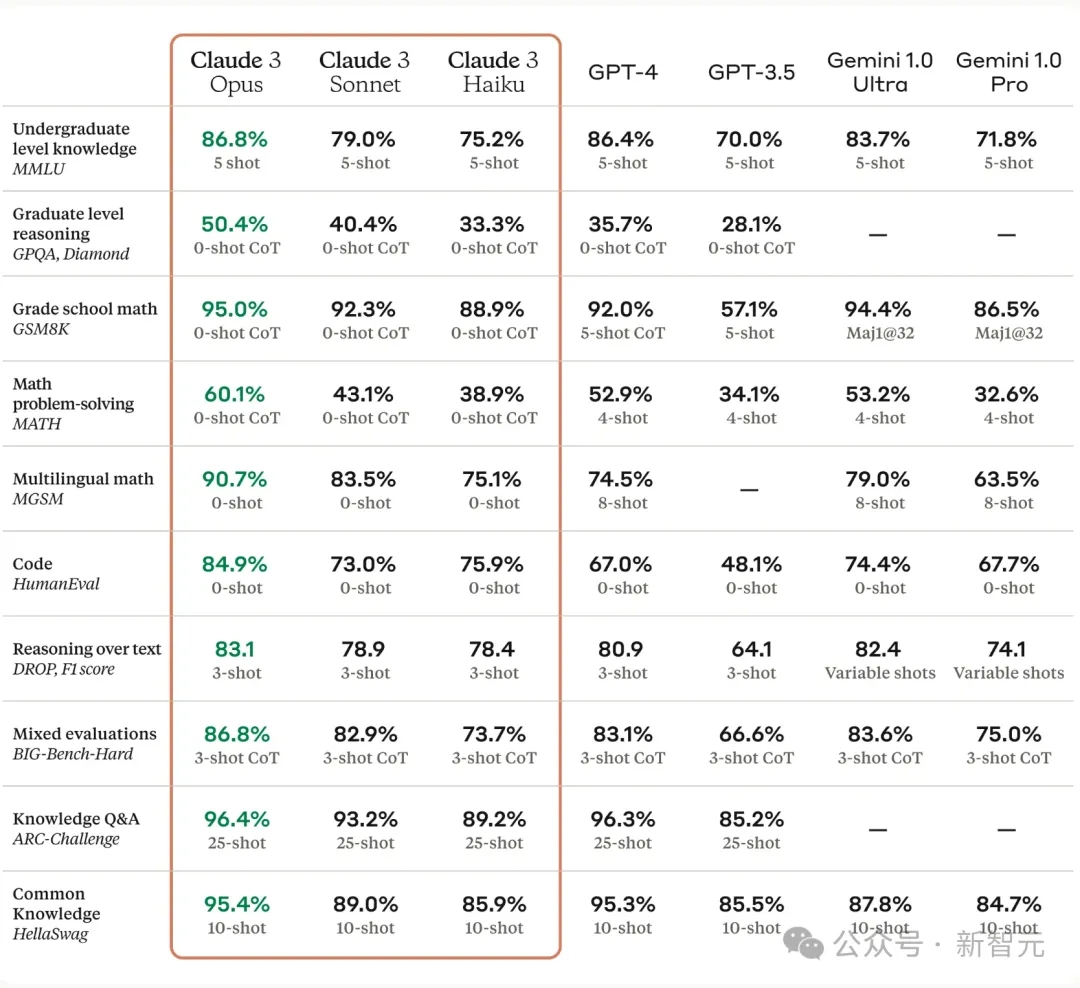

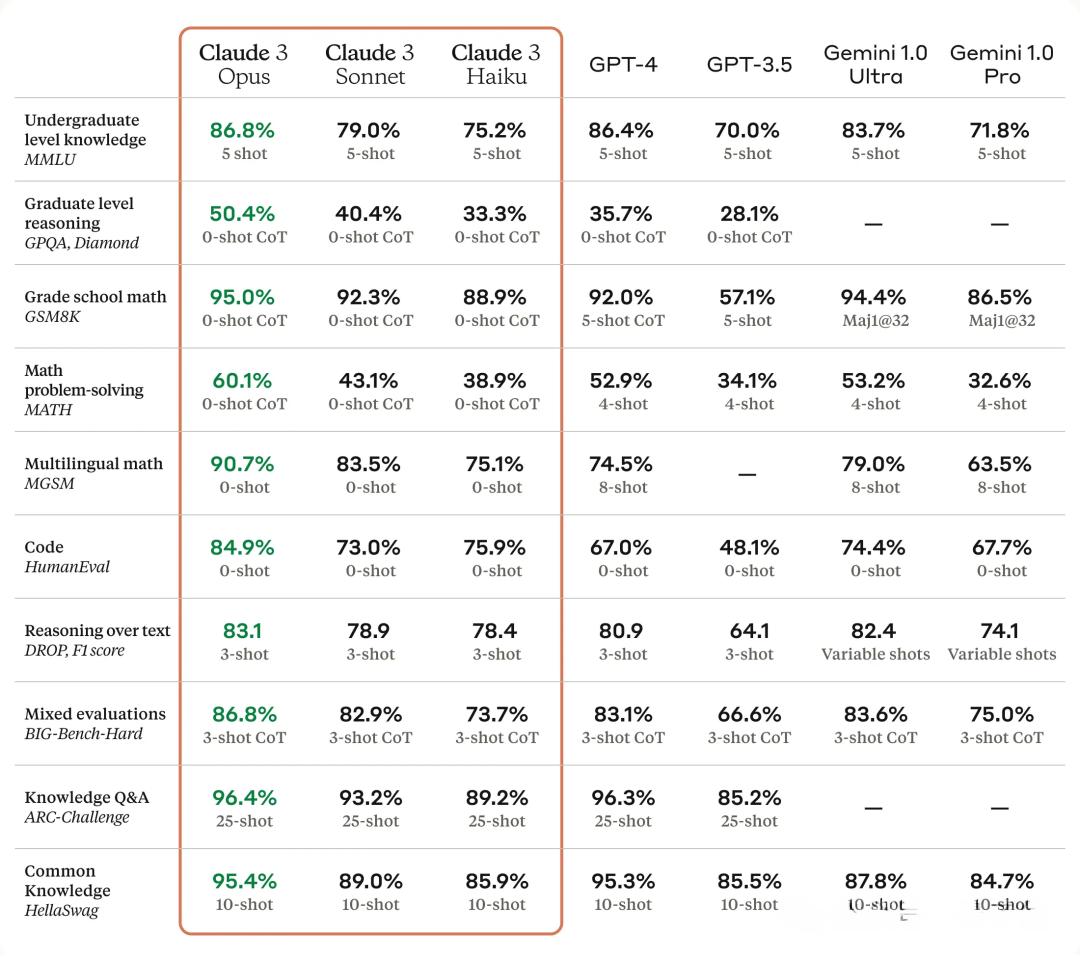

超越GPT-4,Claude 3超大杯成新王!太疯狂了!Claude 3 Opus竟然干掉了GPT-4。在Chatbot Arena最新的聊天机器人对战排行榜中,Claude 3的超大杯成功登顶,就连最小的Claude 3 HaiKu都达到了GPT-4水平!

太疯狂了!Claude 3 Opus竟然干掉了GPT-4。在Chatbot Arena最新的聊天机器人对战排行榜中,Claude 3的超大杯成功登顶,就连最小的Claude 3 HaiKu都达到了GPT-4水平!

GPT-4真的被反超了!大模型竞技场上,Claude 3大杯Opus新王登基,Elo分数来到榜首。

基于案例的推理助力大模型智能体挑战自动化数据科学任务,吉大、上交和汪军团队发布专注于数据科学的智能体构建框架 DS-Agent。

这一专属于智慧生物的独特性,也要被人工智能(AI)学会了?发散性思维(divergent thinking)被认为是创造性思维的核心指标,是人类创造性的体现。

Claude 3不但数据集跑分领先,用户体验上也将成为最强大的LLM,GPT-5在哪里?

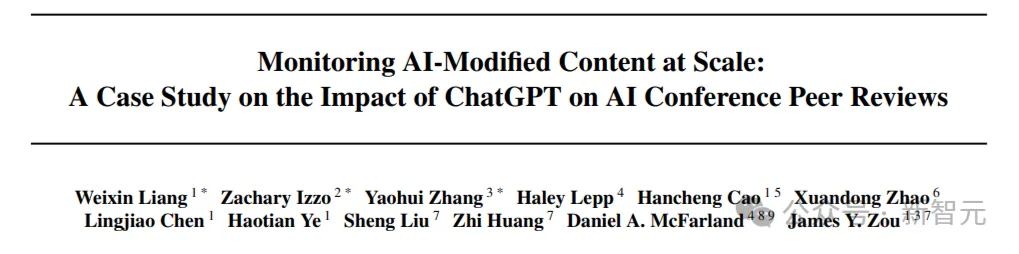

斯坦福的一篇案例研究表示,提交给AI会议的同行评审文本中,有6.5%到16.9%可能是由LLM大幅修改的,而这些趋势可能在个体级别上难以察觉。

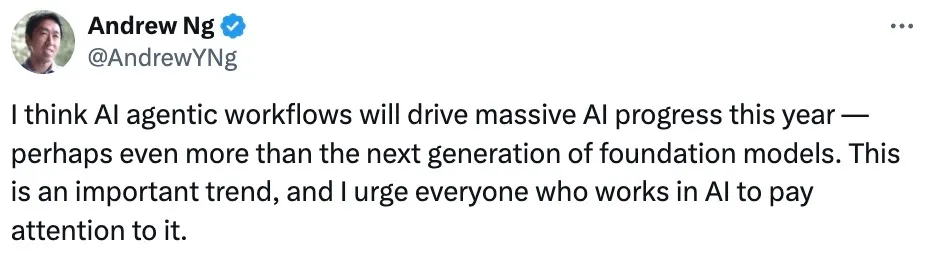

下一步是智能体?随着 ChatGPT、GPT-4、Sora 的陆续问世,人工智能的发展趋势引起了广泛关注,特别是 Sora 让生成式 AI 模型在多模态方面取得显著进展。人们不禁会问:人工智能领域下一个突破方向将会是什么?

微软 AI 大计的最后一块拼图完成了?把 Copilot 按钮放在 Windows 桌面的任务栏,甚至实体键盘上,用大模型提升每个人的生产效率。美东时间 3 月 21 日周四,生成式 AI 领军的微软又为我们带来了一点小小的震撼。

国产大模型独角兽送福利来了,千万token免费用!最近,零一万物API正式开放,三款模型都非常能打,开发者们赶快来开箱吧。零一万物API开放平台,正式向开发者开放了!

Claude3凭什么这么强?春天到了,和万物一起竞发的,还有愈发火热的AI。自2月以来,国外头部AI企业大招连出,纷纷推出了一系列强大的AI模型或技术。除了在AI圈刷屏刷到爆的Sora以外,另一匹黑马Claude 3也在三月份杀出,直接夺取了GPT-4最强大模型的地位。